时间多久了,正常会等下次刷新的时候才会更新,如果时间较久,建议看看 prometheus 的配置文件,看是否还有相关 tikv 节点信息

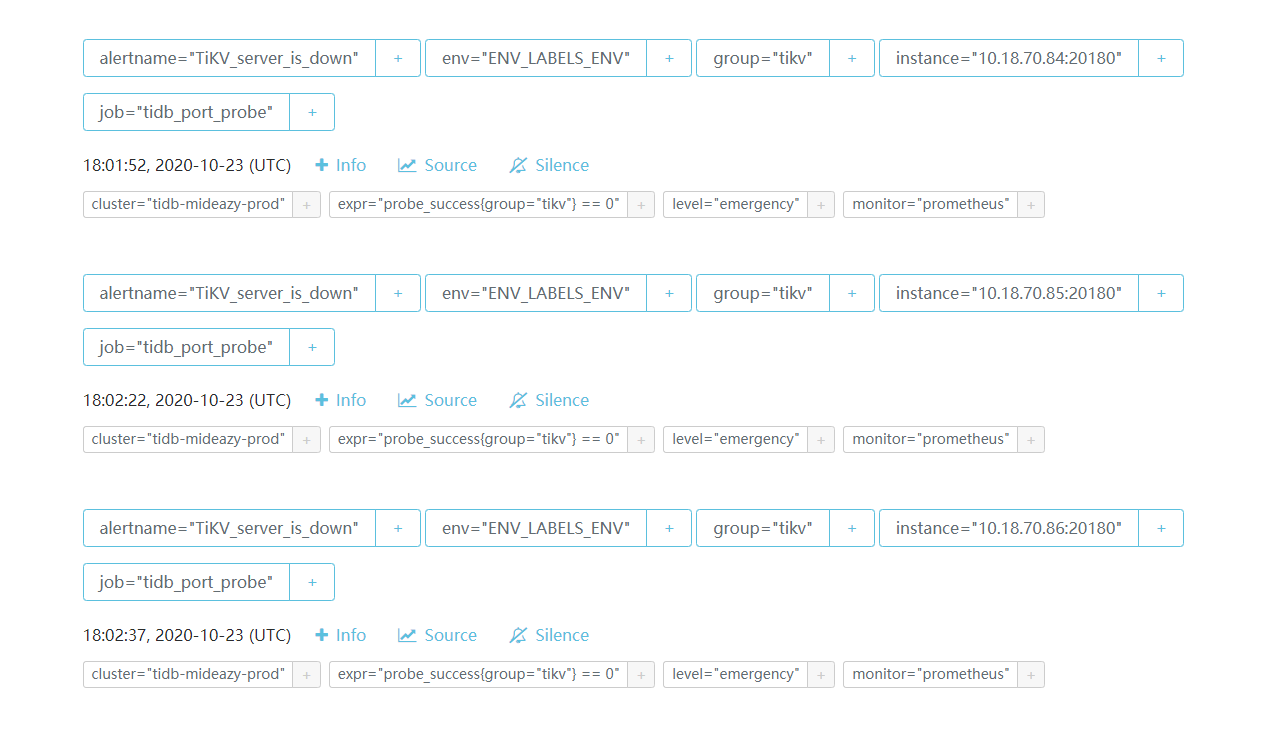

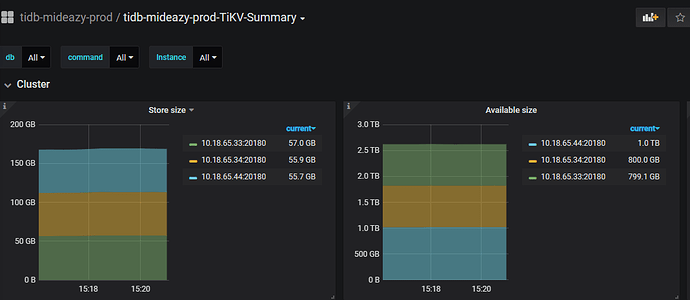

promethues里面是有已经缩容后踢掉的3台主机的ip信息。。

已经过去2天了 数据还是有。。 要如何修改那个配置文件去重启prometheus。

还有建议启动prometheus的脚本加上 --web.enable-lifecycle这个配置才支持热加载。

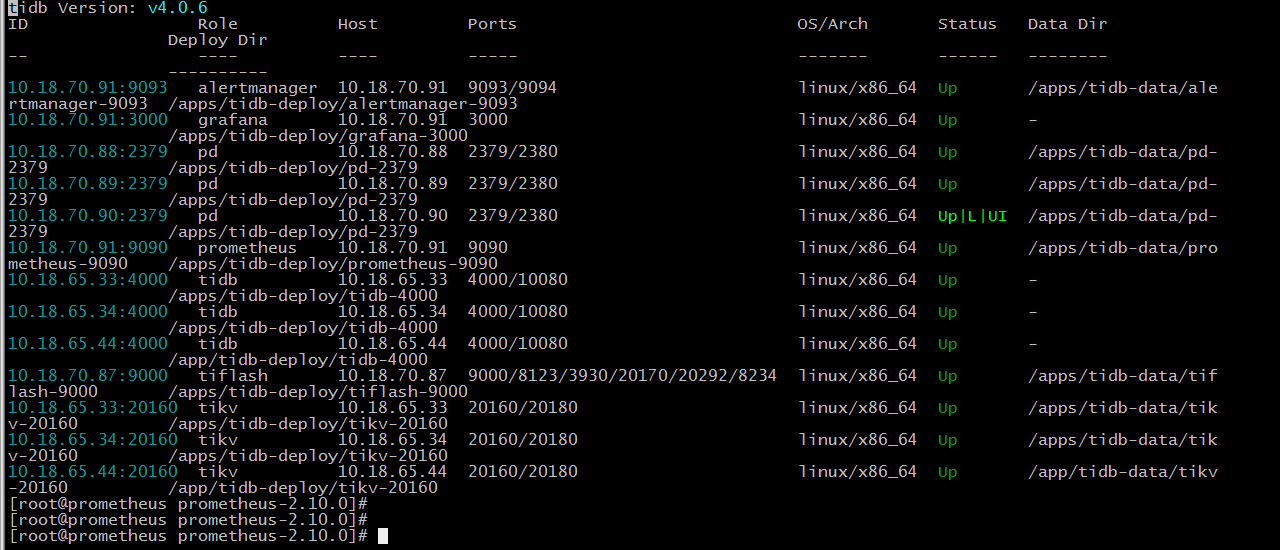

请用 tiup cluster display 展示下目前集群情况。正常 tiup 缩容后是会将相关信息进行清理的。

可以检查下 已经缩容的 3 台 tikv ,目前缩容后 会在原服务器上遗留 node_export 和 blackbox 2 个 tidb cluster 相关的 监控服务 。可以手动关停相关 service

那prometheus里面的那些旧主机信息 是不是也要手工自行清理?

缩容的3台机器是要直接下线的~~~ 那些残存的服务可以手工清理掉,但是监控prometheus的配置文件 里面的旧主机信息 这块才是我关注的

正常情况 tiup 在缩容后会对相关配置进行修改。

如果现在 /conf/prometheus.yml 有相关配置信息

可以通过 tiup cluster reload {cluster_name} -R prometheus

对 prometheus 相关配置进行重置+ restart