【 TiDB 使用环境】

【概述】:场景 + 问题概述

TIUP 部署的

TIDB 版本是5.4

监控发现集群负载不均衡

这个是tidb节点还是tikv节点的监控,上层负载均衡是用的haproxy还是其他的

这是我整个集群的监控,另外配置的一个模板,用TIUP部署好没有做负载均衡的操作。

cpu使用率分别是87%,24%,88的这三台机器分别是什么节点呢,如果tidb server上层没有负载均衡的话,是直连的一台吗。

补充下情况描述吧,

楼上说的对,你必须告诉我们是什么节点负载不均衡

三台机器分别的节点是TIDB PD KV 都是一个实例,是直连一胎的

不好意思,想的没这么周到,需要什么信息我第一时间回复

pd ,tidb,tikv分工不一样,资源使用率不一样正常。一般资源使用不均衡指的是多个tidb节点之间不均衡,或者多个tikv节点不均衡。对于tidb这种分布式数据库来说不能比较不同类型的节点资源使用率。

但是我每台服务器都是 一个 tidb 一个 tikv 一个 pd,按道理是比较均衡的吧。。

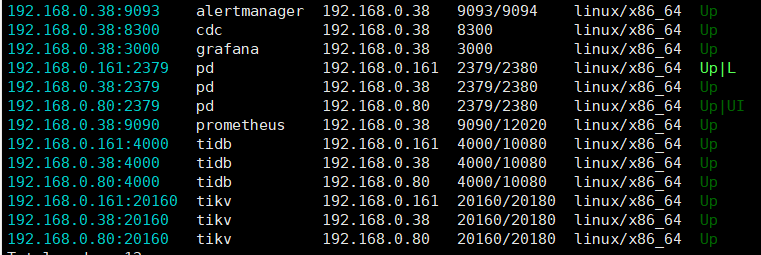

可能我理解错了,发下集群拓扑结构吧

混合部署么?硬件配置是否是按照官方的推荐的?

混合部署是有最佳实践的,你可以参考下,然后在做些调整,会好一点的

硬件配置KV少了四核

38:altermanager cdc grafa prometheus tidb tikv

80: pd tidb tikv

161: pd(leader) tidb tikv

本身部署的不均衡,而且直连一个tidb节点,没法保障整体资源均衡。

生产环境建议还是按照官方的推荐配置,不然性能可能达不到预期。

分开连接会好一点吗?38我配置高一点,8核 64G

可能的几个方向:

1.应用访问tidb不均衡,评估增加ha proxy是否缓解

2.热点访问,查看grafana-pd-hot write或者hot read排查

3.IO能力不足,造成较大io wait,查看io相关监控

直连一个tidb节点的话,其他两个节点的作用是啥呢![]()

负载上可以加权重

我没做负载。。。

你是不是说你有台配置要高一些么