【 TiDB 使用环境】

【概述】:场景 + 问题概述

centos7.5 + tidbv4.0.13

【背景】:做过哪些操作

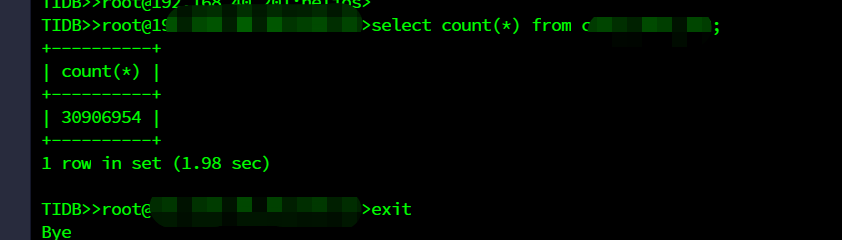

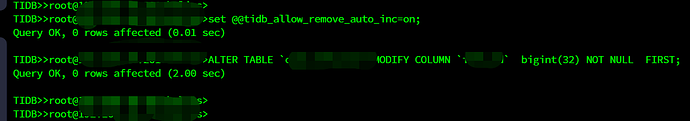

3000万条数据的表,主键变更,去掉auto_increment属性,集群报了很多错,操作如下:

【现象】:业务和数据库现象

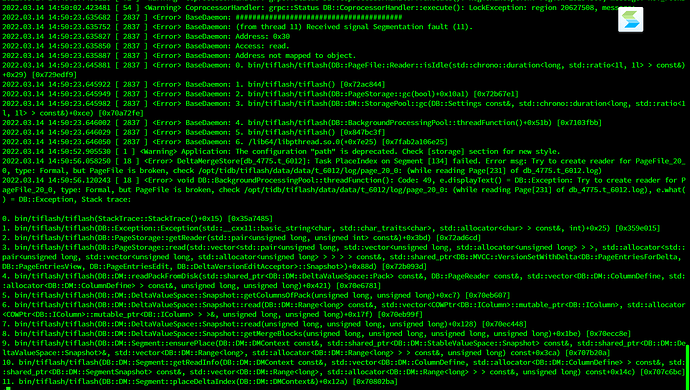

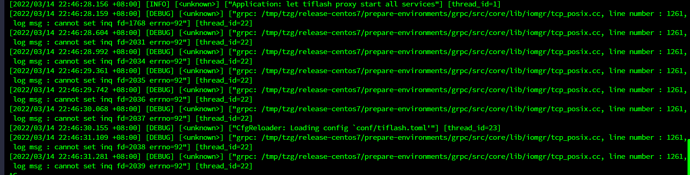

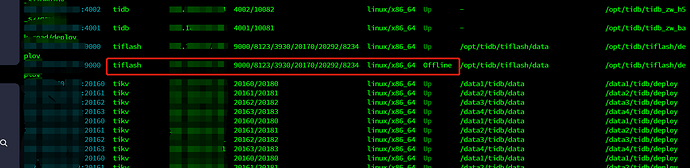

tiflash一个节点挂了

生产tikv触发了很多告警,比如:

TiKV_Follower远远落后于Leader

TiKV_无法连接远端的TiKV

TiDB访问TiKV时发生了Region错误,10分钟内大于6000

【问题】:当前遇到的问题

tiflash挂了

集群一直告警

【业务影响】:

目前正常,但是一直告警,tiflash有个两个服务器,一个正常,另一个一直重启

【TiDB 版本】:

v4.0.13

【附件】:

- 相关日志

- 配置文件

- Grafana 监控(https://metricstool.pingcap.com/)