为提高效率,请提供以下信息,问题描述清晰能够更快得到解决:

【 TiDB 使用环境】

阿里云服务器搭建

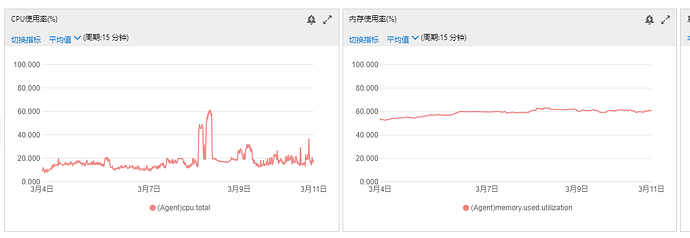

3PD 5KV tikv 为16核32G内存 均为ssd磁盘

【概述】 场景 + 问题概述

慢查询有很多insert 时间超过四秒钟,数据库平均qps 2K左右

【背景】 做过哪些操作

【现象】 业务和数据库现象

【问题】 当前遇到的问题

【业务影响】

【TiDB 版本】

tidb 4.0.9

【应用软件及版本】

【附件】 相关日志及配置信息

- TiUP Cluster Display 信息

- TiUP CLuster Edit config 信息

监控(https://metricstool.pingcap.com/)

- TiDB-Overview Grafana监控

- TiDB Grafana 监控

- TiKV Grafana 监控

- PD Grafana 监控

- 对应模块日志(包含问题前后 1 小时日志)

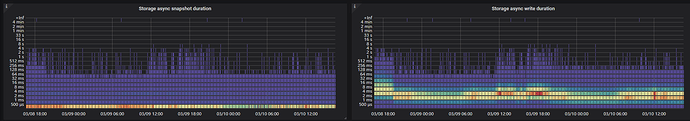

监控大部分都正常 发现快照读取比较慢

若提问为性能优化、故障排查类问题,请下载脚本运行。终端输出的打印结果,请务必全选并复制粘贴上传。

1 个赞

排查下来就是这个

Storage async snapshot duration偏高 请问这个应该怎么处理

h5n1

(H5n1)

5

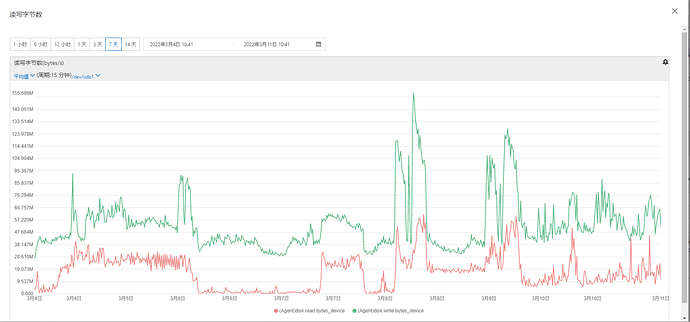

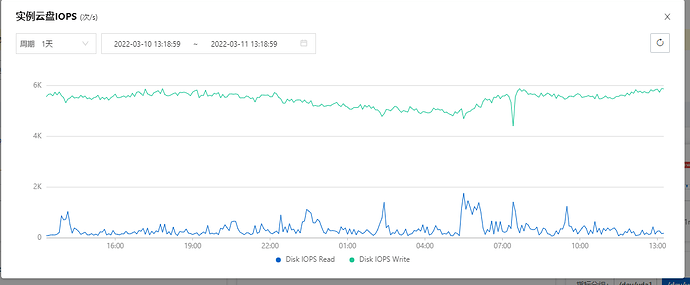

看下tikv的几个scheduler和其他几个线程的CPU利用率 还有磁盘IO情况

xfworld

(魔幻之翼)

6

这是 IO 有瓶颈了么? 还是 CPU 处理 跟不上?

要看具体的iops,但据我知道的好像是根据大小的。

数据小黑

(数据小黑)

11

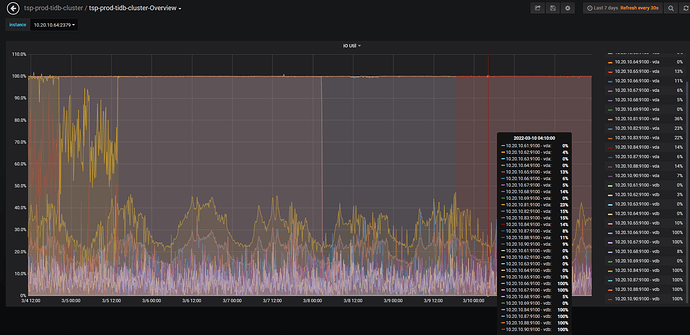

tidb的grafana->overview->System Info->IO Util,麻烦截个图看看

这个参数我查了下只是针对机械硬盘有效 ssd监控不准确

数据小黑

(数据小黑)

15

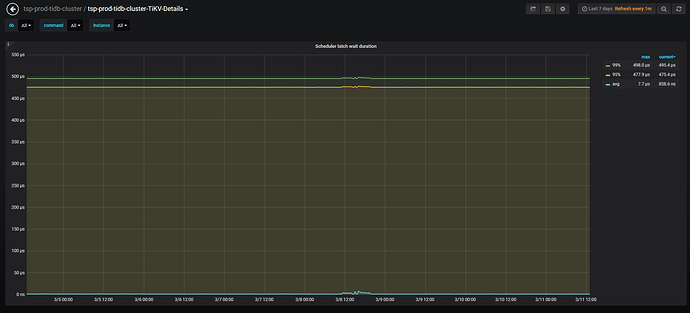

我目前的排查:

怀疑latch高,为了验证,是否可以截取:grafana->TiKV Details->Scheduler-commit->Scheduler latch wait duration看一下,另外,配置文件改过哪些参数,是否可以说一下?

qizheng

(qizheng)

16

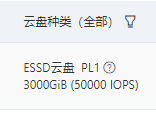

根据之前的压测经验,将阿里云盘升级到 ESSD PL3 型,磁盘才不会成为瓶颈,获得相对稳定的性能

我以前用过阿里云。确实需要达到ESSD 之后才可以满足iops。好像记得一个月8000多(打折)

我的阿里云磁盘是pl1标准是5万iops 实际iops是5000 应该没达到瓶颈吧

我的阿里云磁盘是pl1标准是5万iops 实际iops是5000 应该没达到瓶颈吧

我的阿里云磁盘是pl1标准是5万iops 实际iops是5000 应该没达到瓶颈吧