为提高效率,请提供以下信息,问题描述清晰能够更快得到解决:

【 TiDB 使用环境】

V4.0.13

【概述】 场景 + 问题概述

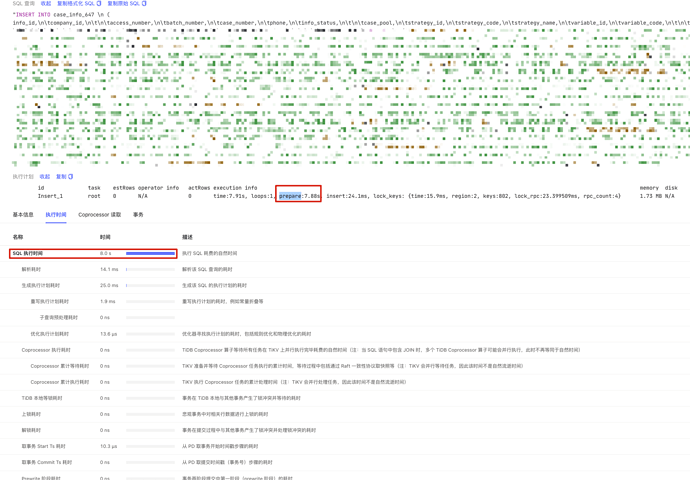

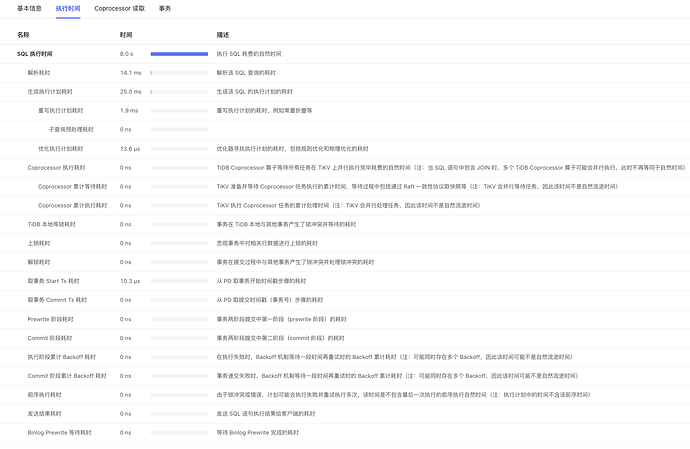

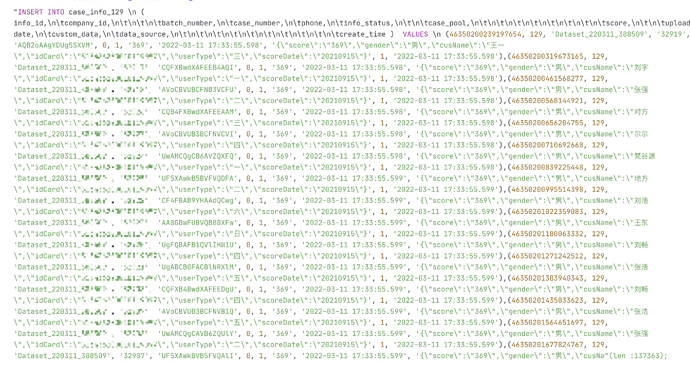

insert 批量插入2000行数据prepare耗时很长

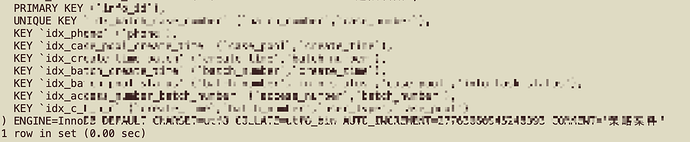

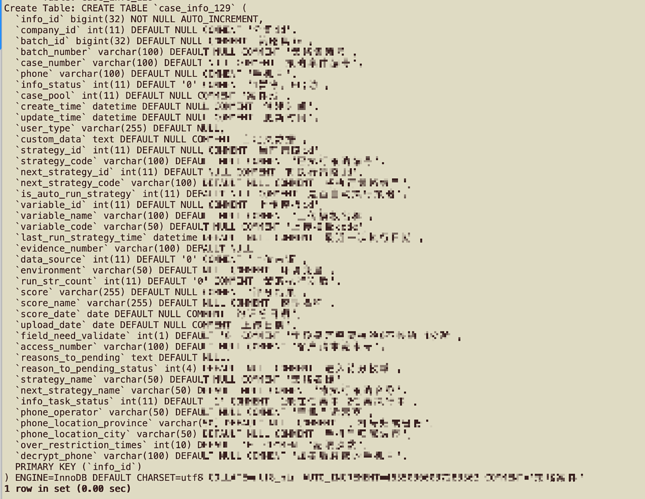

表结构如下,有9个索引

【执行计划内容】

【 SQL 文本、schema 以及 数据分布】

【业务影响】

【TiDB 版本】

V4.0.13

【附件】 相关日志及监控(https://metricstool.pingcap.com/)

- TiUP Cluster Display 信息

- TiUP CLuster Edit config 信息

- TiDB-Overview Grafana监控

- TiDB Grafana 监控

- TiKV Grafana 监控

- PD Grafana 监控

- 对应模块日志(包含问题前后 1 小时日志)