freywan

(Alex Wanlol)

1

为提高效率,请提供以下信息,问题描述清晰能够更快得到解决:

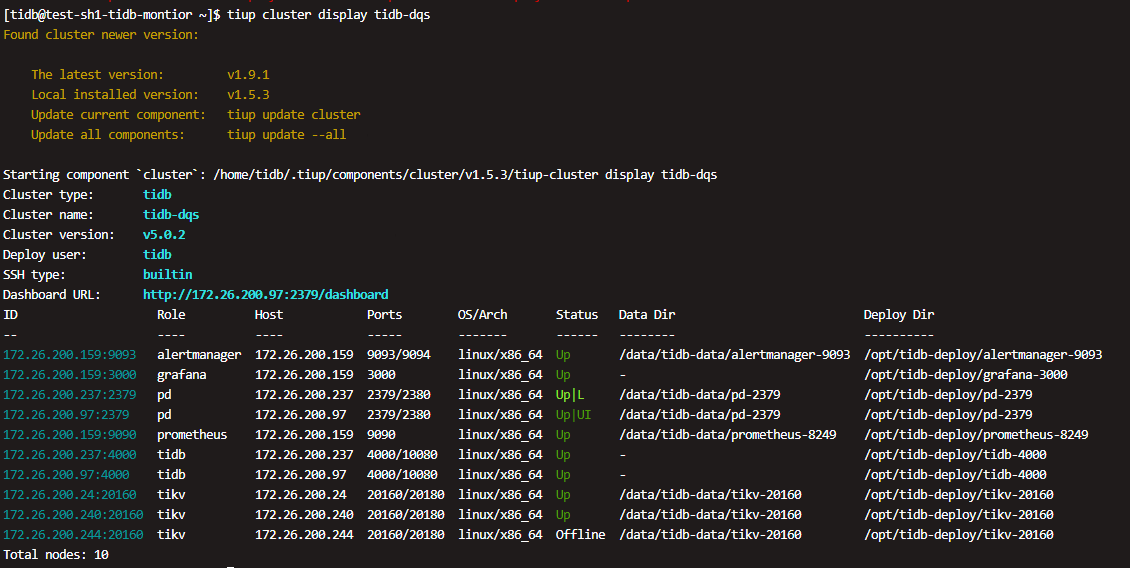

【 TiDB 使用环境】v5.0.2

【概述】将一台tikv force 缩容后,PD节点信息应该还存在残留。当重新把tikv加入到集群中,提示错误信息如下:

【现象】加入集群后,新扩容的tikv节点处于offline状态,无法启动。

补充:

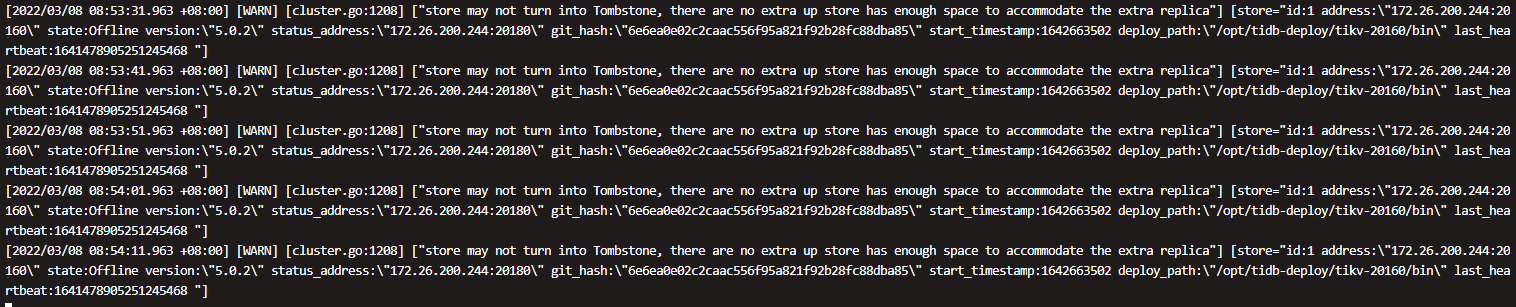

将offline的节点scale-in缩容后,tikv节点一直处于pending offline状态

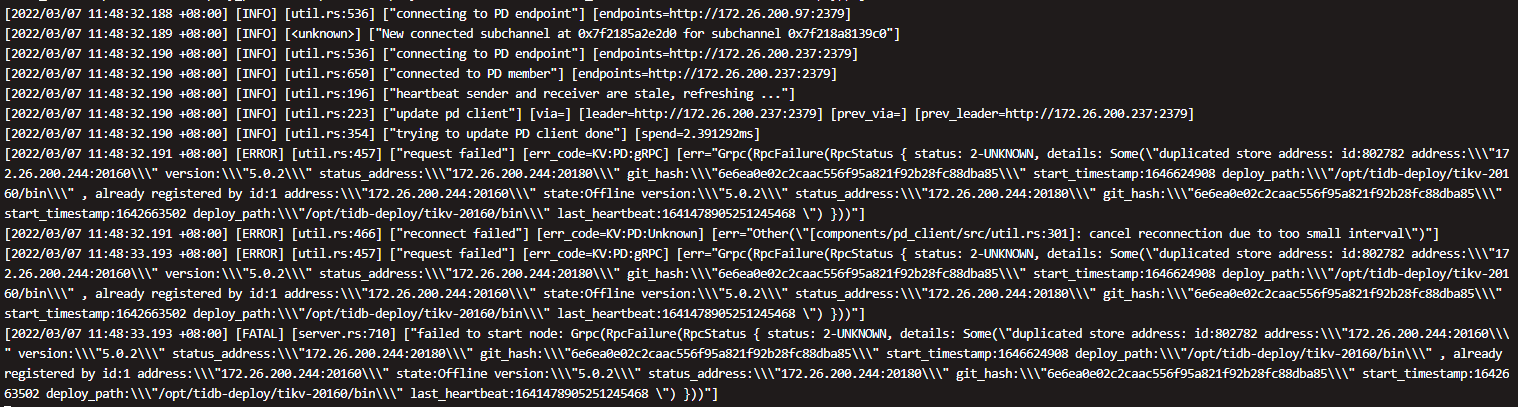

查看PD日志,发现存在如下报错:

完整日志放在附件中

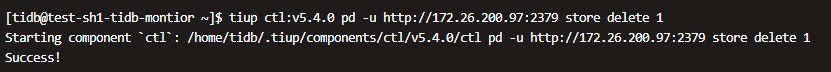

目前通过 --force删除节点后,通过store 查询,使用store delete [id]方式想删除无用的store,执行结果为成功,但是通过store查询后仍然没有删除。

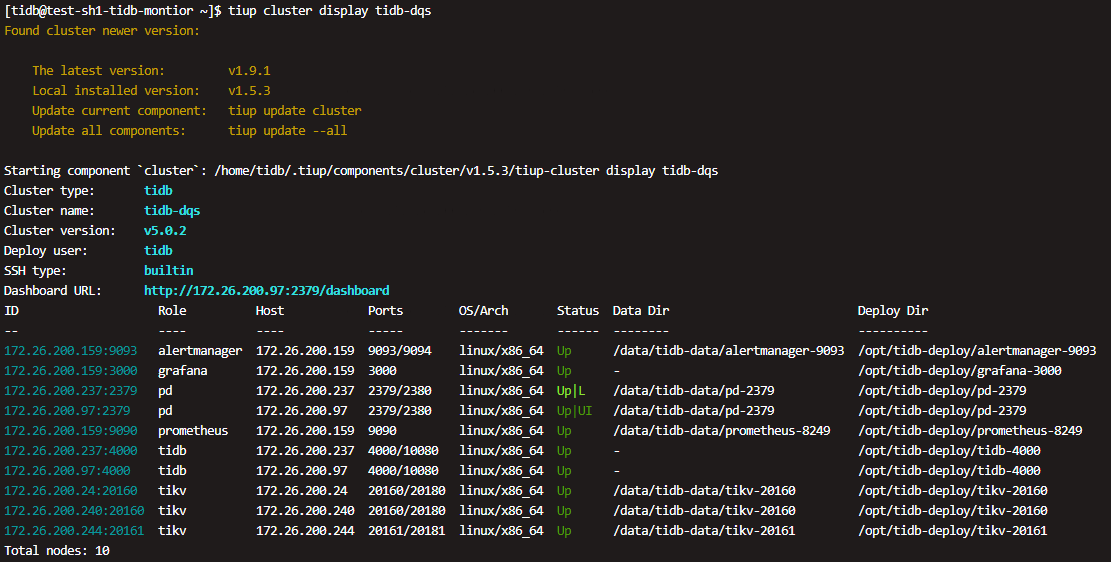

目前通过新增一个不同端口号的tikv节点让这台服务器加入集群了,但是目前对应为 3台tikv,4个store,这种情况会有啥问题嘛。

store.txt (3.9 KB)

【TiDB 版本】v5.0.2

【附件】

- 日志文件:tikv.zip (13.7 MB)

- TiUP Cluster Display 信息

- PD节点日志:

pd_2.zip (4.8 MB) pd_1.zip (1.2 MB)

freywan

(Alex Wanlol)

2

目前基本定位是PD节点的信息中,tikv信息没有去除掉,等到重做tikv节点,由于旧的信息没有清理干净,导致新加的tikv节点无法加入,这个有什么方法可以清理让集群恢复正常嘛。

h5n1

(H5n1)

4

缩容过程是什么样的?截图里的tikv还是offline状态,缩容没完成呢

边城元元

(边城元元)

5

对同一节点重新上线,缩容必须完全的移除后再进行扩容

看看能不能先扩容一个新节点,再pdctl 删除有问题的store看看呢

freywan

(Alex Wanlol)

7

这个是已经缩容后再扩容的结果,但是扩容后无法拉起,所以集群列表有这个节点,但是一直是offline

freywan

(Alex Wanlol)

9

这个我来尝试下,目前tikv节点加入进去,但是存在3个tikv,4个store