TiCDC配置gc-ttl使用的是默认值: 86400,TIDB是手动设置的tidb_gc_life_time=3h。当TiCDC故障后,如果根据changefeed任务状态会显示当前已经执行的checkpoint 的tso(如下图所示的431496573345857565),正常来说按照官方说法,即便超过了TiDB的tidb_gc_life_time,这个tso也是会保存不会释放的。

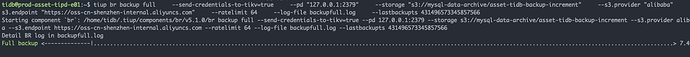

tidb@prod-asset-tipd-e01:~$ tiup cdc cli changefeed --pd="http://127.0.0.1:2379" list

Starting component `cdc`: /home/tidb/.tiup/components/cdc/v5.1.0/cdc cli changefeed --pd=http://127.0.0.1:2379 list

[

{

"id": "sync-task-2",

"summary": {

"state": "normal",

"tso": 431496573345857565,

"checkpoint": "2022-02-28 14:13:18.469",

"error": {

"addr": "172.18.244.13:8300",

"code": "CDC:ErrProcessorUnknown",

"message": "*******************'"

}

}

},

但我这里遇到了一个问题,是使用br backup时却会报[BR:Backup:ErrBackupGCSafepointExceeded]backup GC safepoint exceeded

将tso加1后,备份同步就能成功