byron

(byron)

1

为提高效率,请提供以下信息,问题描述清晰能够更快得到解决:

【 TiDB 使用环境】

【概述】 场景 + 问题概述

【背景】 做过哪些操作

对于主键的组成,昨晚做了大批量的更新

【现象】 业务和数据库现象

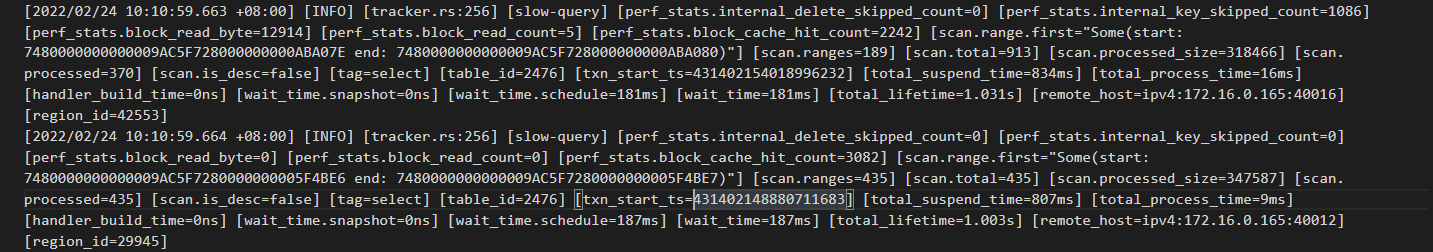

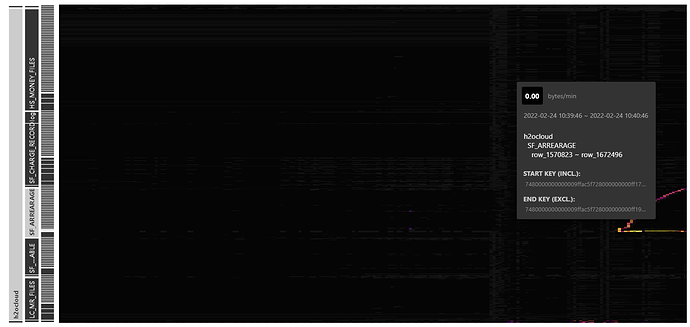

非常卡,tikv大量慢查询

【问题】 当前遇到的问题

不知如何恢复

【业务影响】

所有客户全部使用不了

【TiDB 版本】 V5.2.1

【应用软件及版本】

【附件】 相关日志及配置信息

- TiUP Cluster Display 信息

- TiUP CLuster Edit config 信息

监控(https://metricstool.pingcap.com/)

- TiDB-Overview Grafana监控

- TiDB Grafana 监控

- TiKV Grafana 监控

- PD Grafana 监控

- 对应模块日志(包含问题前后 1 小时日志)

背景:

若提问为性能优化、故障排查类问题,请下载脚本运行。终端输出的打印结果,请务必全选并复制粘贴上传。

byron

(byron)

9

tikv日志 (212.8 KB) 您好,这个是tikv的日志,多谢

byron

(byron)

11

另外一个tikv节点的日志 (750.5 KB) 这是另外一个节点的日志,总共3个节点,剩下的节点的日志和这个一样

byron

(byron)

12

您好,这个监控是指?我这边没有集成prometheus

table_id=2476 看下这个表的健康度 把慢sql拿出来看下

之前遇到过,单个的kv节点机器负载过大,导致次情况出现,具体问题的看监控,看异常SQL

byron

(byron)

18

这个的健康度开始在70以下,然后故障最开始,我对这个表做了一次analyzer后发现不生效,然后过了大约40分钟我又做了一次,现在健康度上来了,现在故障恢复了

byron

(byron)

21

对,我在中间对这张表进行一次加索引,这个操作也花了20多分钟的时间