田帅萌7

(田帅萌)

1

为提高效率,请提供以下信息,问题描述清晰能够更快得到解决:

【 TiDB 使用环境】

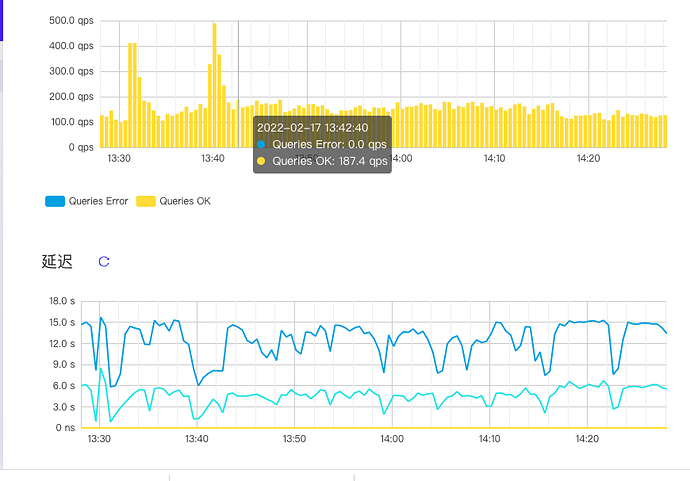

【概述】TiDB 突然延迟上升到1s

【背景】tidb 写集群,无读流量,无变更

【现象】TiDB 突然延迟上升到15s ,写延迟较大

【业务影响】

【TiDB 版本】V5.0.4

【附件】

-

TiUP Cluster Display 信息

-

TiUP Cluster Edit Config 信息

-

TiDB- Overview 监控

4 个赞

Write conflict tikv日志搜索一下

1 个赞

Jiawei

(渔不是鱼)

9

qps下降下来了,是不是有锁等待相关的,看看几张和锁相关的表看看

1 个赞

磁盘空间看下。是不是磁盘空间达到阀值 在做调度 导致tikv忙

1 个赞

CuteRay

(Cherry🍒)

11

low-space-ratio

这个默认值是0.8,看你的存储,可能是某台TiKV的存储到瓶颈了,可以检查下。

2 个赞

duzq

(duzq)

12

1 个赞

田帅萌7

(田帅萌)

13

1 个赞

田帅萌7

(田帅萌)

14

1 个赞

duzq

(duzq)

16

log.tar.gz (275.9 KB)

dmseg日志和 message 日志

1 个赞

逍遥_猫

18

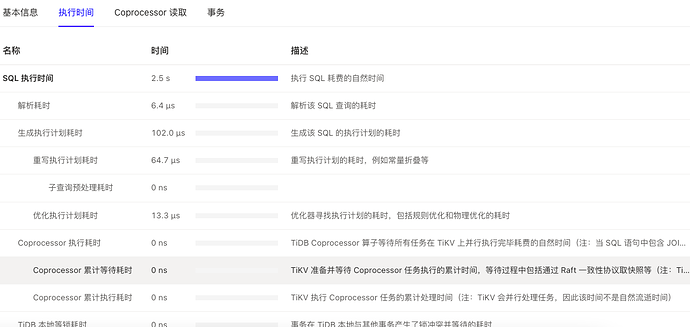

从上面的dashboard 看,TIKV coprocessor 没有等待

1 个赞

田帅萌7

(田帅萌)

19

duzq

(duzq)

20

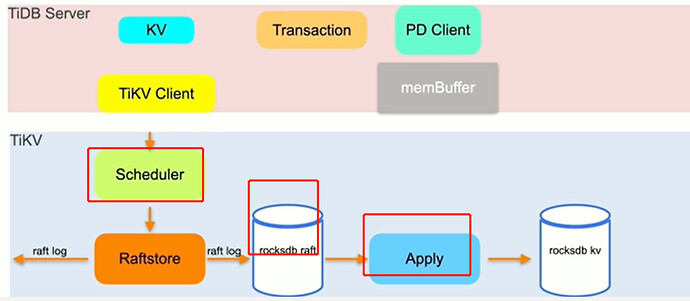

172.18.234.83在 9 点 30 左右夯死用户重启过一次,11 点到 15:44的问题经过排查推测还是172.18.234.83内核夯导致的,因为多个日志(系统 message,tikv log,rocksdb log,raftrockslog) 都在 09:33 到 17:28 之间没有任何日志写入,tikv 监控中发现该实例压力很小,因为 compaction 文件积压导致 write stall,应该也是卡在了内核层无法写文件。

该问题需要事故时的堆栈信息和火焰图来实锤,只能等下次复现后通过 dashboard 的 profiling 抓取相关信息再定位了。

1 个赞