tidb版本是4.0.5,系统没有发生oom,plan-cache没有开启,日志里有如下报错,业务上有些临时表drop,truncate比较频繁,会是这个原因导致的吗?

PD 频繁重启辛苦提供下下面的日志信息,这里分析看下:

1、操作系统 messages 日志文件

2、频繁重启的 PD server 的完整的 log 以及 stderr 日志文件,非截图

3、PD Grafana 监控,包括频繁重启的时间点前后

4、频繁重启的 PD server 的 Granfa 的 node-exporter 监控

5、pd-ctl config show all 提供下当前 pd 的配置项

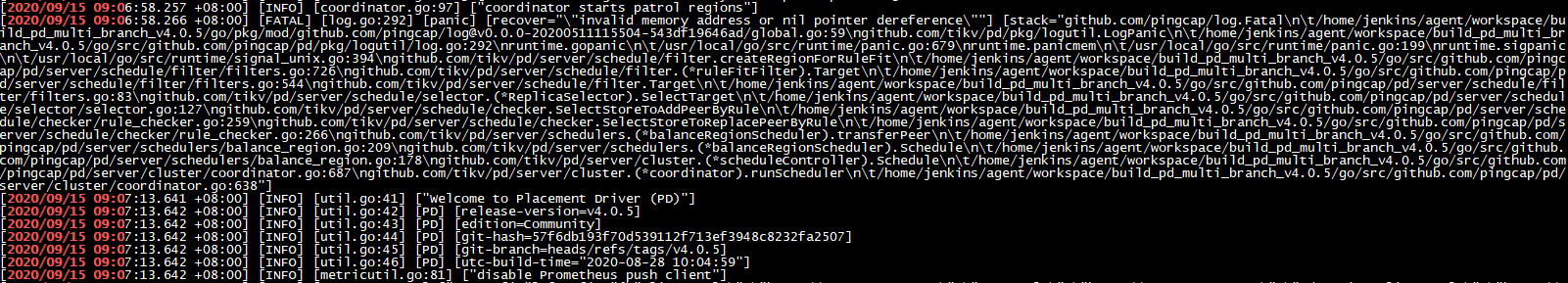

从 log-pd2 日志来看是 balance-region scheduler 遭遇了 panic,请通过

pd-ctl config placement-rules show

上传一下所有使用的 rules ,帮助我们定位问题。假如不需要使用 placement rules,可以将 PD 的设置

enable-placement-rules

设置为 false 然后更新 PD 暂时绕过问题

部署了tiflash节点,enable-placement-rules可以设置成false吗?

config placement-rules show

[

{

“group_id”: “pd”,

“id”: “default”,

“start_key”: “”,

“end_key”: “”,

“role”: “voter”,

“count”: 3

},

{

“group_id”: “tiflash”,

“id”: “table-75-r”,

“override”: true,

“start_key”: “7480000000000000FF4B5F720000000000FA”,

“end_key”: “7480000000000000FF4C00000000000000F8”,

“role”: “learner”,

“count”: 1,

“label_constraints”: [

{

“key”: “engine”,

“op”: “in”,

“values”: [

“tiflash”

]

}

]

}

]

enable-placement-rules 设置成 false ,TiFlash 没办法使用。

如果无法关掉 placement rules 可以考虑暂时移除 balance-region-scheduler ,暂时回避 panic,不过可能会引起 store 之间 size 不平衡。

pd-ctl scheduler remove balance-region-scheduler

这是4.0.5的bug吗,之前用4.0.4没有这种现象

是的 4.0.5 引入,预计修复将在 4.0.7 带上,region 没有 leader 执行 balance region 会触发

引入:https://github.com/tikv/pd/pull/2794

修复:https://github.com/tikv/pd/pull/2966

好的,谢谢

![]()