为提高效率,提问时请提供以下信息,问题描述清晰可优先响应。

- 【TiDB 版本】:v4.0.1 GA

- 【问题描述】:

使用sysbench在上游mysql生成数据并同步到下游tidb集群

数据生成prepare阶段,tidb就完全跟不上获取到的binlog。截至上游数据写入完毕后,下游整整落后100多个binlog

环境信息

上游mysql:2核8G

下游tidb2核8G,tidb核pd部署在一起,tikv独立节点

磁盘为高速SSD,目前每秒写入只有8M

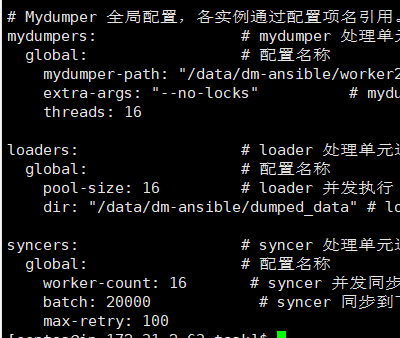

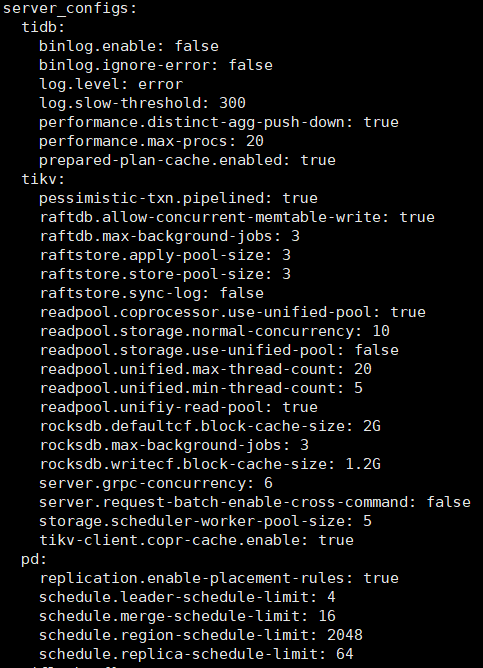

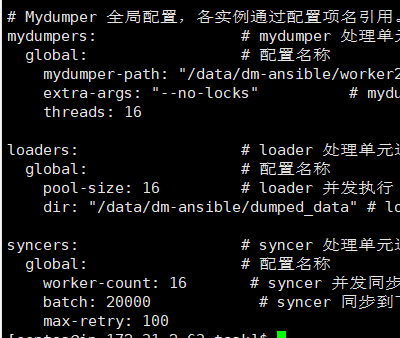

dm配置如下:

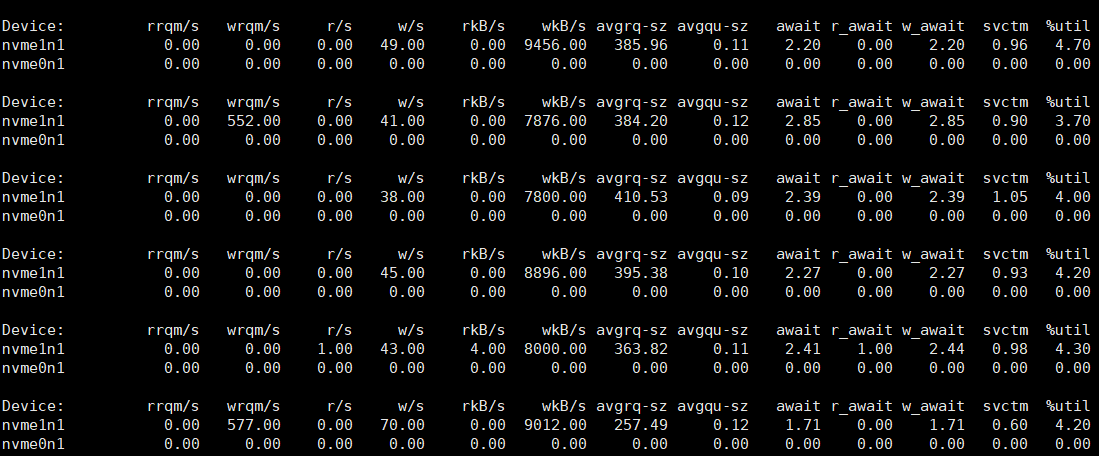

磁盘截图

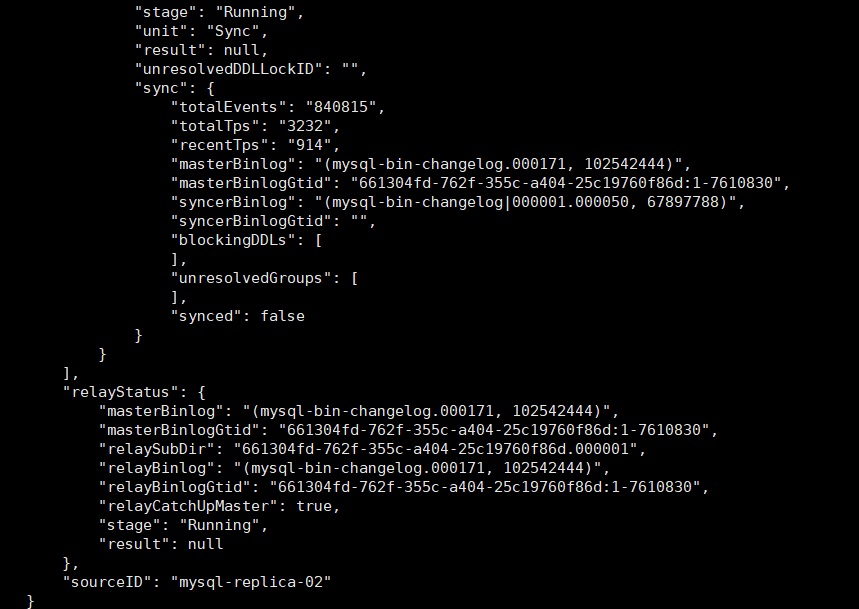

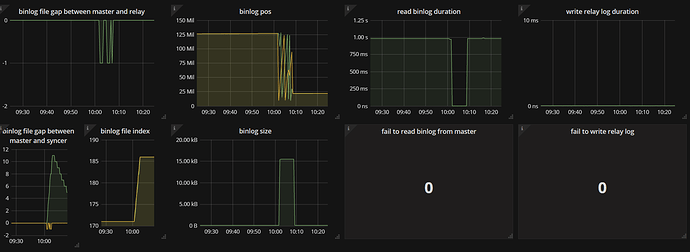

同步截图

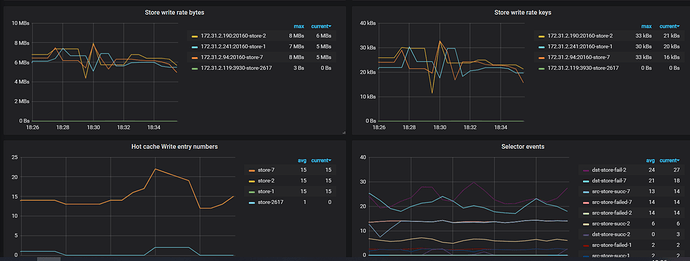

pd监控

还需要提供哪些信息

小王同学

2

您好,请问您这边 DM 使用的是哪个版本?麻烦提供下。另外 DM 监控可以提供下。您这边下游 tidb 的机器配置太低。如果是线上测试,麻烦按照官网推荐的软硬件配置。初步怀疑是 tidb 下游硬件配置达到瓶颈导致写入过慢。从而造成你这边观察到的延迟较大。

https://pingcap.com/docs-cn/stable/hardware-and-software-requirements/

建议您这边优先调整硬件资源,延迟可以从两个方向查看,一个是下游 TiDB 写入慢导致,一个是 DM 同步慢导致,可以分别从监控中分析具体情况。

你好,dm版本是v1.0.5

监控显示与上游 master 相比 binlog replication unit 落后的 binlog file 个数,目前还落后7个

查看上图query-status任务状态,可以看出dm获取上游binlog到本地很快。但是本地去应用日志就很慢。

所以我觉的是tidb写入慢的问题。

有没有什么优化参数的思路,去提升写入速度问题。因为完全没有达到磁盘性能

小王同学

4

同样是上面提到过的问题,下游机器配置才 2 核,并且 tidb 和 PD 混合部署,CPU 负载你这边可以检查下,CPU 已经到达瓶颈的话,写入慢符合预期,还是上面的建议,建议您这边按照官网推荐的软硬件配置来部署环境。

收到,我这边看了下,确实是其中两个tikv节点cpu高负载了。那是需要调整cpu了。多谢繁忙之中解答

system

(system)

关闭

7

此话题已在最后回复的 1 分钟后被自动关闭。不再允许新回复。