为提高效率,提问时请提供以下信息,问题描述清晰可优先响应。

- 【TiDB 版本】:v3.0.1

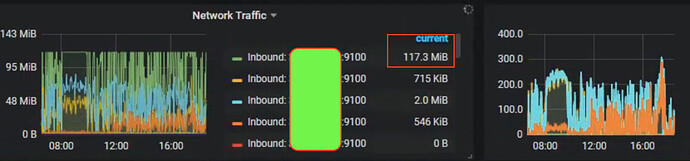

- 【问题描述】:tikv到Tidb-server的流量过大,导致网络阻塞。

部署情况,总共4节点,机器配置64核、64GB内存、千兆网络。

1个节点部署tidb-server、pd

3个节点部署tikv

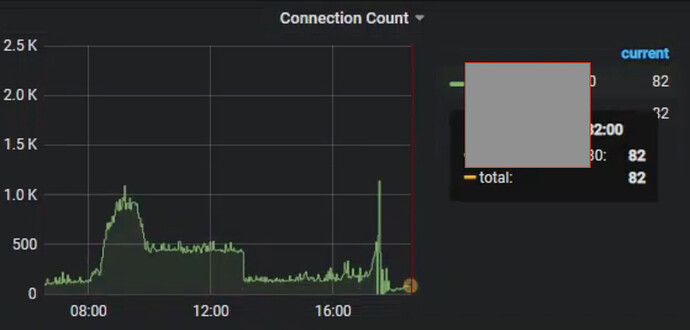

平时连接数在300左右,在某个时间点 tidb-server节点,接收流量到到900Mb多,基本满流量运行

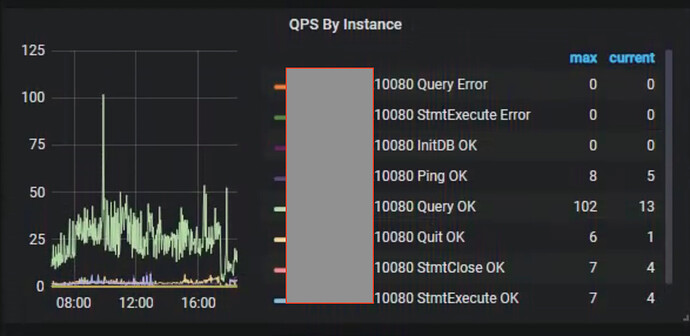

qps情况

连接数情况

网络情况,tidb-server基本达到峰值117MB

当前版本运行采集脚本失败,获取不到采集信息

若提问为性能优化、故障排查类问题,请下载脚本运行。终端输出打印结果,请务必全选并复制粘贴上传。