为提高效率,提问时请提供以下信息,问题描述清晰可优先响应。

- 【TiDB 版本】:4.0.2

- 【问题描述】:导入checksum不一致

[2020/07/08 17:33:57.223 +08:00] [ERROR] [restore.go:109] [-] [table=hz_ods_source.rn_worker_attendance_2019_08] [status=checksum] [error=“checksum mismatched remote vs local => (checksum: 13074461541046819684 vs 11253811792635397882) (total_kvs: 3315720 vs 4180788) (total_bytes:409877039 vs 507533019)”]

[2020/07/08 17:33:57.223 +08:00] [ERROR] [main.go:82] [“tidb lightning encountered error stack info”] [error=“restore table dim.dim_team_worker_df failed: checksum mismatched remote vs local => (checksum: 7653677028192941198 vs 12081930815224761565) (total_kvs: 2472118 vs 3100140) (total_bytes:833021059 vs 936397782)”] [errorVerbose=“checksum mismatched remote vs local => (checksum: 7653677028192941198 vs 12081930815224761565) (total_kvs: 2472118 vs 3100140) (total_bytes:833021059 vs 936397782)\ngithub.com/pingcap/tidb-lightning/lightning/restore.(*TableRestore).compareChecksum\

\t/home/jenkins/agent/workspace/build-linux-arm64-4.0/go/src/github.com/pingcap/tidb-lightning/lightning/restore/restore.go:1438\ngithub.com/pingcap/tidb-lightning/lightning/restore.(*TableRestore).postProcess\

\t/home/jenkins/agent/workspace/build-linux-arm64-4.0/go/src/github.com/pingcap/tidb-lightning/lightning/restore/restore.go:1118\ngithub.com/pingcap/tidb-lightning/lightning/restore.(*TableRestore).restoreTable\

\t/home/jenkins/agent/workspace/build-linux-arm64-4.0/go/src/github.com/pingcap/tidb-lightning/lightning/restore/restore.go:782\ngithub.com/pingcap/tidb-lightning/lightning/restore.(*RestoreController).restoreTables.func1\

\t/home/jenkins/agent/workspace/build-linux-arm64-4.0/go/src/github.com/pingcap/tidb-lightning/lightning/restore/restore.go:608\

runtime.goexit\

\t/usr/local/go/src/runtime/asm_arm64.s:1128\

restore table dim.dim_team_worker_df failed”]

[2020/07/08 17:33:57.224 +08:00] [ERROR] [main.go:83] [“tidb lightning encountered error”] [error=“restore table dim.dim_team_worker_df failed: checksum mismatched remote vs local => (checksum: 7653677028192941198 vs 12081930815224761565) (total_kvs: 2472118 vs 3100140) (total_bytes:833021059 vs 936397782)”]

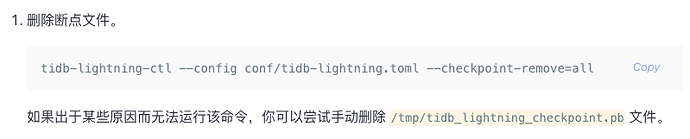

如日志所示,这张表的前后数据不一致。清除断点重试后,仍旧如此。