为提高效率,提问时请提供以下信息,问题描述清晰可优先响应。

- 【TiDB 版本】:TiDB-v3.0.12

- 【问题描述】:

环境:

tikv * 3 16c64G,

tipd * 2 16c32G

tidb * 2 与pd混合部署

默认参数安装

背景:

一张数据量7亿,45个字段的表A,实时更新

一张数据量在3亿,160字段的大宽表B,天级更新

实时数仓的场景,需要对A表进行实时插入和近期数据的更新,定时对A、B两表进行olap的聚合查询

问题:

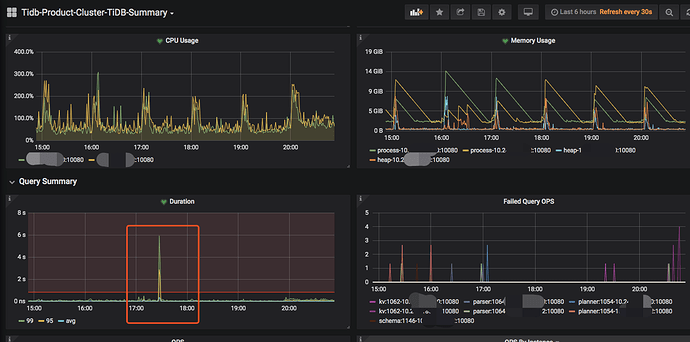

在对AB两张大表聚合查询时,tidb duration99会打到5s左右,影响了插入和更新操作(tps大概为100~500)

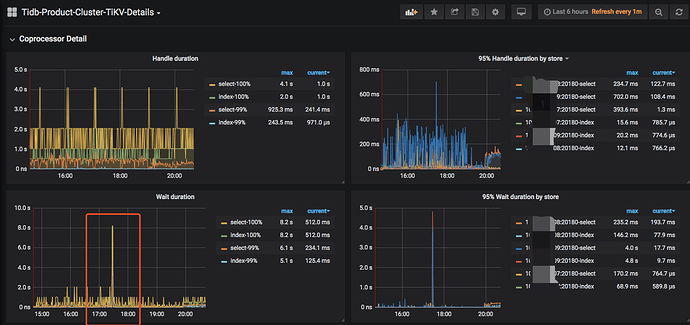

监控发现tikv的coprocessor的wait_duration明显增高

不考虑olap是否打到索引的情况下,

- 怎样能避免olap的场景影响到oltp,保证oltp的稳定性?

- 有哪些参数调整,可以提高olap的性能?

增大 tidb_distsql_scan_concurrency(现为15)为50

增大tidb_index_serial_scan_concurrency (现为1)为10

增大tidb_index_join_batch_size (现为25000)为50000

能否解决上述两个问题?数值合理吗?

补充:

tidb duration99的监控

若提问为性能优化、故障排查类问题,请下载脚本运行。终端输出打印结果,请务必全选并复制粘贴上传。