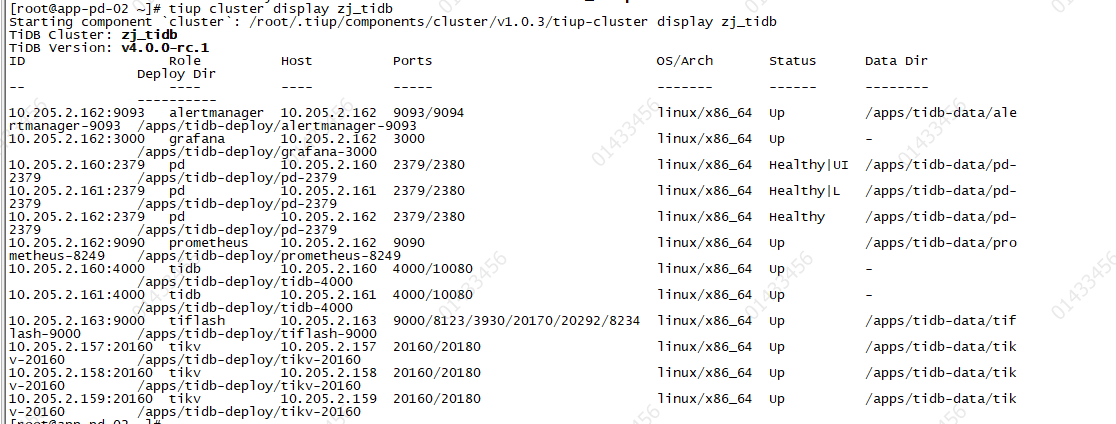

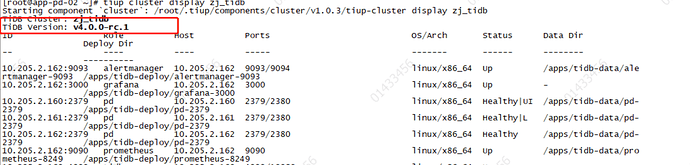

【tidb版本】:v4.0.0-rc.1

【tiup版本】:tiup update cluster,升级为最新的版本-v1.0.3

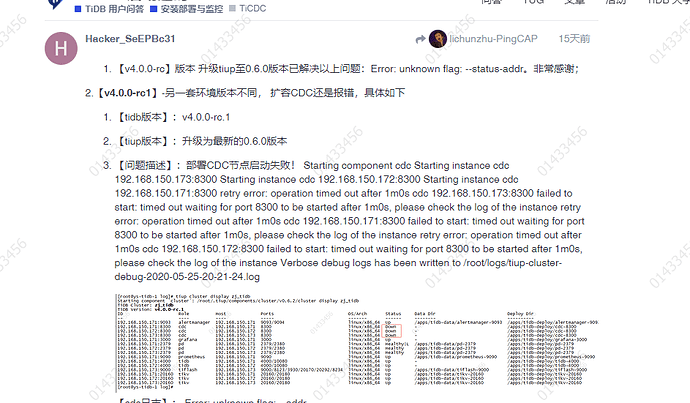

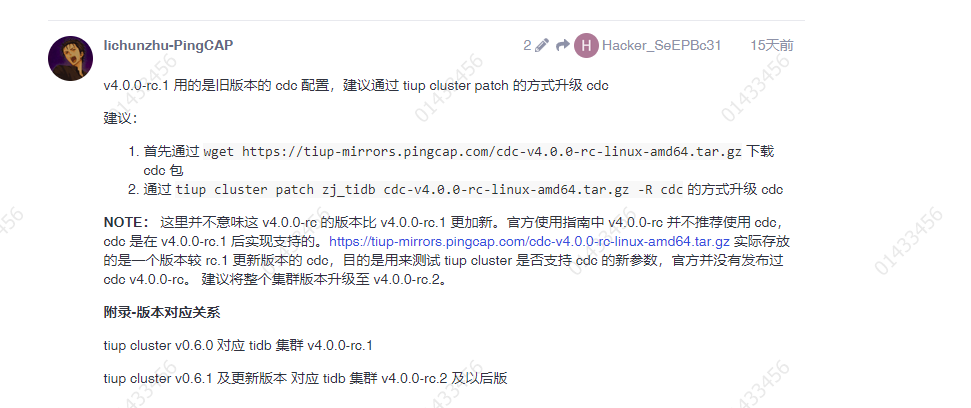

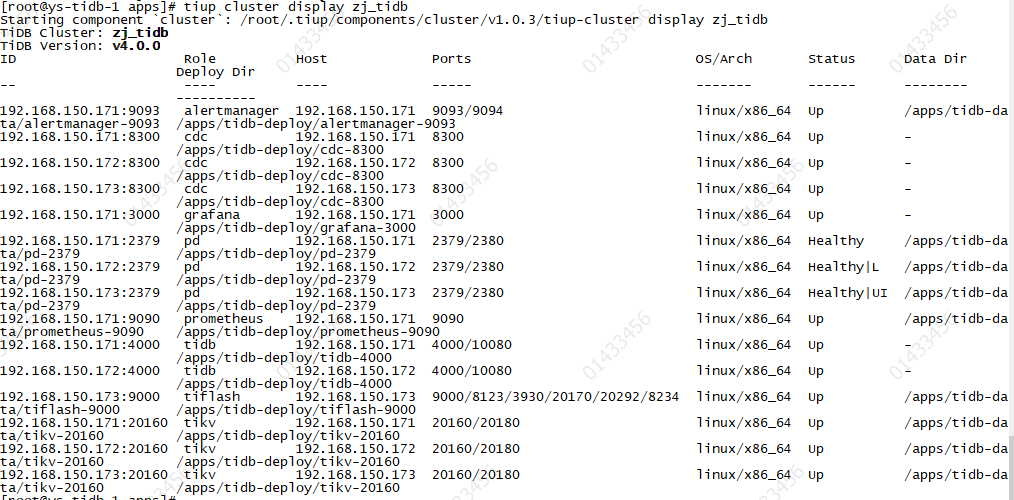

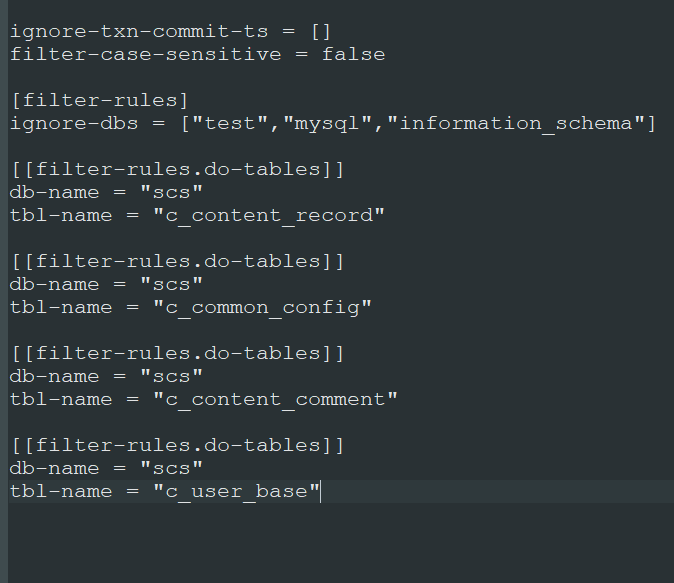

【cdc版本】:通过本地安装cdc wget https://tiup-mirrors.pingcap.com/cdc-v4.0.0-rc-linux-amd64.tar.gz 下载 cdc 包 通过 tiup cluster patch zj_tidb cdc-v4.0.0-rc-linux-amd64.tar.gz -R cdc 的方式升级 cdc

【执行1】tiup cluster patch zj_tidb cdc-v4.0.0-rc-linux-amd64.tar.gz -R cdc 报错。

Starting component cluster: /root/.tiup/components/cluster/v1.0.3/tiup-cluster patch zj_tidb cdc-v4.0.0-rc-linux-amd64.tar.gz -R cdc

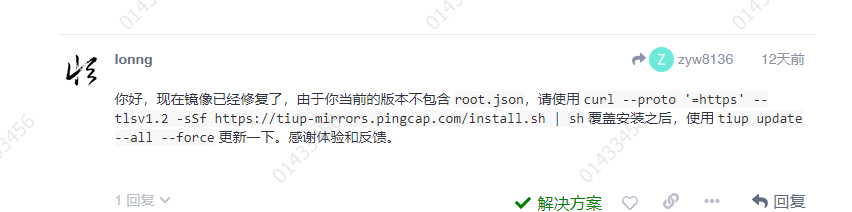

Error: initial repository from mirror(https://tiup-mirrors.pingcap.com/) failed: cannot open the initial root.json at /root/.tiup/bin/root.json

Verbose debug logs has been written to /root/.tiup/bin/logs/tiup-cluster-debug-2020-06-08-23-15-58.log.

Error: run /root/.tiup/components/cluster/v1.0.3/tiup-cluster (wd:/root/.tiup/data/S1KkaFz) failed: exit status 1

【执行2】tiup cluster scale-out zj_tidb /apps/tidb/scale-cdc.yaml 也报错

Starting component cluster: /root/.tiup/components/cluster/v1.0.3/tiup-cluster scale-out zj_tidb /apps/tidb/scale-cdc.yamltiup-cluster-debug-2020-05-25-20-21-24.log (88 KB)

tiup-cluster-debug-2020-05-26-09-53-10.log (47.2 KB)

Error: initial repository from mirror(https://tiup-mirrors.pingcap.com/) failed: cannot open the initial root.json at /root/.tiup/bin/root.json