* 【TiDB 版本】:V3.0.12

* 【问题描述】:

你好,我们现在关于tikv 扩容有一个问题不大清楚,向你们请教一下。

就是我单服务器多实例的几个磁盘插槽都都用光了,现在没有办法扩容,然后这个要如何扩容呢?能都跨服务器做扩容,这个怎么做呢?

https://pingcap.com/docs-cn/stable/how-to/deploy/geographic-redundancy/location-awareness/#pd-%E7%90%86%E8%A7%A3-tikv-%E6%8B%93%E6%89%91%E7%BB%93%E6%9E%84

和这上面的文章是否类似?我的架构是这样的,3台tikv 服务器,3个副本集,然后每台服务器上做多个实例,比如我一台服务器上有6个磁盘的插槽,那么我就在每台服务器上搭建6个实例。

我的数据量比较大, 我的计划是将所有业务库合并到TIDB 实例上的,并发量很大,数据量大概10T 左右。

我这边计划分为5-6个实例,这样会不会有什么弊端?或者对业务上有影响?同时还再请教一个问题,就是一份副本集一台服务器上最多分配几个实例比较适合呢?

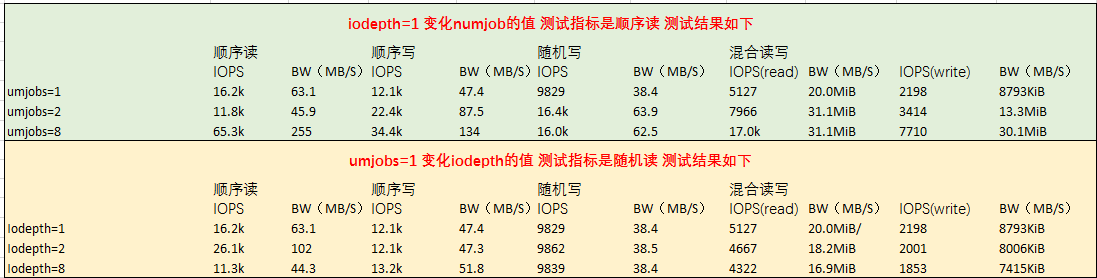

10G 文件 fio 的测试,具体的 fio 参数在 ansible 目录:

./roles/machine_benchmark/tasks/ 中

那我64G的内存只能配置一个实例的tikv 实例? 可否配置3个呢?

因为每个实例还会有程序内存的一些占用,所以每个实例最好不要少于 32G

奇怪,按照你们的要求的测了随机读写 IOPS ,但是数据和你们不大一样 随机读和写: read: IOPS=6144, BW=192MiB/s (201MB/s)(11.2GiB/60001msec) write: IOPS=13.5k, BW=421MiB/s (442MB/s)(24.7GiB/60001msec)

CPU ,内存,SSD 磁盘店 都符合要求

CPU 32核,内存64G ,2T ssd

SSD 的话,会有些性能浮动,看这个应该是可以满足业务需求了。

刚刚问的还有一个问题,就是我服务器的插槽都插满了,没法扩容的情况下,怎么处理呢?可否扩容机器还是怎么弄?

可以扩容机器的,以 tikv-server 来考虑就可以了。

这边需要注意的是,单机多实例部署,需要给拓扑打标签,具体的可以官网搜索多实例来参考。

打标签是这个文章的第4点是不是

我新增加实例后,看这是有自动打上标签了,还需要手动再修改?

如果确认实例上已经打上标签了,那可以不修改