一致的,密码也是在inventory.ini里面取的,监控肯定是这个集群的。所以我也很奇怪啊,为什么展示的不一致,才来提问的啊…

您好:

20180是tikv_status_port上报的默认端口, 由于您在配置里只设置了tikv_port, 导致两个tikv实例默认的tikv_status_port上报端口应该都是20180, 所以可能有一个无法上报. 根据文档,3.0多实例配置时需要设置status端口

https://pingcap.com/docs-cn/stable/how-to/deploy/orchestrated/ansible/

- 请帮忙执行ps -ef | grep tikv 反馈某个服务器上两个tikv实例的进程信息

- 请再确认下当前版本是3.0.5

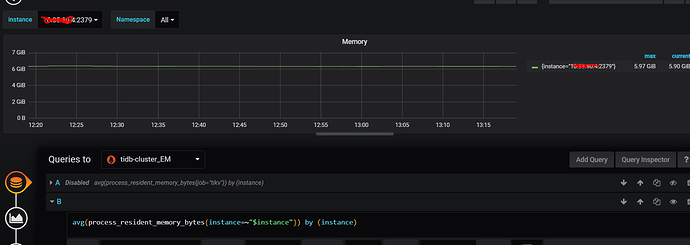

- 请在tikv memory界面编辑edit ,使用avg(process_resident_memory_bytes{instance=~“$instance”}) by (instance) 这个公式看看展示结果.

那我觉得就是没有指定status的原因了,他只拉取了一个实例的内存占用信息。如果我添加这个status_port的话是更新监控呢?还是更新tikv?

15-20:45:30 bin/tikv-server --addr 0.0.0.0:20172 --advertise-addr tikvip:20172 --status-addr tikvip:20180 --pd pd1:2379,pd2:2379,pd3:2379 --data-dir /home/service/var/data2/tikv-deploy/data --config conf/tikv.toml --log-file /home/service/var/data2/tikv-deploy/log/tikv.log

35-11:37:29 bin/tikv-server --addr 0.0.0.0:20171 --advertise-addr tikvip:20171 --status-addr 10.35.46.45:20180 --pd pd1:2379,pd2:2379,pd3:2379–data-dir /home/service/var/data1/tikv-deploy/data --config conf/tikv.toml --log-file /home/service/var/data1/tikv-deploy/log/tikv.log

5.7.25-TiDB-v3.0.5-1-gc0a14b50e4

可以尝试按照以下方式更改端口:

- 某个tikv上,关闭需要修改端口的实例,举例: 10.35.46.45:20180 在这个实例的安装目录/scripts/目录下,使用stop_tikv.sh

- 修改中控机inventory.ini 中的这个实例的tikv_status_port端口.

修改tikv实例所在目录/scripts/目录下,run_tikv.sh里的端口,将20180修改为目标端口(确认此端口在集群内放通,如果有防火墙放通端口) - 修改完后,启动实例. 可以使用scripts下的start_tikv.sh启动.

- 执行 ansible-playbook rolling_update_monitor.yml --tags=prometheus 更改监控信息

- 在grafana查看是否成功. 注意:最好一个一个tikv修改. 修改ip的这个实例

不能滚动升级吗,单独这样操作一个个的改,会不会导致region leader被影响,查询延迟?

滚动升级,一样要启停tikv,还是会影响leader。这样改端口,一个个修改之后观察,更加安全

我在inventory.ini里面的tikv部分增加了那个status port的参数,然后滚动 promethus恢复~谢谢~(补充 先滚动tikv再更新promethus的

![]()

![]()

![]()

此话题已在最后回复的 1 分钟后被自动关闭。不再允许新回复。