unops

(不得了)

1

为提高效率,提问时请提供以下信息,问题描述清晰可优先响应。

我们原来的3个TIKV 配置有点低,昨天我们扩容了3个tikv,数据都有了。

今天我们缩容下线3个老的 tikv

用命令:

/home/tidb/tidb-ansible/resources/bin/pd-ctl -u "http://10.0.0.16:2379" -d store 7

/home/tidb/tidb-ansible/resources/bin/pd-ctl -u "http://10.0.0.16:2379" -d store 1

/home/tidb/tidb-ansible/resources/bin/pd-ctl -u "http://10.0.0.16:2379" -d store 4

已经为:Tombstone 状态了。

这个时候是否不是就现在就可以停止这3个老的tikv 了呢?并且从部署配置中删除掉。

ansible-playbook stop.yml -l 10.0.0.14

ansible-playbook stop.yml -l 10.0.0.12

ansible-playbook stop.yml -l 10.0.0.7

疑问点在于:

上面红框,里面的数据还在逐步减少,是不要等待全部降为0的时候才停止tikv 服务?

来了老弟

2

您好,

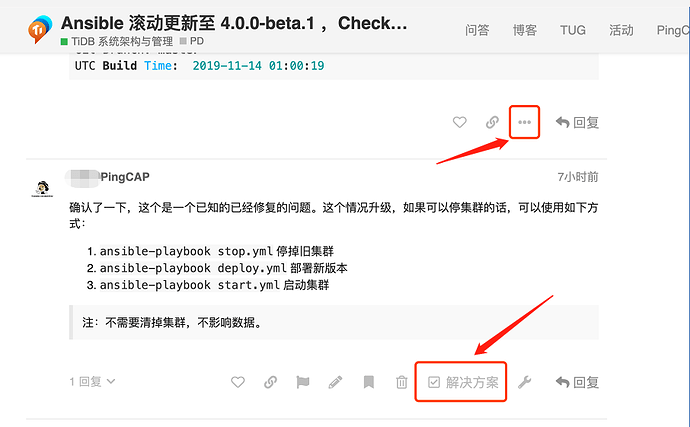

确认节点状态已经是 tombstone 了,说明 leader 和 region 已经迁移完成了, 可以直接下线的。那个监控里面显示的大小可能是历史记录。可以试试在 ./pd-ctl 查一下 store 情况, 确认是 status 是 tombstone 就可以直接停掉了

来了老弟

4

1.确认 inventory 文件中是否被注释,在进行更新监控操作。

请确认是否为历史的监控数据,新的监控数据中应该已经清理掉了。

可根据官方文档操作:

https://pingcap.com/docs-cn/stable/how-to/scale/with-ansible/#缩容-tikv-节点

unops

(不得了)

5

知道了,我选监控的时间段选择了,最近一小时,所以显示了,老的数据。

但是。

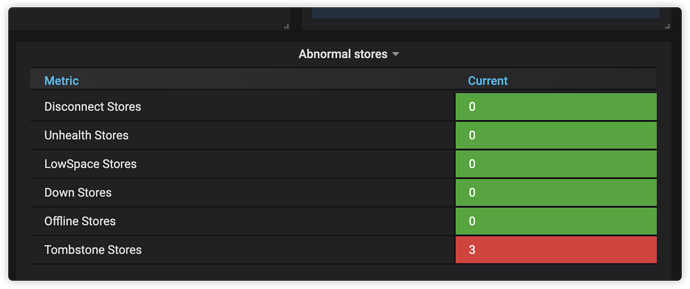

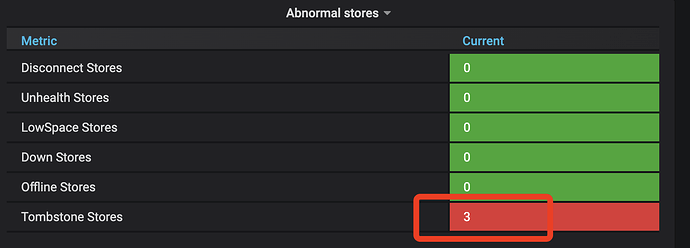

在 tidb-cluster-pd 视图中,下线成功,还显示 3个 ,Tombstone 这个地方的显示是正常的吗?

正常的,这个是存储在 PD Cluster 的 ETCD 里面的,如果清理可以,可以使用 PD control 试一下 pd-ctl stores remove-tombstone

1 个赞

来了老弟

7

感谢回复,如果问题已经解决,麻烦将关键的回复设置为最佳解决方案。

新问题麻烦另开新帖哦。

system

(system)

关闭

8

此话题已在最后回复的 1 分钟后被自动关闭。不再允许新回复。