【 TiDB 使用环境】

1PD 1TiDB 3KV

【概述】

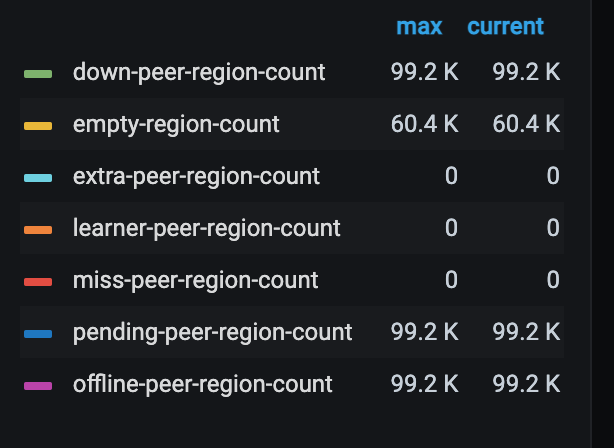

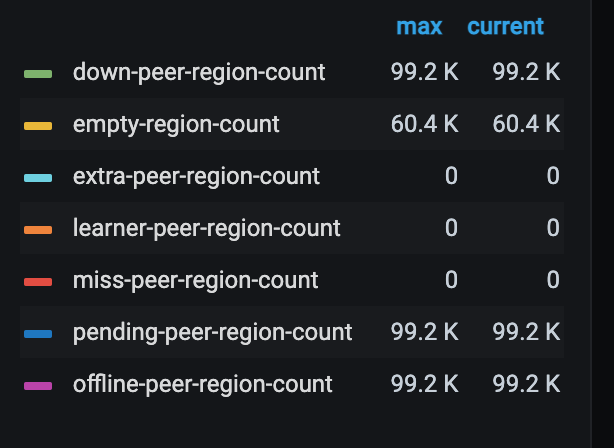

如上图,02-kv节点在昨晚做了下线操作,但是在Dashboard中还存在,状态为: 下线中

【背景】

下线方式:

tiup cluster scale-in <cluster-name> --node 10.0.1.5:20160 --force

【TiDB 版本】v5.2.2

【附件】

【 TiDB 使用环境】

1PD 1TiDB 3KV

【概述】

【背景】

下线方式:

tiup cluster scale-in <cluster-name> --node 10.0.1.5:20160 --force

【TiDB 版本】v5.2.2

【附件】

你好,tikv最低是要保证三副本的,你这里现在只有两个tikv,需要再补一个副本才行

生产环境我们用的就是3台KV,但是昨晚下线一台后,再次扩容失败了,然后在Dashboard里还显示那个节点。

请问下扩容报错的日志是什么,另外重点是如果当前只有三个节点,正常的缩容操作是先扩容一台,然后进行缩容

现在生产环境只有两个KV节点,我想把昨晚缩容的那台机器再扩容进度。但是目前发现缩容后,dashboard中还是存在之前的那台kv02的节点,我想优先把这个问题解决了。

貌似进入死循环了…

先扩容一个节点,接管 3 副本的集群需求,才能正常的进行调度,然后 kv02 节点中的region才会被调度走,变成tombstone状态…然后才能移除

这样解答,能理解么?

那我目前这种情况,还能否把kv02这个节点给扩容进去,我现在只有两个kv节点在支撑。![]() ,02节点之前的数据已经被清空了,等于是一台新机器。

,02节点之前的数据已经被清空了,等于是一台新机器。

你可以在这个机器上,换一个端口进行扩容kv

非正常的下线了 02 节点,后面你还得强制移除这个

你的意思是我扩容kv-02的时候,换个端口? 这样能解决问题么?

如何强制删除这个?

你可以按照 caiyfc 的说法来撸一把,换个端口就行了,有文档可以参考

强制删除可以做到,但有可能会造成数据丢失,如果实在不想换端口等其他情况,可以先临时用一台机子阔进来,等到这台机子正常下线了再把这台机子阔进来,然后再把临时的那台机子缩容

换个端口可以,这种方式能扩容进去。但是在 dashboard中,之前那个端口的节点记录还在![]()

等region调度完成以后,应该就可以了。

此话题已在最后回复的 1 分钟后被自动关闭。不再允许新回复。