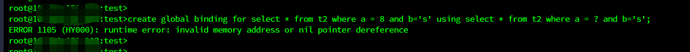

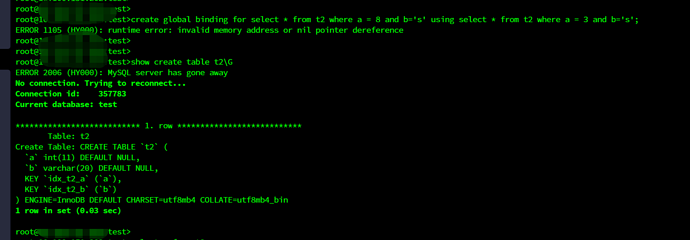

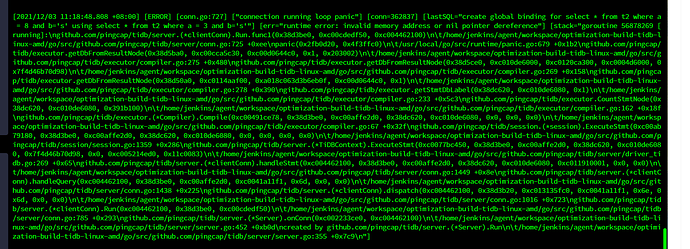

[2021/12/03 11:18:48.808 +08:00] [ERROR] [conn.go:727] [“connection running loop panic”] [conn=362837] [lastSQL=“create global binding for select * from t2 where a = 8 and b=‘s’ using select * from t2 where a = 3 and b=‘s’”] [err=“runtime error: invalid memory address or nil pointer dereference”] [stack=“goroutine 56878269 [running]:\ngithub.com/pingcap/tidb/server.(*clientConn).Run.func1(0x38d3be0, 0xc00cdedf50, 0xc004462100)\

\t/home/jenkins/agent/workspace/optimization-build-tidb-linux-amd/go/src/github.com/pingcap/tidb/server/conn.go:725 +0xee\

panic(0x2fb0d20, 0x4f3ffc0)\

\t/usr/local/go/src/runtime/panic.go:679 +0x1b2\ngithub.com/pingcap/tidb/executor.getDbFromResultNode(0x38d5ba0, 0xc00cca5c30, 0xc00d0644c0, 0x1, 0x203002)\

\t/home/jenkins/agent/workspace/optimization-build-tidb-linux-amd/go/src/github.com/pingcap/tidb/executor/compiler.go:275 +0x480\ngithub.com/pingcap/tidb/executor.getDbFromResultNode(0x38d5ce0, 0xc010de6000, 0xc0120ca300, 0xc0004d6000, 0x7f4d46b70d98)\

\t/home/jenkins/agent/workspace/optimization-build-tidb-linux-amd/go/src/github.com/pingcap/tidb/executor/compiler.go:269 +0x158\ngithub.com/pingcap/tidb/executor.getDbFromResultNode(0x38d50a0, 0xc0114aaf00, 0xa018c063d3b6eb0f, 0xc00d0644c0, 0x1)\

\t/home/jenkins/agent/workspace/optimization-build-tidb-linux-amd/go/src/github.com/pingcap/tidb/executor/compiler.go:278 +0x390\ngithub.com/pingcap/tidb/executor.getStmtDbLabel(0x38dc620, 0xc010de6080, 0x1)\

\t/home/jenkins/agent/workspace/optimization-build-tidb-linux-amd/go/src/github.com/pingcap/tidb/executor/compiler.go:233 +0x5c3\ngithub.com/pingcap/tidb/executor.CountStmtNode(0x38dc620, 0xc010de6080, 0x391b100)\

\t/home/jenkins/agent/workspace/optimization-build-tidb-linux-amd/go/src/github.com/pingcap/tidb/executor/compiler.go:162 +0x18f\ngithub.com/pingcap/tidb/executor.(*Compiler).Compile(0xc00491ce78, 0x38d3be0, 0xc00affe2d0, 0x38dc620, 0xc010de6080, 0x0, 0x0, 0x0)\

\t/home/jenkins/agent/workspace/optimization-build-tidb-linux-amd/go/src/github.com/pingcap/tidb/executor/compiler.go:67 +0x32f\ngithub.com/pingcap/tidb/session.(*session).ExecuteStmt(0xc00ab79180, 0x38d3be0, 0xc00affe2d0, 0x38dc620, 0xc010de6080, 0x0, 0x0, 0x0, 0x0)\

\t/home/jenkins/agent/workspace/optimization-build-tidb-linux-amd/go/src/github.com/pingcap/tidb/session/session.go:1359 +0x286\ngithub.com/pingcap/tidb/server.(*TiDBContext).ExecuteStmt(0xc0077bc450, 0x38d3be0, 0xc00affe2d0, 0x38dc620, 0xc010de6080, 0x7f4d46b70d98, 0x0, 0xc005214ed0, 0x11c0083)\

\t/home/jenkins/agent/workspace/optimization-build-tidb-linux-amd/go/src/github.com/pingcap/tidb/server/driver_tidb.go:269 +0x65\ngithub.com/pingcap/tidb/server.(*clientConn).handleStmt(0xc004462100, 0x38d3be0, 0xc00affe2d0, 0x38dc620, 0xc010de6080, 0xc011910001, 0x0, 0x0)\

\t/home/jenkins/agent/workspace/optimization-build-tidb-linux-amd/go/src/github.com/pingcap/tidb/server/conn.go:1449 +0x8e\ngithub.com/pingcap/tidb/server.(*clientConn).handleQuery(0xc004462100, 0x38d3be0, 0xc00affe2d0, 0xc0041a11f1, 0x6d, 0x0, 0x0)\

\t/home/jenkins/agent/workspace/optimization-build-tidb-linux-amd/go/src/github.com/pingcap/tidb/server/conn.go:1438 +0x225\ngithub.com/pingcap/tidb/server.(*clientConn).dispatch(0xc004462100, 0x38d3b20, 0xc013135fc0, 0xc0041a11f1, 0x6e, 0x6d, 0x0, 0x0)\

\t/home/jenkins/agent/workspace/optimization-build-tidb-linux-amd/go/src/github.com/pingcap/tidb/server/conn.go:1016 +0x723\ngithub.com/pingcap/tidb/server.(*clientConn).Run(0xc004462100, 0x38d3be0, 0xc00cdedf50)\

\t/home/jenkins/agent/workspace/optimization-build-tidb-linux-amd/go/src/github.com/pingcap/tidb/server/conn.go:785 +0x293\ngithub.com/pingcap/tidb/server.(*Server).onConn(0xc002233ce0, 0xc004462100)\

\t/home/jenkins/agent/workspace/optimization-build-tidb-linux-amd/go/src/github.com/pingcap/tidb/server/server.go:452 +0xb0d\

created by github.com/pingcap/tidb/server.(*Server).Run\

\t/home/jenkins/agent/workspace/optimization-build-tidb-linux-amd/go/src/github.com/pingcap/tidb/server/server.go:355 +0x7c9\

”]