为提高效率,提问时请提供以下信息,问题描述清晰可优先响应。

- 【TiDB 版本】:3.0.7

- 【问题描述】:查看监控发现Tombstone Stores有7个,不知道怎么处理

pd这个节点重启过服务器,其他节点没动

为提高效率,提问时请提供以下信息,问题描述清晰可优先响应。

麻烦把整个over-view的监控截图一下,我想看看当前集群的状态和情况,另外你怎么remove的命令也发一下,都做了什么操作,多谢

在哪个监控下的哪个图? 我在pd上直接stores remove-tombstone

所有的over-view的监控

tidb图形太多了= =

当前没有up的节点吗? 你有几个pd,当时是所有pd都down了吗? 现在集群启动了吗?

有三个pd,只down了这一个节点,现在集群都启动起来了

沟通使用的自己的监控,请尝试先更新下监控多谢.

你好,我遇到了一个问题想要问:

今天有个tikv节点tombstone了,然后使用stores remove-tombstone 去掉了这个节点

查看集群信息:

然后我使用scale-out来扩容tikv节点,依旧使用原来tombstone的这台机器来扩容:

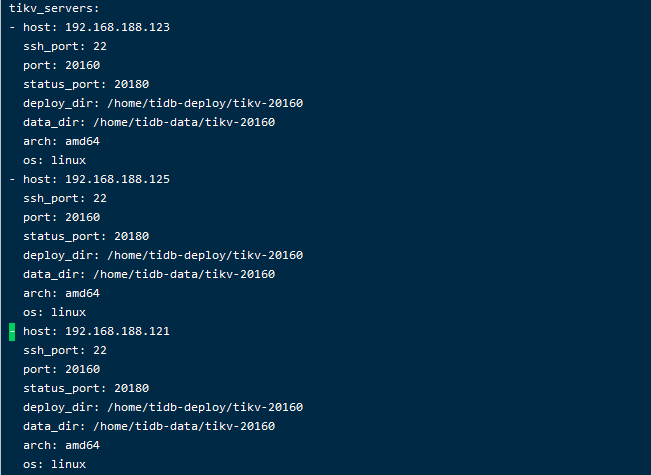

root@mater-db:~/.tiup# cat scale-out.yaml

tikv_servers:

但是扩容时报错了,请问这个要怎么解决呢?

查看日志 cat /root/.tiup/logs/tiup-cluster-debug-2020-10-27-11-28-56.log | tail -n 200

查看tiup的启动文件,里面依旧存在这个节点信息

想编辑删掉192.168.188.121节点,tiup cluster edit-config tidb-cluster,好像删不掉

tiup cluster prune tidb-cluster 试试

请问,你这个问题解决了吗?我现在也是碰到这个问题了

这个可能是你在做 delete store 时候,etcd 里面没有清理的记录信息,如果有做过缩容 TiKV 可能是预期的。

那我应该怎么操作嗯?

tiup cluster prune tidb-cluster 试试