【 TiDB 使用环境】

全部采用本地nvme存储解决方案,15台服务器的小规模集群,kubernetes版本为v1.20,tidb集群使用tidb-operator部署

【概述】:场景 + 问题概述

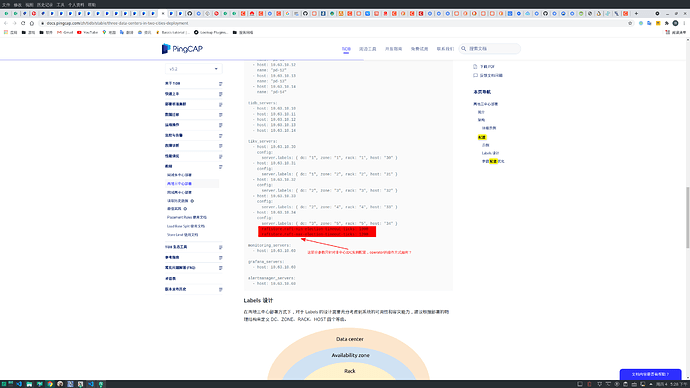

正在测试异地多方案,需要修改已通过tidb-operator部署的一个在线的tidb集群的一些参数,为方便说明,举一个栗子,比如需要修改server.grpc-compression-type: gzip参数,开启传输的压缩模式,减少IDC之间的流量,两地三中心部署方案已经明确了一些优化参数,我查看发现在现有的tidb集群上需要调整参数,但是文档里的是tiup的参数调整栗子,有没有tidb-operator版本的?是全部参数都支持调整还是只支持部分参数?如果是部分参数,那么现有版本的tidb-operator支持哪些参数的线上调整

【背景】:做过哪些操作

- 尝试使用

topologySpreadConstraints替换podAntiAffinity

- IDC/Rack/Host级别的Label已经添加

- 已通过

pd-ctl开启enable-placement-rules

- 正在尝试 Placement Rules的方式,但测试前还需要调整一些参数。

【现象】:业务和数据库现象

【问题】:当前遇到的问题

不明确如何在tidb-operator方式下调整参数

【业务影响】:阻碍方案测试,等待建议及解决方案

【TiDB 版本】:V5.1.1

【TiDB Operator 版本】:v1.2.0

【K8s 版本】:v1.20.6

2 个赞

Sorry,刚看了下,稍微还有些歧义,给一个完整的说明:

在kubernetes上通过kubectl edit tc tidb-cluster-name查看现有TiKV的配置如下:

tikv:

baseImage: pingcap/tikv

config: |

prevote = true

[storage]

[storage.block-cache]

capacity = "16GB"

需要添加的配置是grpc-compression-type,所以改成如下:

tikv:

baseImage: pingcap/tikv

config: |

prevote = true

[storage]

[storage.block-cache]

capacity = "16GB"

[server]

grpc-compression-type = gzip

问题:

-

grpc-compression-type可以直接对在线的TiKV实例修改吗?是否会有tidb本身的功能造成影响,比如造成线上业务的抖动

-

TIKV参数说明文档中所描述的参数都支持这种更新方式吗?还是只允许部分参数这样在线更新

1 个赞

Kongdom

(Kongdom)

3

1 个赞

恩,目前测试的场景,应该是更细化的需求,可能是希望有一些best practise的参考

1 个赞

这道题我不会

(Lizhengyang@PingCAP)

9

目前通过 tidb-operator 进行异地多活部署的案例还比较少,如果你这边有相关需求,也可以在需求版本中提下,谢谢。

另外,请问一下,类似pd和kv这种关键组件,单独配置实例参数,在operator方式下具体需要怎么操作?比如:

恩,好的,其实这个问题,仍然是operator配置指定的某个副本参数的问题

这个问题暂时还没有解决,operator修改同类型组件但部署于不同IDC的实例,这种修改需要分实例配置,暂时没有找到这方面的资料,有一个tiup的设置,但在思考如何改成云原生化的方式

system

(system)

关闭

16

此话题已在最后回复的 1 分钟后被自动关闭。不再允许新回复。