【 TiDB 使用环境】

【概述】:场景 + 问题概述

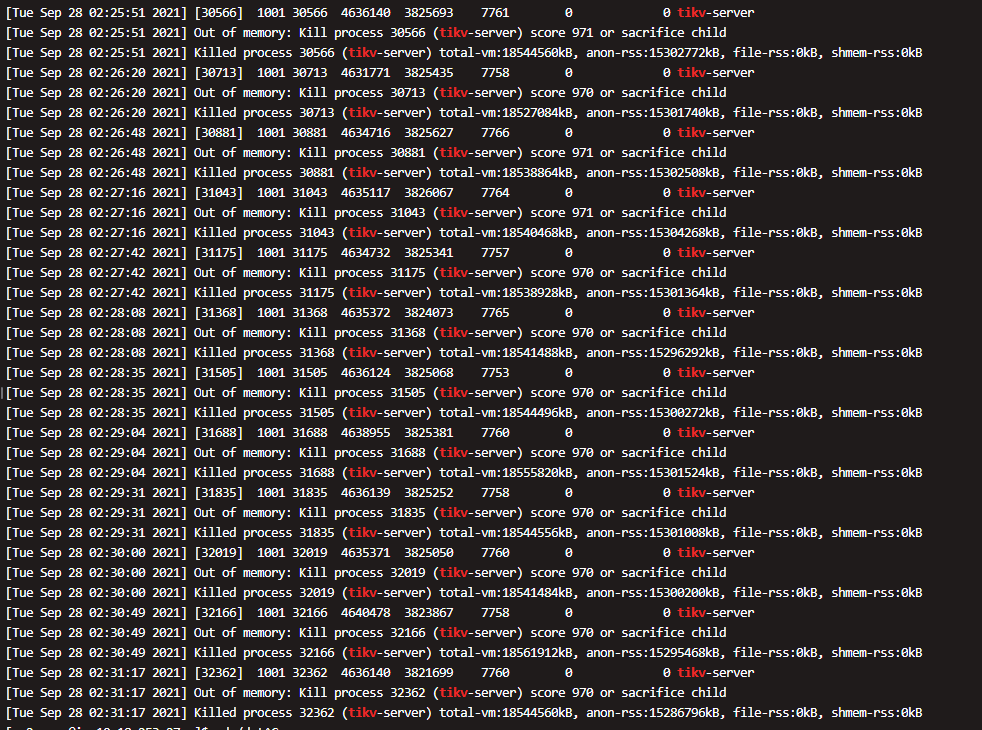

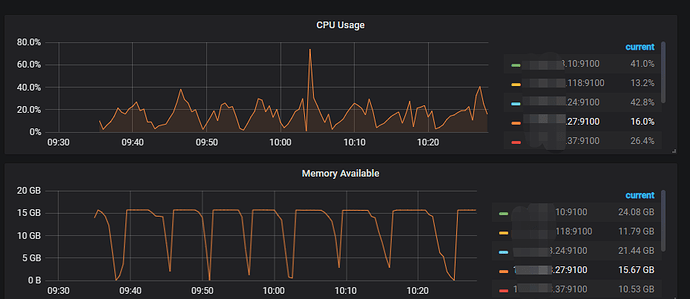

有一台tikv宕机了,重启机器后,tikv开始OOM和无限重启

【背景】:做过哪些操作

一台tikv宕机,重启机器后,tikv起不来

【现象】:业务和数据库现象

tikv 宕机,dmesg 显示oom

【问题】:当前遇到的问题

tikv 无法提供服务

【业务影响】:

生产一台tikv无法工作,无限重启

【TiDB 版本】:

5.0.3

【附件】:

2 个赞

然后现在又开始报这个错误了:

[ERROR] [server.rs:880] [“failed to init io snooper”] [err_code=KV:Unknown] [err=“"IO snooper is not started due to not compiling with BCC"”]

磁盘空间是够的

2 个赞

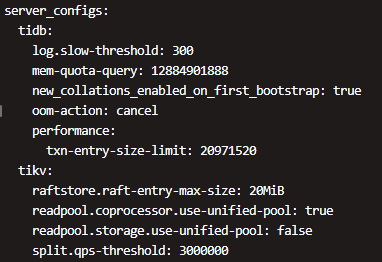

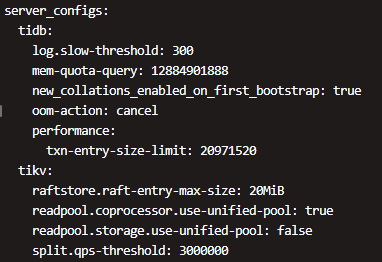

9台机器,3台pd+tidb,3台tikv,3台tiflash,这3台tikv配置是8C/16G, 该集群正常跑了2个月左右,宕机原因我们大致清楚,当时有通过jdbc100并发写入,27节点tikv宕机重启,持续了近两个小时,服务器也直接宕机了, 把服务器起来后,tikv启动就开始报这个错了,现在没有数据写入了,27这个节点还是起不来,我们想先解决问题,先能够正常起起来

2 个赞

tikv.tar.gz (18.4 MB)

这个是一个300M的日志

2 个赞

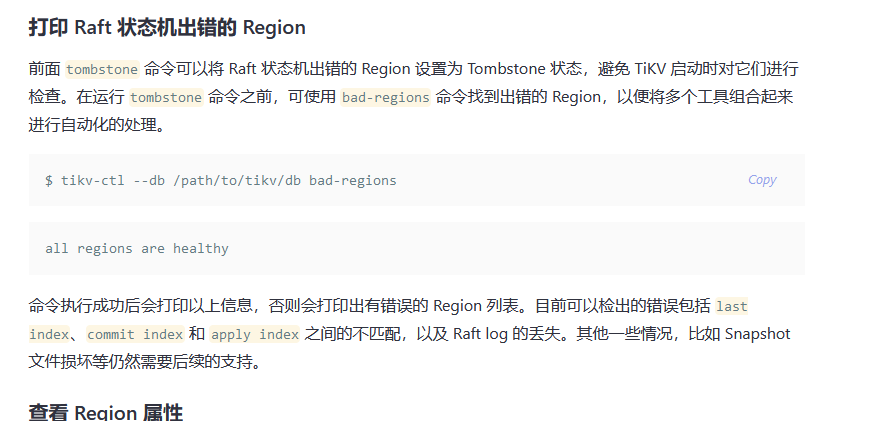

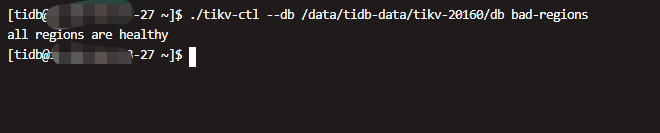

就是说可能是服务器停机,导致raft 状态机丢失的问题是吧,可以通过下面的命令,将region设置为tombstone,但是怎么能获取错误的region呢

2 个赞

故障节点如果已经完全不可用,是否可以强制下线,然后在扩容回集群来处理此问题,已达到快速恢复的目的

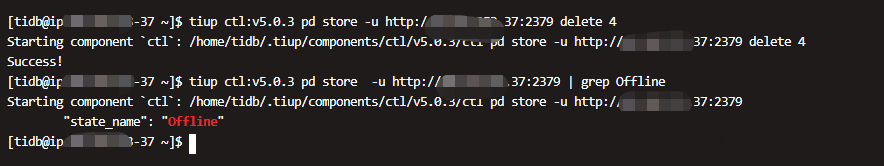

已经强制下线了,现在扩容回来报 store重复了没起来, 然后我现在对这个节点再强制下线了,我看了下pd中的数据没被删除啊,这个store还在

你看上面的截图,返回success,但是查的话还是在的,–force 只是把这个节点下了,但是pd中的store和region信息都还在,而且还删不了, tikv是3副本,现在强制下掉一个,机器数<副本数,所以pd没删这些元数据?

我看了下这个id=4的store,offline的,下面的region 2w多,但都不是leader,该怎么操作。现在集群只有两个tikv了。。。

改了端口在这个节点新起了一个tikv实例,pd这个脏数据怎么删除呢老师

直接pd下线不掉故障的store吗

直接pd下线不掉故障的store吗