seiang

(Seiang)

1

为提高效率,请提供以下信息,问题描述清晰能够更快得到解决:

【 TiDB 使用环境】

生产环境v5.0.3

【概述】 场景 + 问题概述

协议用的是maxwell

protocol = “maxwell”

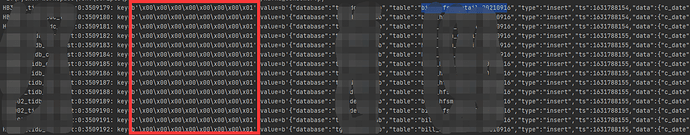

通过ticdc将tidb的数据写入到kafka中,出现了key乱码的问题,如下所示:

导致所有的数据都写入了一个partion中,该问题要如何解决?

【附件】

- 相关日志、配置文件、Grafana 监控(https://metricstool.pingcap.com/)

- TiUP Cluster Display 信息

- TiUP CLuster Edit config 信息

- TiDB-Overview 监控

- 对应模块的 Grafana 监控(如有 BR、TiDB-binlog、TiCDC 等)

- 对应模块日志(包含问题前后 1 小时日志)

若提问为性能优化、故障排查类问题,请下载脚本运行。终端输出的打印结果,请务必全选并复制粘贴上传。

xfworld

(魔幻之翼)

2

这个不是乱码阿,kafka 的 topic (Key , Value) 给的什么格式呢?

这个是可以正常读取和写入的

seiang

(Seiang)

3

您好,“kafka 的 topic (Key , Value) 给的什么格式呢?”,这句话没有太理解什么意思?麻烦您具体说明一下

使用的是ticdc写入的kafka,协议用的是maxwell

xfworld

(魔幻之翼)

4

key 和 value 需要配置格式的,比如常用的 String 的格式,或者 byte[] ,或者其他的…

seiang

(Seiang)

5

上面截图是直接从kafka中拿到的数据,看格式好像是byte类型,这个正常key应该是什么数据类型和数据格式呢?

xfworld

(魔幻之翼)

6

你配置成什么就是什么了,至于类型是什么都不会影响读写

但是会影响你的观测

kafka 单 partion 也没问题,可以保证数据在时序上的一致性

seiang

(Seiang)

7

还是没有理解,“配置成什么就是什么了”,类型我就没有配置呀

xfworld

(魔幻之翼)

8

环境是你自己的阿,你得检查下,默认配置是什么,这样说,能理解么…

seiang

(Seiang)

9

你说的环境的默认配置是指cdc的配置?还是kafka的配置?还是代码程序的配置?

seiang

(Seiang)

11

没有,不知道问题点出在哪里,您这边觉得是哪里的问题呢

spc_monkey

(carry@pingcap.com)

12

首先呢,这不是问题,上面的意思,我觉得表达很清晰啊

seiang

(Seiang)

13

嗯嗯,可能楼上说的比较清楚,但是我还是没理解,因为初次接触,可能理解的不够深,我知道不是乱码,看结果输入应该是byte类型,我理解那这就需要我代码来做转化?

spc_monkey

(carry@pingcap.com)

14

如果你确实需要这部分内容的话,需要你自己做:不过你先确认 1、这个 key 是你要的信息不。 2、cdc 支持多个协议的,你可以先确认是否其他协议满足你的需求 。

seiang

(Seiang)

15

key的信息不是我需要的,但是就是好奇这里key具体存储的是什么内容,而且这个key的内容也都一样

spc_monkey

(carry@pingcap.com)

16

这个具体key 的定义格式,得看 github 了

system

(system)

关闭

19

此话题已在最后回复的 1 分钟后被自动关闭。不再允许新回复。