为提高效率,请提供以下信息,问题描述清晰能够更快得到解决:

【 TiDB 使用环境】

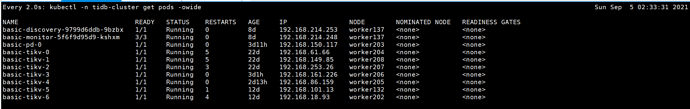

使用k8s,tidb-operator1.1.12部署tikv5.1.0

【概述】 场景 + 问题概述

使用tikv-clent-java3.1.0写入kv集群,目前想要使用br工具备份到本地盘

【备份和数据迁移策略逻辑】

使用br命令行备份出现以下问题

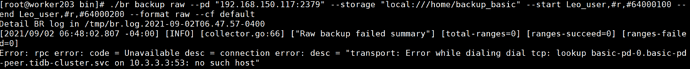

[INFO] [collector.go:66] [“Raw backup failed summary”] [total-ranges=0] [ranges-succeed=0] [ranges-failed=0]

Error: rpc error: code = Unavailable desc = connection error: desc = “transport: Error while dialing dial tcp: lookup basic-pd-0.basic-pd-peer.tidb-cluster.svc on 10.3.3.3:53: no such host”

进入pd容器内运行如下

想问一下,k8s环境下是不支持使用Br命令工具备份吗?

还有备份到本地盘内,备份文件最终是散布在tikv各个节点吗

【背景】 做过哪些操作

【现象】 业务和数据库现象

【问题】 当前遇到的问题

【业务影响】

【TiDB 版本】

【附件】

- 相关日志、配置文件、Grafana 监控(https://metricstool.pingcap.com/)

- TiUP Cluster Display 信息

- TiUP CLuster Edit config 信息

- TiDB-Overview 监控

- 对应模块的 Grafana 监控(如有 BR、TiDB-binlog、TiCDC 等)

- 对应模块日志(包含问题前后 1 小时日志)

若提问为性能优化、故障排查类问题,请下载脚本运行。终端输出的打印结果,请务必全选并复制粘贴上传。

目前不支持 RawKB 的 BR 备份,请按照文档介绍部署 BR 并且完成全亮备份。

可是我用的rawkv所以是裸kv集群,没有tidb

我尝试全量备份,backup-nfs.yaml如下

apiVersion: pingcap.com/v1alpha1

kind: Backup

metadata:

name: basic-backup-localstorage

namespace: tidb-cluster

spec:

toolImage: pingcap/br:v5.1.0

#backupType: raw

cleanPolicy: Delete

#storageClassName: local-storage

##Only needed for TiDB Operator < v1.1.10 or TiDB < v4.0.8

#from:

#host: ${tidb-host}

#port: ${tidb-port}

#user: ${tidb-user}

#secretName: backup-demo1-tidb-secret

br:

cluster: basic

clusterNamespace: tidb-cluster

logLevel: info

#statusAddr: ${status-addr}

concurrency: 4

rateLimit: 4

checksum: true

#options:

#- --start=Leo_user,#r,#64000100

# --end=Leo_user,#r,#64000200

# --format=raw

# --cf=default

local:

prefix: backup-nfs

volume:

name: nfs

nfs:

server: 10.77.50.203

path: /home/nfs-share

volumeMount:

name: nfs

mountPath: /home/nfs-share

#nodeSelector:

#kubernetes.io/hostname: worker203

affinity:

nodeAffinity:

requiredDuringSchedulingIgnoredDuringExecution:

nodeSelectorTerms:

- matchExpressions:

- key: kubernetes.io/hostname

operator: In

values:

- worker203

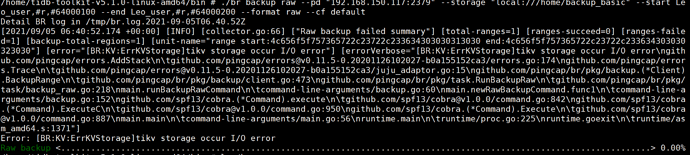

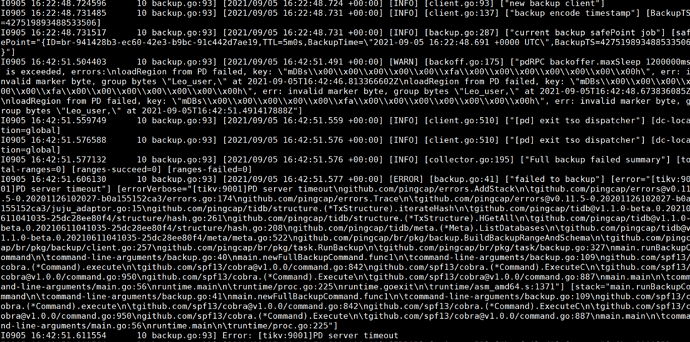

运行20分钟以后出现如下错误

这是因为什么呢

这个问题

k8s部署的tikv集群能使用BR命令行工具吗?

。。。我上面用的就是nfs,不行

K8s 下备份 RawKV 数据到本地盘 - 备份&数据迁移 - AskTUG

我现在的情况,第一是k8s环境部署的裸kv集群,第二使用的是 RawKV读写集群,现在我想问目前只有BR命令行工具支持RawKV备份,那么k8s环境下能使用BR命令行工具吗

(前面也说了K8S目前部署BR节点全量备份是不支持裸Kv集群的)

你们回答的零零散散的,都不看前提条件,我这没法参考啊

懂的都懂

(wangtianyi)

11

K8s 下备份 RawKV 数据到本地盘 - 备份&数据迁移 - AskTUG

看一下这个

k8s环境下部署的tikv集群能否使用BR命令行工具

k8s环境下使用backup.yaml部署节点全量备份时不支持裸KV集群备份,更换S3存储就支持了?

懂的都懂

(wangtianyi)

13

官方文档没有提到这两个问题,同时您也没有正面回答我这两个问题

https://asktug.com/uploads/default/original/3X/a/8/a8ee6f7fc67595aa8a0f1a5e2161b9a55e9c52f6.png 这种方式可以,这种方式 TiKV 是用的 NFS? 这样的话用本地盘应该也可以,TiKV 都挂载了 PV,在 /var/lib/tikv 目录,可以在这下面建子目录给备份用,不过备份会分散在各个 TiKV 上。

如果还有问题可以在这里回复。

tikv storage occur I/O error 的原因是 TiKV 写备份文件的时候报出来的错误,从 tikv 日志能看到具体的错误吗?

我今天给tikv挂了nfs网盘之后,执行命令成功。

(上次报错看了日志,是个别tikvpod内没创建目录)