为提高效率,请提供以下信息,问题描述清晰能够更快得到解决:

【概述】 场景 + 问题概述

【背景】 做过哪些操作

【现象】 业务和数据库现象

【业务影响】

【TiDB 版本】

【附件】 相关日志及配置信息

TiUP Cluster Display 信息

TiUP CLuster Edit config 信息

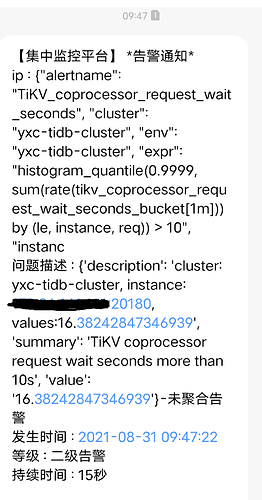

监控(https://metricstool.pingcap.com/ )

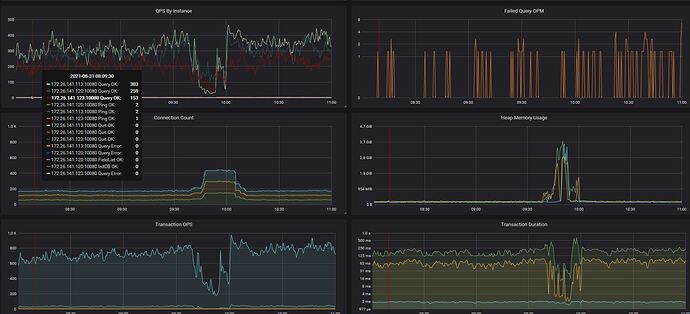

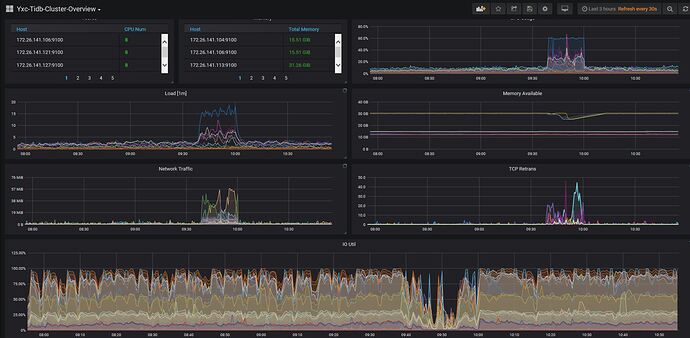

TiDB-Overview Grafana监控

TiDB Grafana 监控

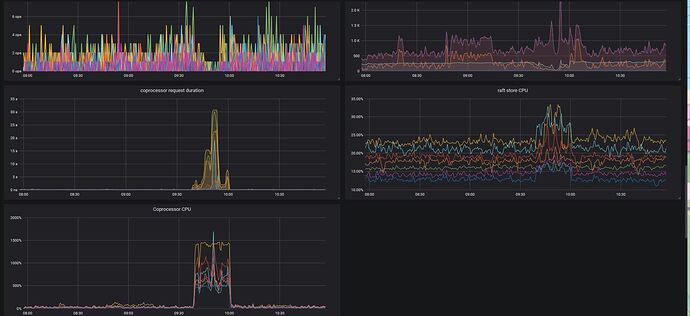

TiKV Grafana 监控

PD Grafana 监控

对应模块日志(包含问题前后 1 小时日志)

若提问为性能优化、故障排查 类问题,请下载脚本 运行。终端输出的打印结果,请务必全选 并复制粘贴上传。

1 个赞

tikv.log (3.8 MB) tikv日志如下

1 个赞

dashboard 看下 keyviz 热点表

1 个赞

慢查询都是走了索引的,平时执行也比较快。 3.0.9版本没有keyviz

1 个赞

这道题我不会

2021 年9 月 2 日 10:04

5

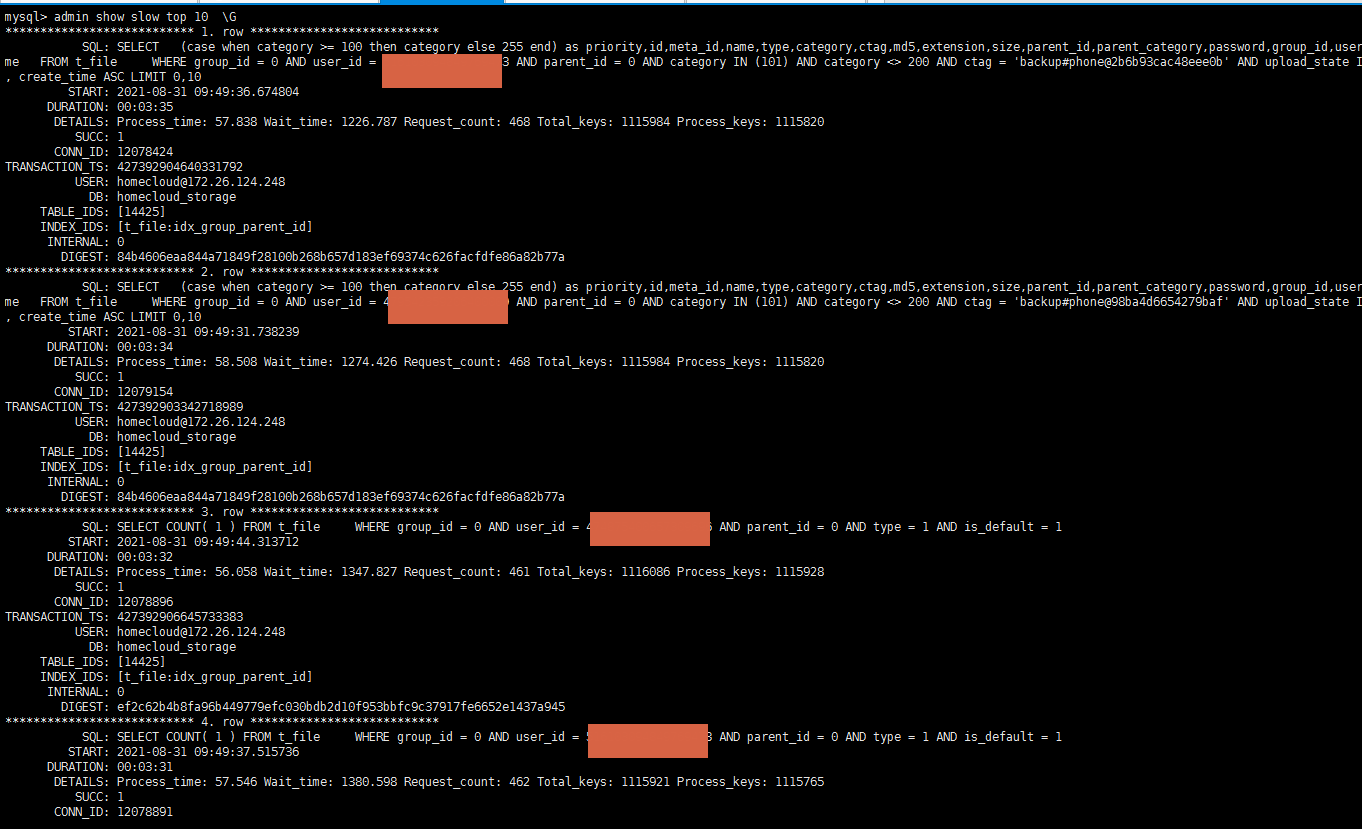

从 tikv 日志中看 从 9:38 开始有大量的慢查询,建议重点排查下慢 SQL ,看下是否是 SQL 执行计划发生改变等原因导致的,可以根据慢日志中的 process_keys 进行下排序,SQL 语句类似:

select query_time, query, digest

from information_schema.slow_query

where is_internal = false

AND time >= '2021-08-31 09:30:00'

AND time < '2021-08-31 10:10:00'

order by Process_keys desc

limit 10;

谢谢 经过排查,发现一条慢查语句使用的索引字段出现某一个值数据量过大导致查询过慢,优化后后续我们再观察一下。

system

2022 年10 月 31 日 19:22

7

此话题已在最后回复的 1 分钟后被自动关闭。不再允许新回复。