前置条件

KV entry 表示的是 一行的数据

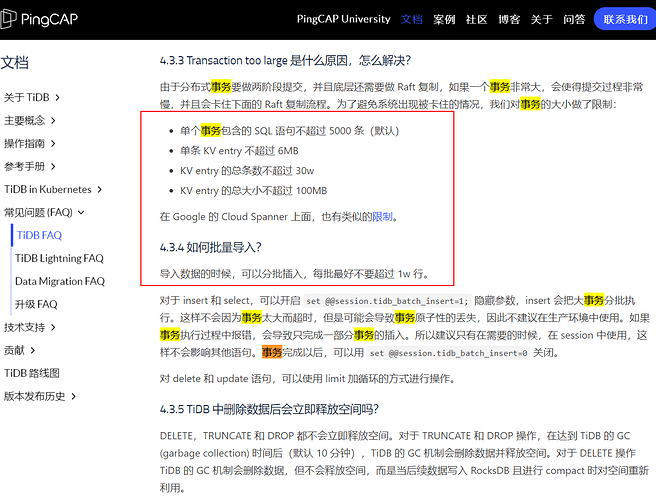

1 最大事务数是多少?

2 一个事务最大限制是 5000 条SQL, 每条 SQL 10000 个 values?

3 计算方式是什么?

4 数据是由客户上传不能确定单条数据 在6M以内,总大小不超过 100M?

5 set @@session.tidb_batch_insert=1; 的作用是什么?

6 如果一直开启 set @@session.tidb_batch_insert=1; ,而程序里面不做分批插入会怎么样?

7 我应该如何合理的 计算最大事务条数

8 例如 表:table_test 1千万数据, 大小 3G 左右, 执行语句更新 1千万数据的 name:

UPDATE table_test SET name;

根据文档所说,是受到了哪一条限制的影响?

9 如果一直开启 set @@session.tidb_batch_insert=1; 一个事务中 保证不超过30W 的限制, 但是 超过单条 KV entry 6M , 也超过 KV entry 的总大小 100MB, 这会怎么样?也会丢失原子性吗?

10 UPDATE 操作时的计算方式 也是与 INSERT 限制一样的对吗?

11 如果不一样,是按照被修改的列计算的 KV entry 大小, 还是计算这一整行的数据大小

12 更新数据 如何限制,更新的数据不能超过100MB

13 DELETE 操作时的计算方式 也是与 INSERT 限制一样的对吗?