Polar

(Hacker T Pc Mw G Jh)

1

为提高效率,请提供以下信息,问题描述清晰能够更快得到解决:

【 TiDB 使用环境】

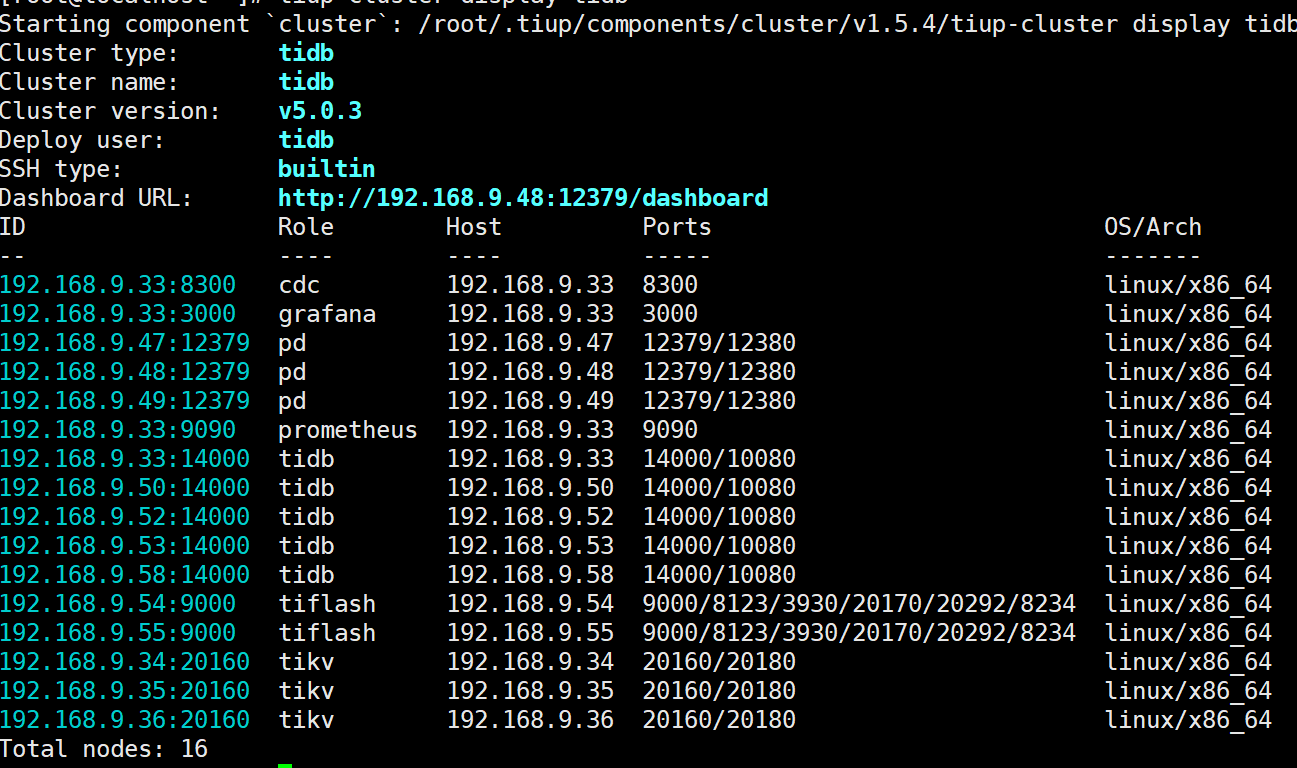

版本 v5.0.3

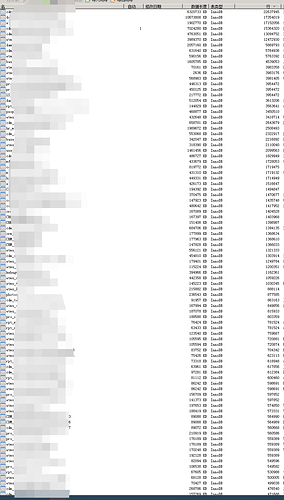

生产环境使用,现在数据量总量在5000w左右,备份完是74G数据。预计并发要支持1w

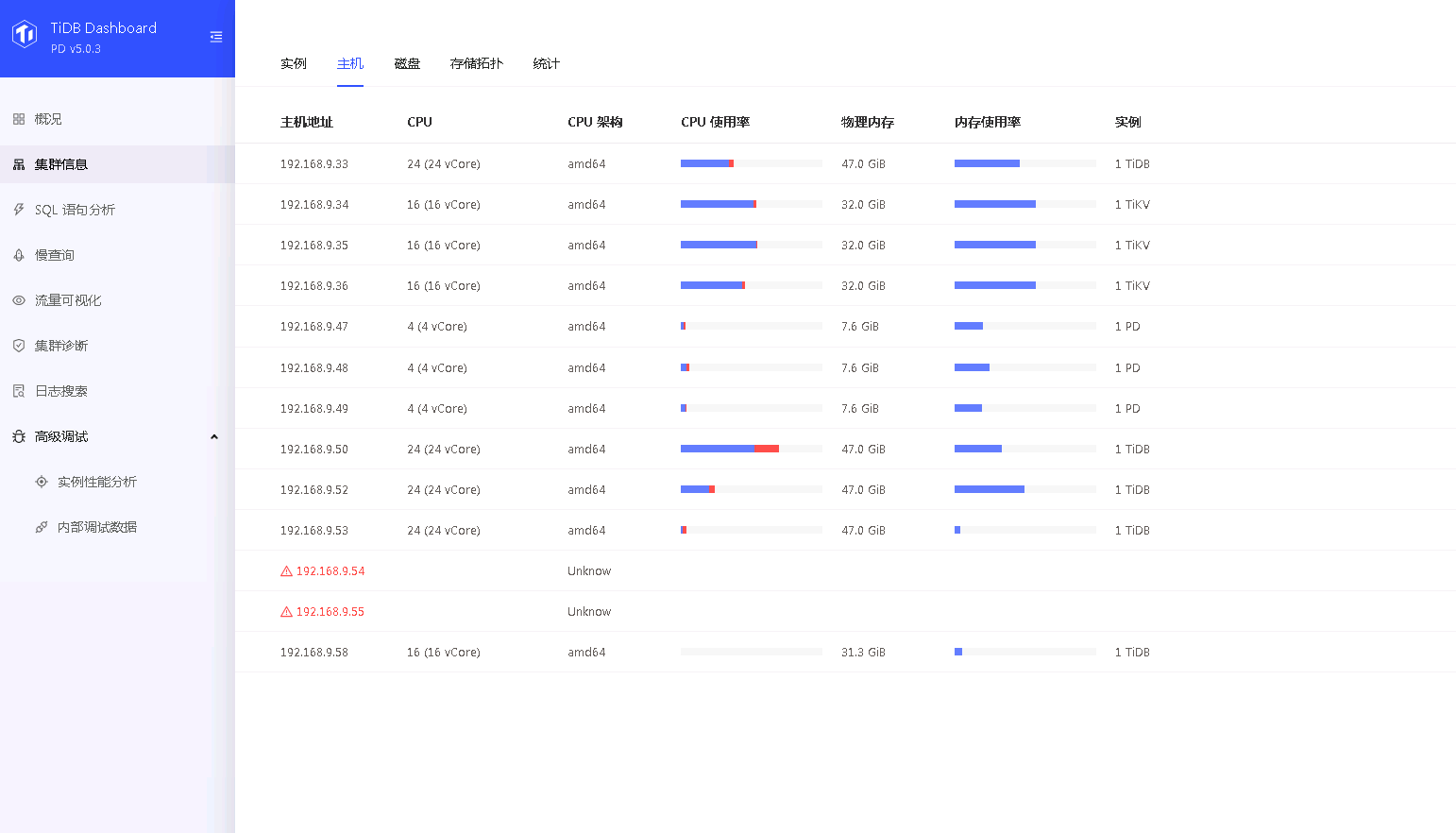

现在配置如下图,因为有多个项目在用,所以tidb节点分开使用的。

在执行复杂查询时,tidb节点内存会不够用,引入tiflash节点后,16C32G 2副本,资源不够用,导致集群卡死,暂时关闭了tiflash节点。

请问当前数据量下 集群配置多少合理(cpu 内存 节点分配)?

当前哪个版本比较好一些?

1 个赞

QBin

(Bin)

2

> 在执行复杂查询时,tidb节点内存会不够用,引入tiflash节点后,16C32G 2副本,资源不够用,导致集群卡死,暂时关闭了tiflash节点

Tiflash 是作为 learner 的角色加入到集群,就算发生异常应该也不会影响集群其他访问。麻烦详细描述一下 “卡死” 这个现象的报错,以及检查一下 TIDB 的相关日志。

> 请问当前数据量下 集群配置多少合理(cpu 内存 节点分配)?

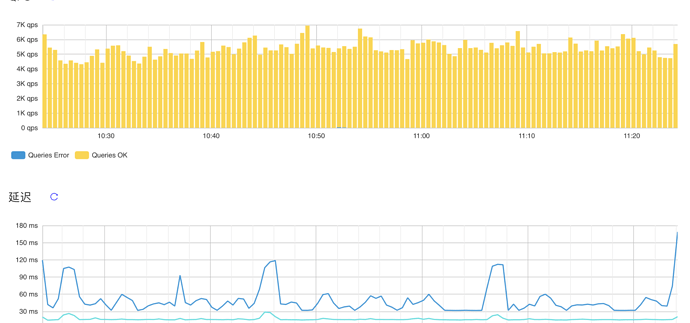

目前集群状态是怎样,QPS 以及 999 duration 是多少?是目前延迟不能满足业务需求嘛?

2 个赞

Polar

(Hacker T Pc Mw G Jh)

3

1.本来在不引入tiflash时,查询主要消耗在tikv和tidb上,能满足基本使用,但复杂查询比较慢,所以想着引入tiflash来进行加速,但是引入后发现tiflash的内存不够支撑查询,所以暂时关闭了。而且5.0.3的tiflash有个bug(使用Limit不走tiflash - #10,来自 zanmato),效果不理想

2.目前集群能满足基本使用,复杂查询比较慢。

Polar

(Hacker T Pc Mw G Jh)

6

你们多大数据量的?

能不能给推荐下集群配置 节点分配

Polar

(Hacker T Pc Mw G Jh)

8

没有解决。

现在集群时不时tidb节点会内存 cpu占满(24c 48g 2台)。加了tiflash节点,tiflash(16c 32g 2台)会占满,现在取消了tiflash节点。

system

(system)

关闭

9

此话题已在最后回复的 1 分钟后被自动关闭。不再允许新回复。