【TiDB 使用环境】测试/ Poc

【TiDB 版本】4.0.0

【操作系统】K8S部署

【部署方式】单机测试

【集群数据量】

【集群节点数】1

【问题复现路径】节点断电重启

【遇到的问题:问题现象及影响】apply index和raft index不一致,导致tikv启动失败

【资源配置】

【复制黏贴 ERROR 报错的日志】

【其他附件:截图/日志/监控】

[FATAL] [server.rs:576] [“failed to start node: EngineTraits(Other("[components/raftstore/src/store/fsm/store.rs:812]:

\"[components/raftstore/src/store/peer_storage.rs:578]: [region 2] 3 validate state fail: Other(\\\"[components/raftstore/src/store/peer_storage.rs:444]:

raft state hard_state { term: 6 vote: 3 commit: 211068331 } last_index: 211068331 not match apply state applied_index: 211068413

last_commit_index: 211068412 commit_index: 211068413 commit_term: 6 truncated_state { index: 211068360 term: 6 }

and can\\\\\\\'t be recovered.\\\")\""))”]

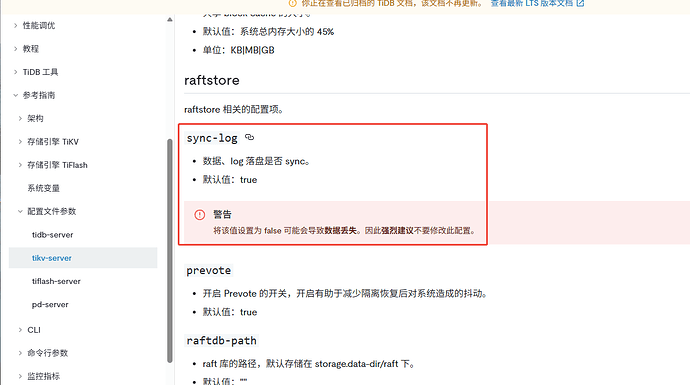

只要断电重启,大概率出现这个问题,应该是整个机制的问题;有哪些好的办法恢复,尽量不要丢数据,不然测试数据要全部重做。