老鹰506

(Ti D Ber Uhzt Tfx J)

1

【TiDB 使用环境】生产环境

【TiDB 版本】7.5.3

【操作系统】3.10.0-693.el7.x86_64

【部署方式】机器部署(什么机器配置、什么硬盘)

【集群数据量】约6TB

【集群节点数】10各tikv节点部署在5台服务商

【问题复现路径】

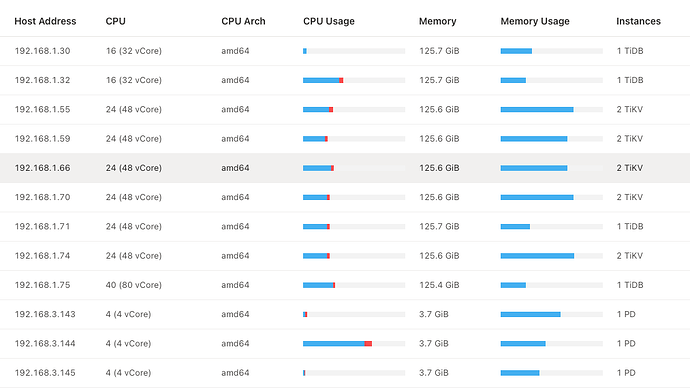

【资源配置】进入到 TiDB Dashboard -集群信息 (Cluster Info) -主机(Hosts) 截图此页面

【遇到的问题:问题现象及影响】

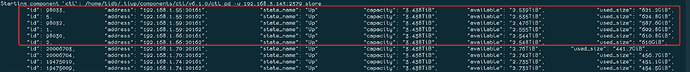

如图所示,上面6个节点的存储远高于下面4个节点 (10个节点部署在5台服务上),如何优化平衡这个数据量呢?

db_user

(Db User)

2

tikv打label了么,同一台机器的label是一致的话应该不会有太大差别

_一十二十一

(Ti D Ber K B Fahnjh)

3

实际使用过程中,以往的经验感觉这些差异不算特别大的

老鹰506

(Ti D Ber Uhzt Tfx J)

4

打标签了,不过一个主机上部署两个tikv节点,这两个节点的标签是一致的。

如果是这种方式的话,是保持一致更好些还是标签不一致更好呢?

老鹰506

(Ti D Ber Uhzt Tfx J)

5

主要是数据量不算太大吧, 600和400相对比的话,差的有点大吧?

db_user

(Db User)

6

是要保持一致的,不然挂一台机器有可能损失两个副本了,你这个磁盘使用率百分比应该是很接近的吧,如果是这样的话其实没啥差

老鹰506

(Ti D Ber Uhzt Tfx J)

7

按照你这个理解,比如主机A上部署两个tikv节点,这两个节点的server.labels都是 host-a,然后主机B上部署两个tikv节点,这两个节点的server.labels都是 host-b

那么如果这两个主机都挂掉了(假设集群有5个主机,10个tikv节点)。按照你的理解不会影响集群对外提供服务码?

老鹰506

(Ti D Ber Uhzt Tfx J)

9

嗯嗯,那我理解了,集群能否对外提供有效服务,是取决的坏的tikv节点数量和配置的副本数; 标签的目的是均衡数据region

老鹰506

(Ti D Ber Uhzt Tfx J)

10

最终查到问题是,有两个主机上的4个节点的server.labels配置成一样的导致该问题,修复其中两个节点的配置,重启tikv节点之后,数据开始追平

system

(system)

关闭

11

此话题已在最后回复的 7 天后被自动关闭。不再允许新回复。