【TiDB 使用环境】生产环境 /测试/ Poc

【TiDB 版本】

【操作系统】

【部署方式】云上部署(什么云)/机器部署(什么机器配置、什么硬盘)

【集群数据量】

【集群节点数】

【问题复现路径】做过哪些操作出现的问题

【遇到的问题:问题现象及影响】

【资源配置】进入到 TiDB Dashboard -集群信息 (Cluster Info) -主机(Hosts) 截图此页面

【复制黏贴 ERROR 报错的日志】

【其他附件:截图/日志/监控】

扩容tikv后

再收缩tikv

tiup cluster scale-in tidb-test --node 2.1.1.10:20160

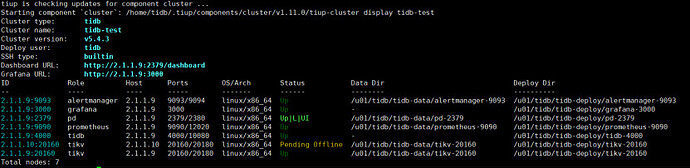

tiup cluster display tidb-test

等了很久也没有变为 tombstone

新建立的集群,没有数据。

怎么让他变为 tombstone状态。

见附件。

Q_Tidb_2_收缩tikv节点后状态一直在Pending Offline.docx (129.6 KB)