【TiDB 使用环境】生产环境

【TiDB 版本】v4.0.7

【操作系统】Amazon Linux 2

【部署方式】云上部署 AWS

【集群数据量】TB级

【集群节点数】待确认

【问题复现路径】做过哪些操作出现的问题

之前的版本:

TiDB Operator:V1.1.6

TiDB cluster:v4.0.7

操作,升级tidb operator过程中,遇到问题,按照deepseek的提示,卸载重装,

卸载过程中删了一些东西

kubectl delete crd tidbclusters.pingcap.com tidbmonitors.pingcap.com backups.pingcap.com restores.pingcap.com

kubectl delete clusterrole,clusterrolebinding -l app.kubernetes.io/instance=tidb-operator

kubectl delete all,secret,configmap -l app.kubernetes.io/instance=tidb-operator -n tidb-admin

然后tc就没有了,tidb-cluster命名空间下没有资源了

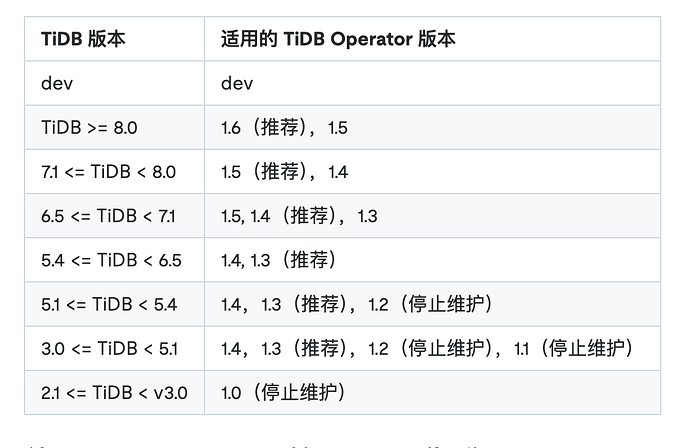

现在TiDB Operator已经升级到了v1.6.1

【遇到的问题:问题现象及影响】

没有备份的tidb-cluster.yaml文件,但是PVC都还在,另外还有最近备份的一个tidb-cluster命名空间下的statefulset文件。

现在需要从这个pvc中恢复原来的集群,这样可以做到吗

【资源配置】进入到 TiDB Dashboard -集群信息 (Cluster Info) -主机(Hosts) 截图此页面

暂无dashboard

【复制黏贴 ERROR 报错的日志】

【其他附件:截图/日志/监控】