【TiDB 使用环境】生产环境

【TiDB 版本】6.5.4

【操作系统】centos7

【部署方式】机器部署(48核 256G 3T nvme)* 6

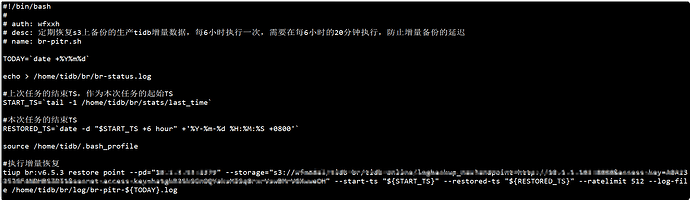

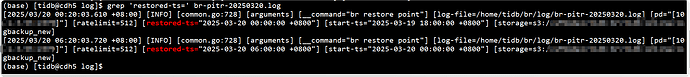

上游集群通过 br pitr备份到对象存储,并每6小时恢复到下游集群一次。

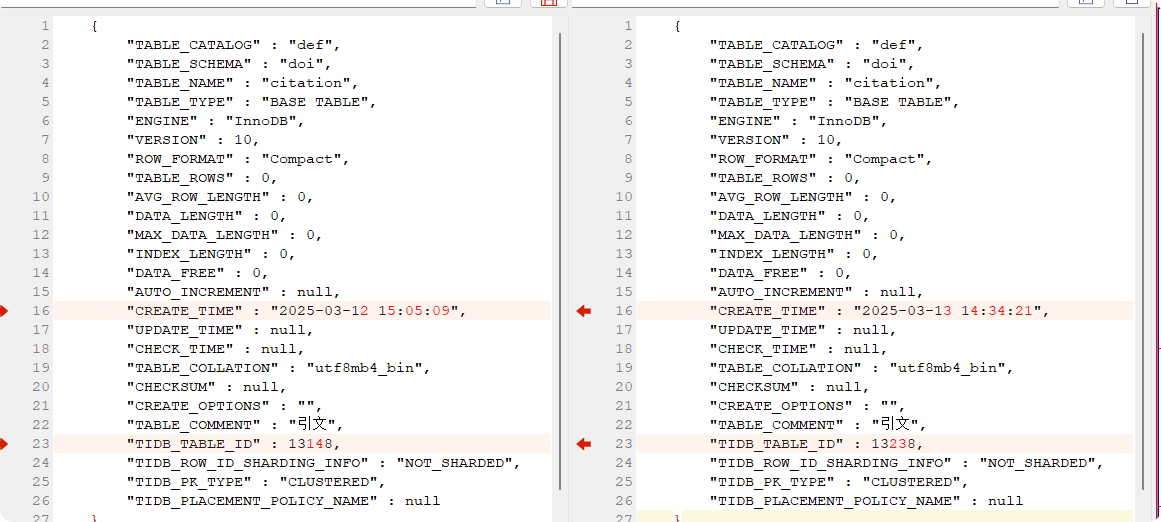

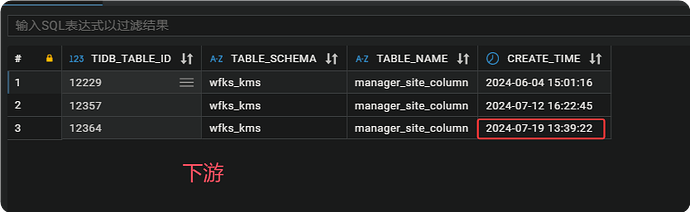

发现在上游删表重建后,下游出现了 库名.表名完全一样的表

{

"select * from INFORMATION_SCHEMA.TABLES where table_name='citation'": [

{

"TABLE_CATALOG" : "def",

"TABLE_SCHEMA" : "doi",

"TABLE_NAME" : "citation",

"TABLE_TYPE" : "BASE TABLE",

"ENGINE" : "InnoDB",

"VERSION" : 10,

"ROW_FORMAT" : "Compact",

"TABLE_ROWS" : 0,

"AVG_ROW_LENGTH" : 0,

"DATA_LENGTH" : 0,

"MAX_DATA_LENGTH" : 0,

"INDEX_LENGTH" : 0,

"DATA_FREE" : 0,

"AUTO_INCREMENT" : null,

"CREATE_TIME" : "2025-03-12 15:05:09",

"UPDATE_TIME" : null,

"CHECK_TIME" : null,

"TABLE_COLLATION" : "utf8mb4_bin",

"CHECKSUM" : null,

"CREATE_OPTIONS" : "",

"TABLE_COMMENT" : "引文",

"TIDB_TABLE_ID" : 13148,

"TIDB_ROW_ID_SHARDING_INFO" : "NOT_SHARDED",

"TIDB_PK_TYPE" : "CLUSTERED",

"TIDB_PLACEMENT_POLICY_NAME" : null

},

{

"TABLE_CATALOG" : "def",

"TABLE_SCHEMA" : "doi",

"TABLE_NAME" : "citation",

"TABLE_TYPE" : "BASE TABLE",

"ENGINE" : "InnoDB",

"VERSION" : 10,

"ROW_FORMAT" : "Compact",

"TABLE_ROWS" : 0,

"AVG_ROW_LENGTH" : 0,

"DATA_LENGTH" : 0,

"MAX_DATA_LENGTH" : 0,

"INDEX_LENGTH" : 0,

"DATA_FREE" : 0,

"AUTO_INCREMENT" : null,

"CREATE_TIME" : "2025-03-13 14:34:21",

"UPDATE_TIME" : null,

"CHECK_TIME" : null,

"TABLE_COLLATION" : "utf8mb4_bin",

"CHECKSUM" : null,

"CREATE_OPTIONS" : "",

"TABLE_COMMENT" : "引文",

"TIDB_TABLE_ID" : 13238,

"TIDB_ROW_ID_SHARDING_INFO" : "NOT_SHARDED",

"TIDB_PK_TYPE" : "CLUSTERED",

"TIDB_PLACEMENT_POLICY_NAME" : null

}

]}

这个问题与 tispark Multiple entries with same key 和 如何删除INFORMATION_SCHEMA.TABLES表里的数据 是同一情况。

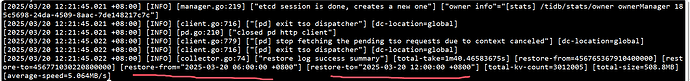

现在是数据无法写入该表,影响备份。