CREATE TABLE `waybill` (

`col_1` bigint NOT NULL,

`col_2` timestamp NULL DEFAULT NULL,

`col_3` timestamp NULL DEFAULT NULL,

`col_4` varchar(32) DEFAULT NULL,

`col_5` varchar(32) DEFAULT NULL,

`col_6` bigint DEFAULT NULL,

`col_7` bigint DEFAULT NULL,

`col_8` bigint DEFAULT '-1',

`col_9` bigint DEFAULT '-1',

`col_10` varchar(64) DEFAULT NULL,

`col_11` varchar(255) DEFAULT NULL,

`col_12` varchar(255) DEFAULT NULL,

`col_13` varchar(16) DEFAULT NULL,

`col_14` varchar(1024) DEFAULT NULL,

`col_15` varchar(1024) DEFAULT NULL,

`col_16` varchar(50) DEFAULT NULL,

`col_17` varchar(50) DEFAULT NULL,

`col_18` varchar(50) DEFAULT NULL,

`col_19` varchar(50) DEFAULT NULL,

`col_20` varchar(50) DEFAULT NULL,

`col_21` varchar(50) DEFAULT NULL,

`col_22` timestamp NULL DEFAULT NULL,

`col_23` timestamp NULL DEFAULT NULL,

`col_24` timestamp NULL DEFAULT NULL,

`col_25` timestamp NULL DEFAULT NULL,

`col_26` timestamp NULL DEFAULT NULL,

`col_27` int DEFAULT NULL,

`col_28` int DEFAULT NULL,

`col_29` int DEFAULT NULL,

`col_30` int DEFAULT NULL,

`col_31` tinyint(1) DEFAULT '1',

`col_32` timestamp NULL DEFAULT NULL,

`col_33` varchar(100) DEFAULT NULL,

`col_34` int DEFAULT '0',

`col_35` varchar(1024) DEFAULT NULL,

`col_36` varchar(255) DEFAULT NULL,

`col_37` varchar(64) DEFAULT NULL,

`col_38` varchar(64) DEFAULT NULL,

`col_39` varchar(255) DEFAULT NULL,

`col_40` bigint DEFAULT NULL,

`col_41` int DEFAULT NULL,

`col_42` timestamp NULL DEFAULT NULL,

`col_43` varchar(255) DEFAULT NULL,

`col_44` bigint DEFAULT NULL,

`col_45` varchar(255) DEFAULT NULL,

`col_46` varchar(255) DEFAULT NULL,

PRIMARY KEY (`col_1`)

/*T![clustered_index] CLUSTERED */,

KEY `index_col_10` (`col_10`) COMMENT 'index_col_10索引',

KEY `index_col_6_col_2` (`col_6`, `col_2`) COMMENT 'index_col_6_col_2索引',

KEY `index_col_11` (`col_11`(20)) COMMENT 'index_col_11索引',

KEY `index_col_14` (`col_14`(30)) COMMENT 'index_col_14索引',

KEY `index_col_12` (`col_12`(30)) COMMENT index_col_12索引',

KEY `index_col_47` (`col_47`) COMMENT 'index_col_47索引',

KEY `index_col_26` (`col_26`) COMMENT 'index_col_26索引'

) ENGINE = InnoDB DEFAULT CHARSET = utf8mb4;

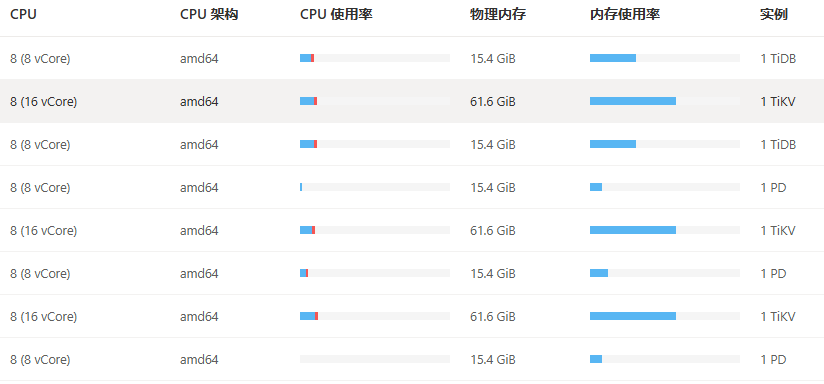

我有如上的表数据量大概在2亿 其中类型为timestamp的字段都有可能进行排序 而且其中有十五个字段左右可以参与范围查询或者点查 现在发现这么复杂的条件查询就算加上很多索引 tidb有时候也根本查不动 有什么更好的办法吗 难道对于这种复杂查询最终只能把数据放到ES进行查吗