【 TiDB 使用环境】生产环境

【 TiDB 版本】v7.5.5

【遇到的问题:问题现象及影响】

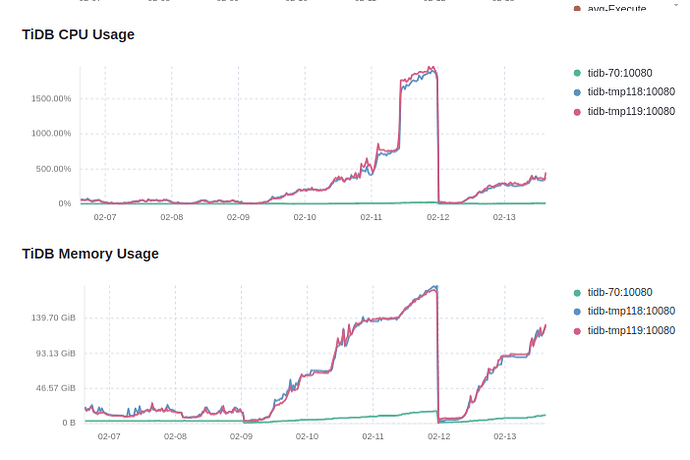

从tidb v6.5.11升级到v7.5.5后,随着运行时间的推移,tidb实例的内存和cpu不断走高,在凌晨低谷期也没有回落的趋势,影响系统正常使用.通过reload tidb节点后,内存和cpu可以降下来.

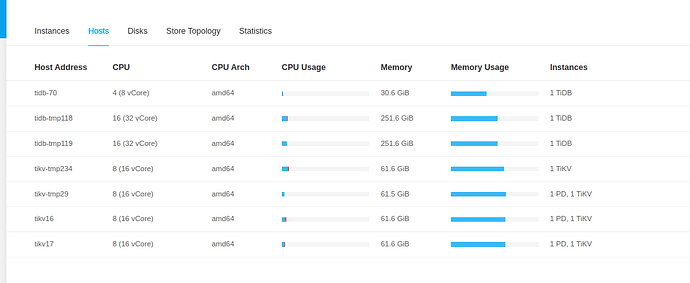

【资源配置】

【其他附件:截图/日志/监控】

2月9号凌晨进行的升级, 在2月11号23点左右内存跑了75%左右.

手工进行realod后,内存和cpu回落,2月12后到当前时间,还在持续走高.

备注: 三台tidb节点,tidb-70是低配,haproxy分配的权重很低,所以数据看着比较正常

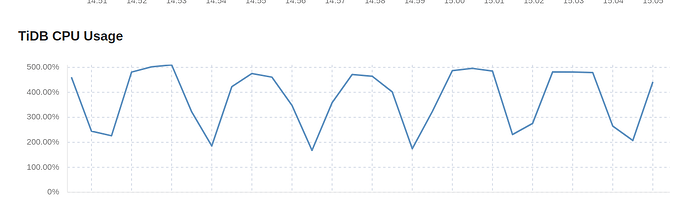

把时间范围调小,观察到cpu大概是2分半跳高一次,比较有规律.

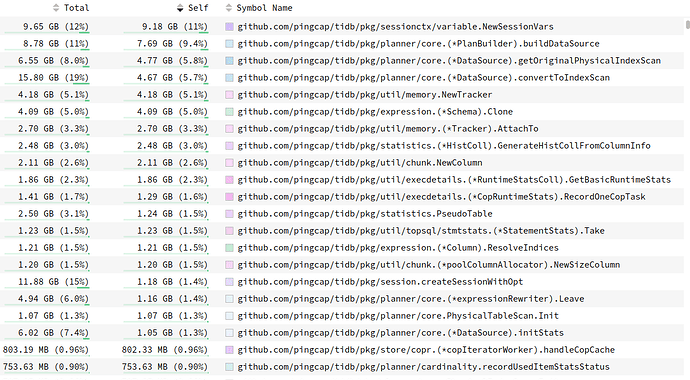

通过profiling看,内存占用

NewSessionVar 占了比较高的比例,调低应用连接数后,内存也无明显变化CPU看着gc占了比较大的比例

怀疑是存在内存泄露,导致触发gc,但gc又回收不掉,所以频繁gc