【 TiDB 使用环境】生产环境

【 TiDB 版本】v8.5.1

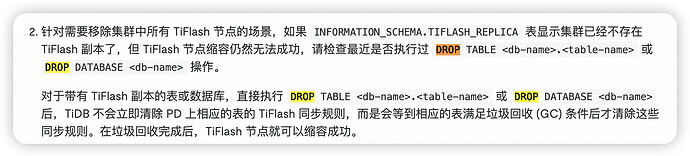

【复现路径】新建tidb v8.5.1 版本的集群,并扩容了tiflash 服务为一些表设置了 tiflash replica 1操作。后来操作吧 一个database 给drop了(drop database db_name), 在把剩余的几个存在 replica 的表replica 设置为0。过来很长时间,发现tiflash 上还是存在大量的region。

【遇到的问题:问题现象及影响】

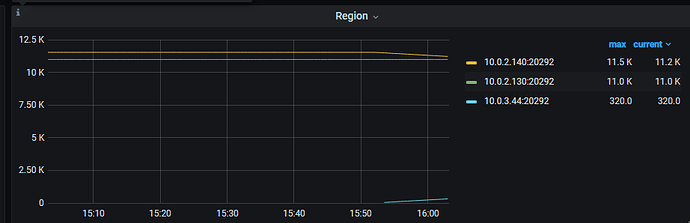

tiflash-sever 服务上存在大量region

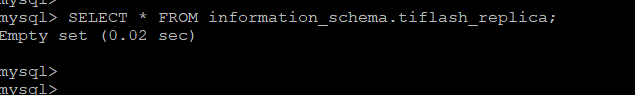

可以发现,不存在有tiflash replica的表。

【资源配置】进入到 TiDB Dashboard -集群信息 (Cluster Info) -主机(Hosts) 截图此页面

【复制黏贴 ERROR 报错的日志】

【其他附件:截图/日志/监控】