【 TiDB 使用环境】 生产环境

【 TiDB 版本】5.1/7.5

【复现路径】

TICDC 同步kafka ,遇到CDC:ErrJSONCodecRowTooLarge出错

-

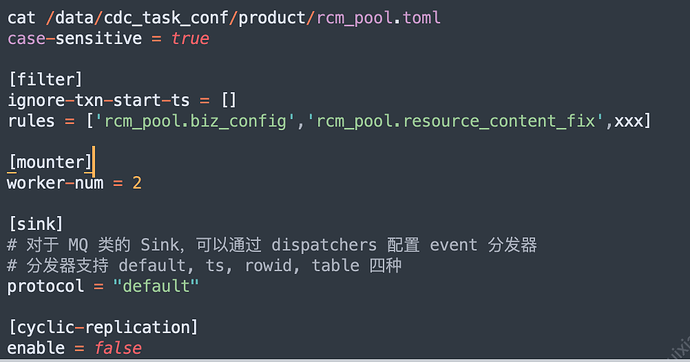

CDC创建命令

cdc cli changefeed create --config=/data/cdc_task_conf/product/rcm_pool.toml --changefeed-id=rcm-pool --pd=“http://xx:2379” --start-ts=4552xx --sink-uri=“kafka://xxx:9092/tidb_cdc_rcm_pool?kafka-version=2.2.1&partition-num=1&max-message-bytes=134217728&replication-factor=3&kafka-client-id=9be37e3319b64774800c2920fc840c3b&max-batch-size=256” -

CDC 中断时的信息

/data/cdc-8300/bin/cdc cli changefeed query -s --pd=“http://xx:2379” -c rcm-pool

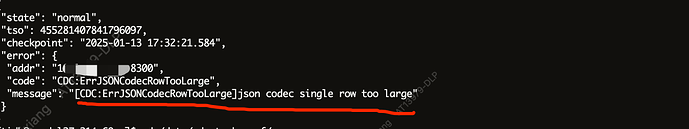

{

“state”: “normal”,

“tso”: 455281407841796097,

“checkpoint”: “2025-01-13 17:32:21.584”,

“error”: {

“addr”: “10.xx.xx.xx:8300”,

“code”: “CDC:ErrJSONCodecRowTooLarge”,

“message”: “[CDC:ErrJSONCodecRowTooLarge]json codec single row too large”

}

}

【遇到的问题:问题现象及影响】

【资源配置】

CDC配置文件:

CDC中日志:

请教下:

- 如何较好的解决ErrJSONCodecRowTooLarge问题?

- 怎么找到当时卡着的SQL命令呢?

- 和kafka同学沟通不想改大kafka max-message-bytes (10M),TICDC侧设置max-message-bytes为10M可以解决问题么?是否有大的SQL过来>10M ,而导致同步失败的情况。