db_user

2025 年1 月 16 日 09:20

1

【 TiDB 使用环境】生产进入到 TiDB Dashboard -集群信息 (Cluster Info) -主机(Hosts) 截图此页面

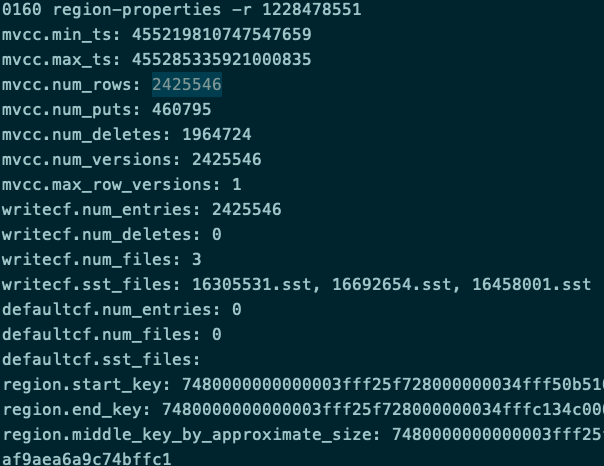

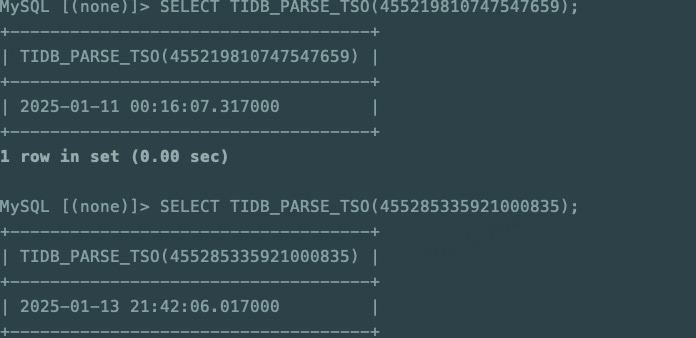

通过tikv-ctl可以查看,对应的region有gc之前的时间,所以比较诡异

1 个赞

db_user

2025 年1 月 16 日 09:27

3

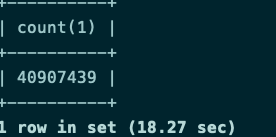

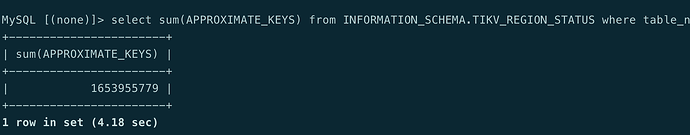

没用,我6亿个key远远超过这个阈值了,但参数我也没调,后续我再测试看看

db_user

2025 年1 月 22 日 03:05

5

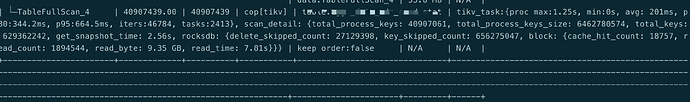

第一步调整:

set config tikv raftstore.region-compact-redundant-rows-percent=5;

第二步调整:raftstore.region-compact-check-interval=‘1m’;raftstore.region-compact-min-redundant-rows=10000;

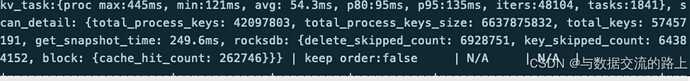

有些效果,但是最终在57457191的key上停止了

尝试关闭filter

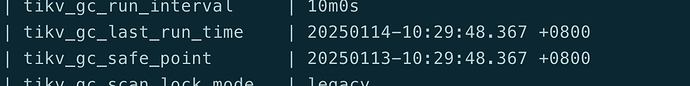

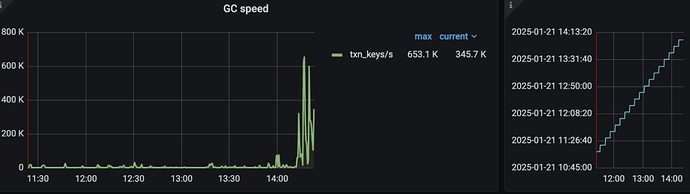

但是关闭filter之后可以看到gc的时间有明显的升高

1 个赞

zhanggame1

2025 年1 月 23 日 02:07

6

我以前测试清理是很不积极的,一张表一亿数据delete掉,几天才能清理完

有猫万事足

2025 年1 月 23 日 04:03

8

个人理解这个测试可以说明2个问题:compaction: consider redundant mvcc.delete rows to trigger Rocksdb compaction · Issue #17269 · tikv/tikv · GitHub ,不然还是不能回收),确实是提升不大了。gc时间还变长了。

是很意义的测试。

2 个赞