【 TiDB 使用环境】生产环境

【 TiDB 版本】v8.1.0

【遇到的问题:】如下图10.10.13.82主机的主板 和磁盘都坏了,主机下线维修了,上线一个新的机器IP不变怎么 恢复 集群呢?

对应的节点,直接scale in --force缩容掉之后,重新扩容吧,上面磁盘都是空的了。。。

先缩容对应对应组件,然后再执行扩容就行,注意新机器的系统参数、tidb用户、互信、磁盘初始化等等操作在扩容前要手动进行

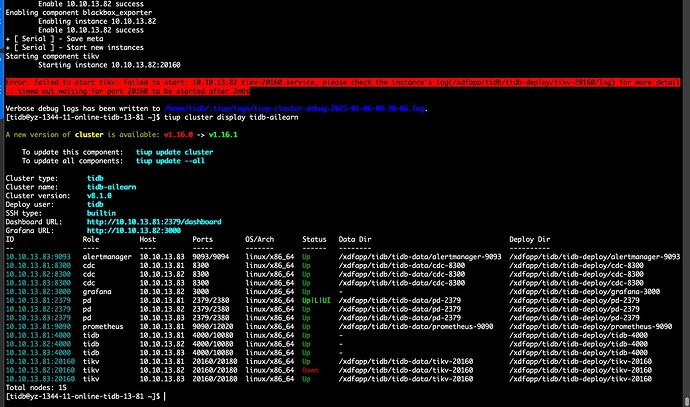

非常感谢您,按照您的方法除了tikv其他都已经恢复了。再麻烦您帮忙看下tikv的问题呢。

tikv报错如下:

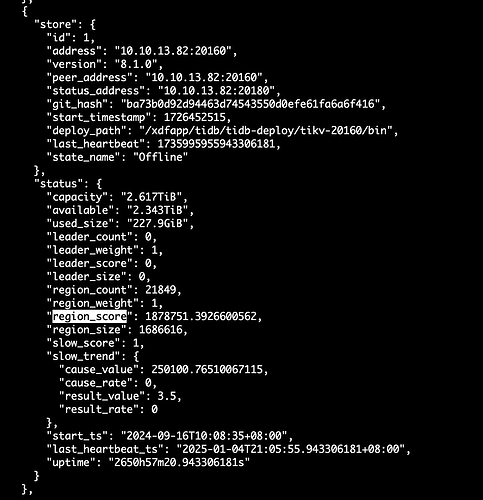

[2025/01/06 09:32:02.194 +08:00] [FATAL] [server.rs:1037] [“failed to start node: Other("[components/pd_client/src/util.rs:952]: duplicated store address: id:202791 address:\"10.10.13.82:20160\" version:\"8.1.0\" peer_address:\"10.10.13.82:20160\" status_address:\"10.10.13.82:20180\" git_hash:\"ba73b0d92d94463d74543550d0efe61fa6a6f416\" start_timestamp:1736127122 deploy_path:\"/xdfapp/tidb/tidb-deploy/tikv-20160/bin\" , already registered by id:1 address:\"10.10.13.82:20160\" version:\"8.1.0\" peer_address:\"10.10.13.82:20160\" status_address:\"10.10.13.82:20180\" git_hash:\"ba73b0d92d94463d74543550d0efe61fa6a6f416\" start_timestamp:1726452515 deploy_path:\"/xdfapp/tidb/tidb-deploy/tikv-20160/bin\" last_heartbeat:1735995955943306181 node_state:Serving ")”] [thread_id=1]

提示还能识别到这个地址的tikv信息,原来那个节点缩容没缩干净? pd-ctl 的 看下原来的store 还在吗?在的话 store delete命令删除掉

pd-ctl 命令的用法帮助文档 可以 发一下吗?

82上端口冲突了上去看看可能没清干净

没迁移问题不大,有多副本,服务器都不在了,直接干掉,元数据干净后, 重新扩容,自动平衡。

store delete 执行了之后 还是 如上截图啊,没又干掉呢。需要什么操作 才能干掉呢

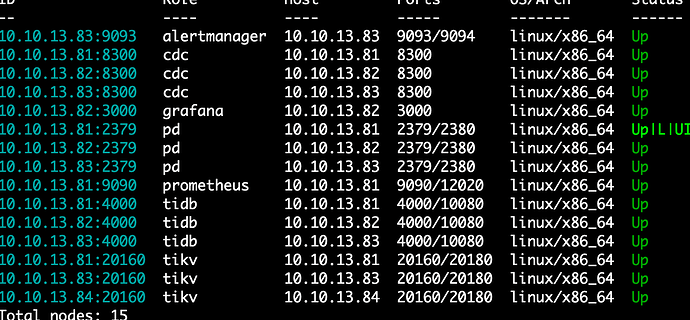

你只有2个kv了 节点数小于3了,region不会迁移,你得先扩容一个kv节点。

我遇到过你这一样的场景,那时候写了个文章,你看下。

操作有风险,慎用。

非常感谢

此话题已在最后回复的 7 天后被自动关闭。不再允许新回复。