DBRE

1

【 TiDB 使用环境】生产环境

【 TiDB 版本】v5.1.1

【遇到的问题:问题现象及影响】

TiCDC 同步任务推进可能停滞的bug有哪些?或者有哪些临时方案规避掉?升级到高版本的建议就不要提了,暂时升不了。

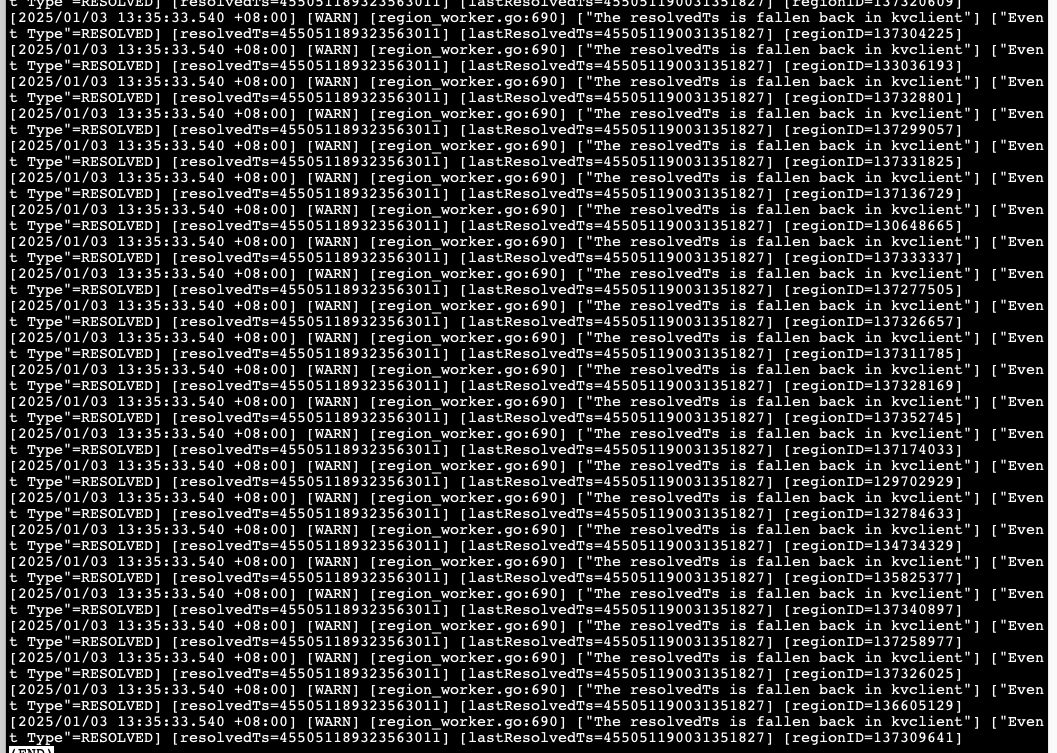

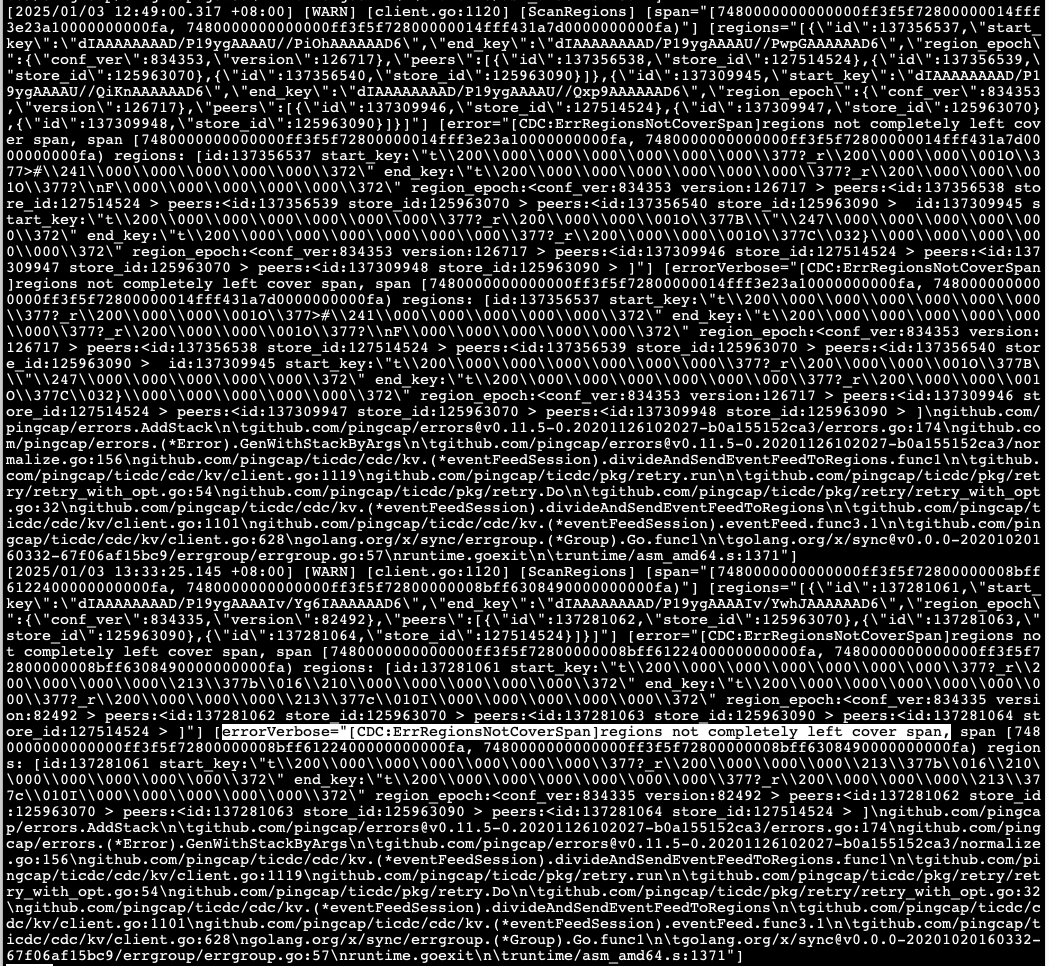

最近遇到一个case,ticdc 写kafka任务的checkpoint一直不推进,如下图:

cdc节点有大量的这种日志:

[2025/01/03 13:35:33.540 +08:00] [WARN] [region_worker.go:690] [“The resolvedTs is fallen back in kvclient”] [“Event Type”=RESOLVED] [resolvedTs=455051189323563011] [lastResolvedTs=455051190031351827] [regionID=137309641]

找到了几个bug,看起来不是很符合

1、 * 修复当上游 TiDB 实例意外退出时,TiCDC 同步任务推进可能停滞的问题 #3061

2、 * 修复当写入 Kafka 消息发生错误时,TiCDC 同步任务推进可能停滞的问题 #2978

小龙虾爱大龙虾

(Minghao Ren)

2

你要是 5.1.1 就升级,6.5.12 应该会好很多

TiDBer_小杰

(Ti D Ber L33ess Xj)

4

遇到过就两个:

- 大事务处理 :TiCDC 对大事务(大小超过 5 GB)提供部分支持,可能导致主从同步延迟增高、同步任务报错

ErrBufferReachLimit 或内存溢出 (OOM)

- GC safepoint 阻塞:如果 TiCDC 同步任务停滞时间过长,会导致上游 TiKV 集群的 GC safepoint 长时间不推进,保留的旧数据版本过多,进而影响上游集群性能。如果同步任务延迟超过

gc-ttl 所设置的值,那么该同步任务就会进入 failed 状态,并报 ErrGCTTLExceeded 错误,无法被恢复,不再阻塞 GC safepoint 推进。

临时解决就是 在启动 TiCDC server 时指定 gc-ttl 的值和拆分大事务

2 个赞

kang

5

v5.1.1

确实有点老,现在都8了,升一下吧,最起码也到6版本会好很多,到时候看看还存在不