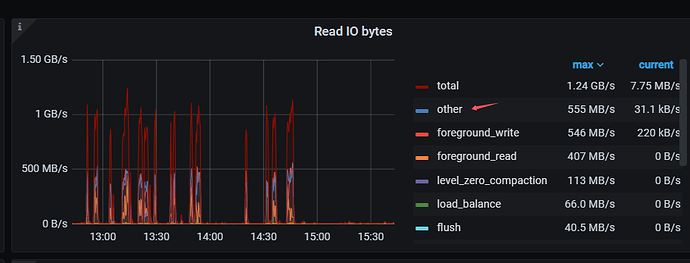

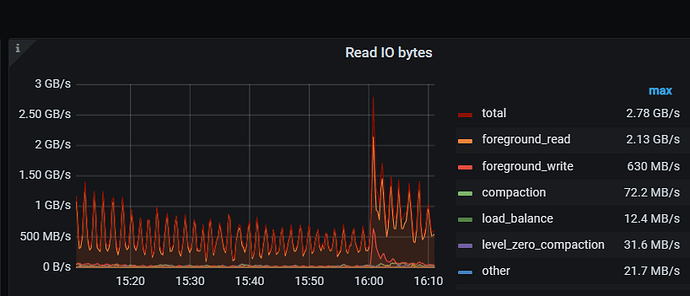

tikv detail中的IO break down 中读IO监控中other io 占到了一半

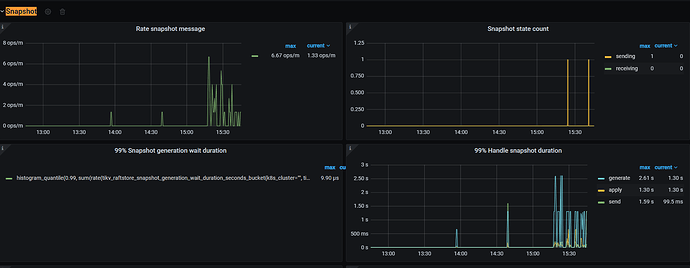

snapshot没有明显活动

这个问题是这样

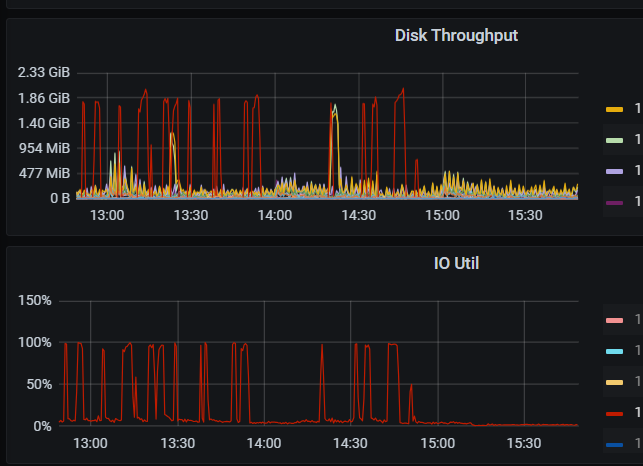

1、有一个tikv(v7.5.1)的IO 偶尔会被打的比较高,普通ssd

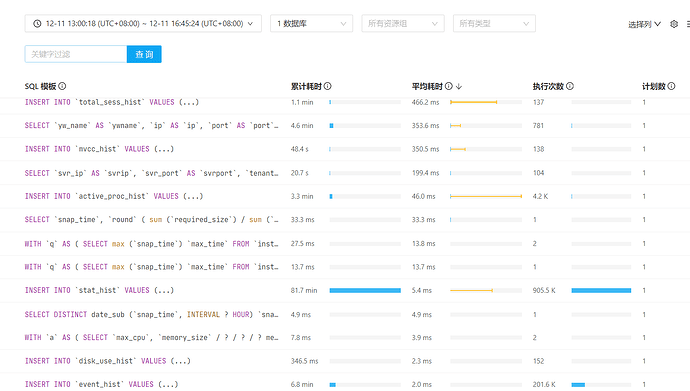

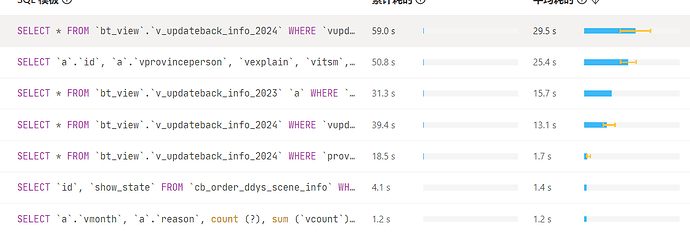

2、检查了io breakdown , 发现读IO中other io比较高,见开始的2张图

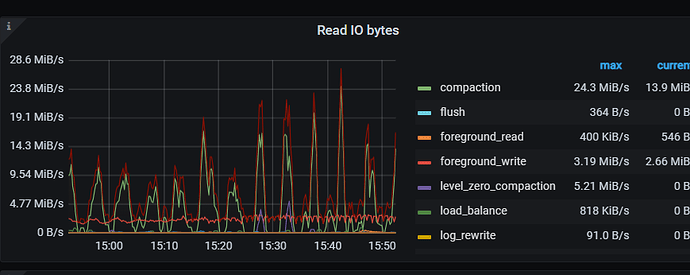

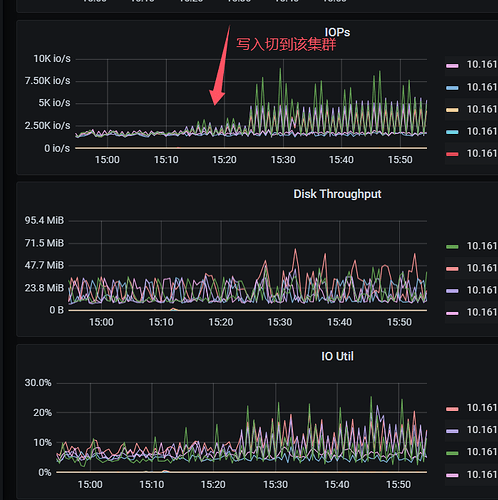

3、15:15左右将一个主要监控数据insert写入的程序指向了另一套8.1.1版 ,原来的v7.5.1集群的没有出现过IO打满的情况, other io 也降到k级别。

4、检查8.1.1集群 IO 发现IO 没有像原来那样高

5、检查v7.5.1集群改程序的sql,虽然有些select但都是毫秒级的,应该不会引起1GB+的读流量 ,也没有搜到慢SQL , IO高的磁盘 仅tikv使用。

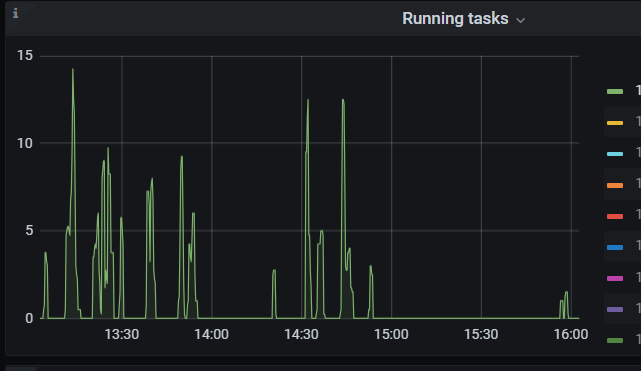

6、 v7.5.1的 unifeid read pool的 task数量和read io增高基本一致。这些应该和另一个程序的select有关

问题:

1、 io breakdown中other io 包含哪些具体的IO统计?

2、 迁移insert程序后 other/foreground_write的读IO下降,迁移到新的8.1.1后也没有对应增长,如果是热点region 集中在那一个tikv的话 ,无论是写入还是读取 有foreground_write/foreground_read 两个统计,应该也不是热点region问题?

另外一套 写入量比较高的7.5.4 read other也比较低