【 TiDB 使用环境】测试环境

【 TiDB 版本】v7.5.1

【遇到的问题:问题现象及影响】

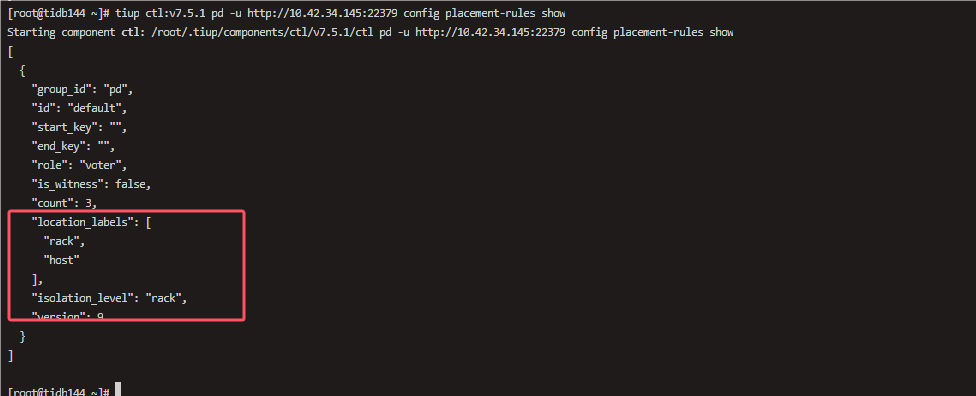

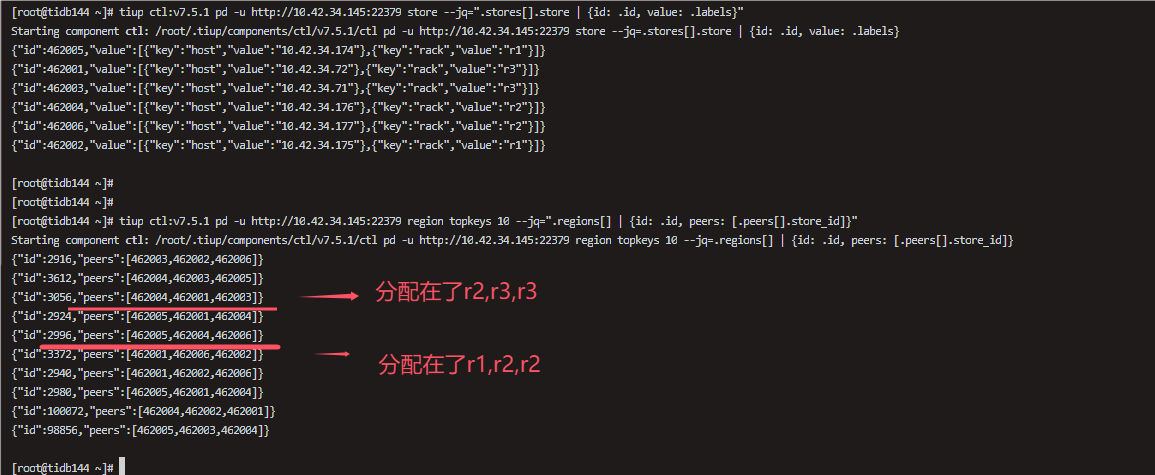

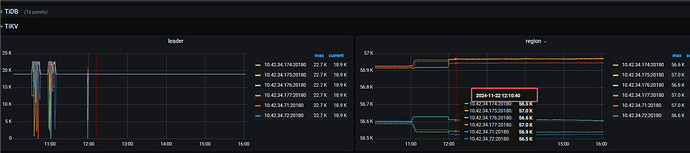

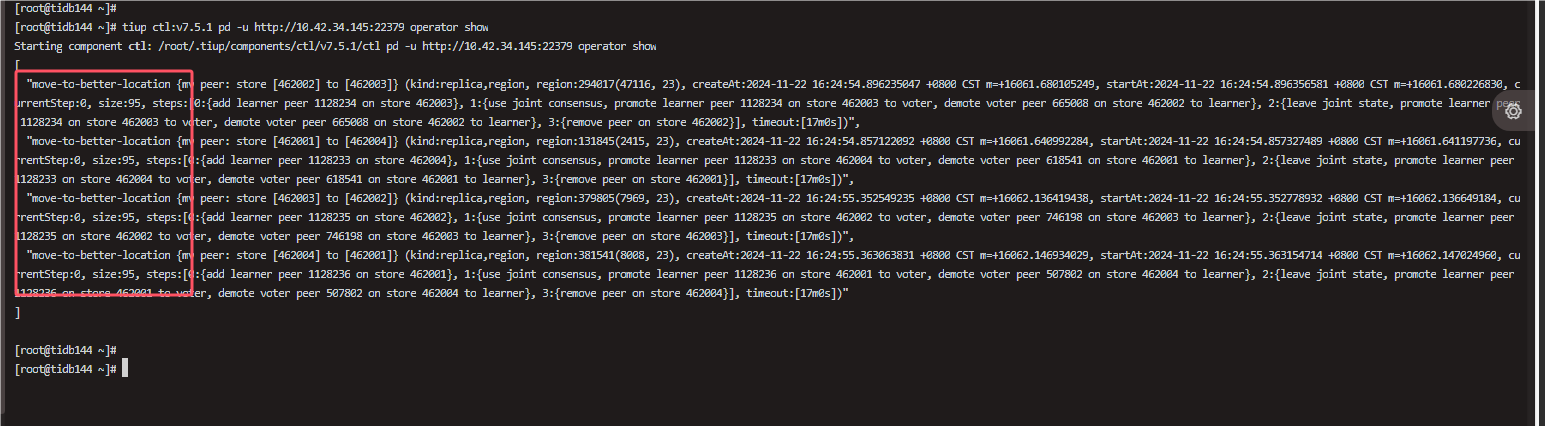

新增了Tikv的标签和pd的标签以及隔离级别,按照官网多AZ的说法,我的region会按照pd的隔离级别进行分别分配到pd隔离级别所限制的tikv中,实际操作下来,有部分并没有分配到pd隔离级别所限制的tikv上

【操作过程】

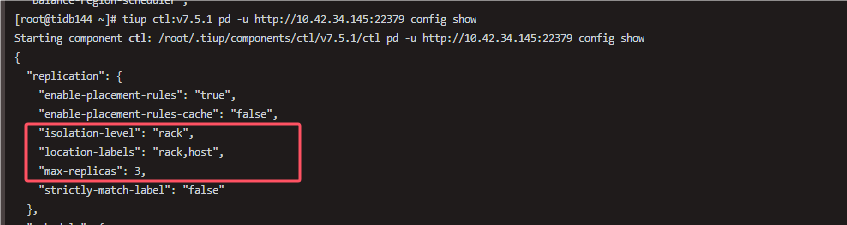

设置pd的location-label为rack,host

tiup ctl:v7.5.1 pd -u http://10.42.34.145:22379 config set location-labels rack,host

设置pd的isolation-level为rack

tiup ctl:v7.5.1 pd -u http://10.42.34.145:22379 config set isolation-level rack

新增tikv和pd的标签配置

tiup cluster edit-config tidbname

server_configs:

pd:

replication.enable-placement-rules: true

isolation-level: rack

replication.location-labels:

- host

- rack

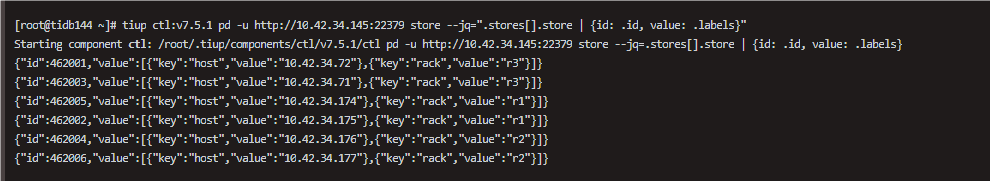

tikv_servers:

- host: 10.42.34.71

config:

server.labels: { rack: “r1”, host: “10.42.34.71” } - host: 10.42.34.72

config:

server.labels: { rack: “r1”, host: “10.42.34.72” } - host: 10.42.34.174

config:

server.labels: { rack: “r2”, host: “10.42.34.174” } - host: 10.42.34.175

config:

server.labels: { rack: “r2”, host: “10.42.34.175” } - host: 10.42.34.176

config:

server.labels: { rack: “r3”, host: “10.42.34.176” } - host: 10.42.34.177

config:

server.labels: { rack: “r3”, host: “10.42.34.177” }

加载配置

tiup cluster reload tidbname -R tikv,pd

重启tidb集群

tiup cluster restart tidbname -R tikv,pd

【验证操作】