【 TiDB 使用环境】生产环境 /测试/ Poc

【 TiDB 版本】 8.1.1

【复现路径】做过哪些操作出现的问题

【遇到的问题:问题现象及影响】

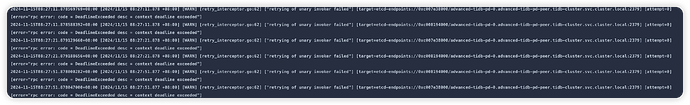

Tidb 与 PD WARN

2024-11-14T17:43:49.458253571+08:00 [2024/11/14 17:43:49.458 +08:00] [WARN] [retry_interceptor.go:62] [“retrying of unary invoker failed”] [target=etcd-endpoints://0xc008194000/advanced-tidb-pd-0.advanced-tidb-pd-peer.tidb-cluster.svc.cluster.local:2379] [attempt=0] [error=“rpc error: code = DeadlineExceeded desc = context deadline exceeded”]

检查网络和实例资源使用情况,看更详细的日志分析下情况。

Kongdom

(Kongdom)

3

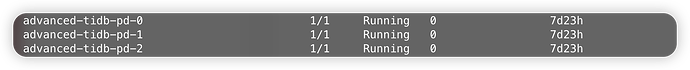

display看一下集群状态,有没有节点down掉

资源这块也是比较正常的吧 日志没有其他的就是同一条日志

好的 感谢

还有一个问题就是

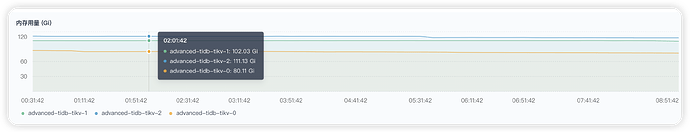

进行数据迁移之后 tikv 的内存不会进行释放占用一直很高 这个有没有什么解决方案

可以配置下参数storage.block-cache.capacity,建议不超过机器内存的60%

好的感谢 调整过了 我这边再监控一下看看是否还存在问题

关于监控这块

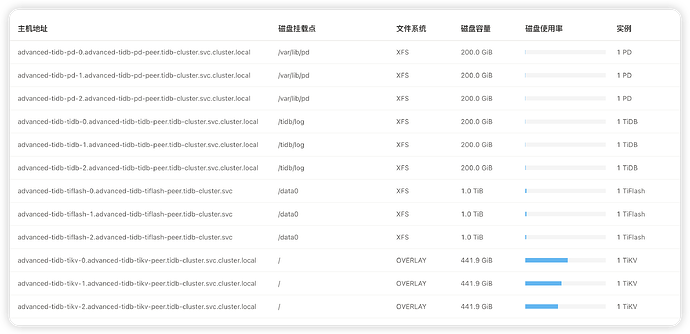

tikv监控点是根目录并非挂载的 pvc 这个有办法进行调整嘛 ?

Kongdom

(Kongdom)

10

数据迁移的多么?会不会是tikv在做副本均衡? 看看grafana的region监控,看看个节点的region是否均衡

还真没关心过这个挂载点怎么显示的。平时服务器的基础监控我都看另外的监控不看这个dashboard。

好的 我这边观察一下grafana 前段时间做初始数据导入的时候差不多导入了7到8e左右的数据的时候内存一直在 200+ 一直都是导入完成后做重启动作来进行释放的

ok 了解了 不过也不影响 只是刚好就问问看 之前刚开始安装的时候以为挂载的有问题 后面排查发现没问题就是这个显示的不对

system

(system)

关闭

14

此话题已在最后回复的 7 天后被自动关闭。不再允许新回复。