vcdog

2024 年10 月 30 日 01:54

1

【 TiDB 使用环境】生产环境

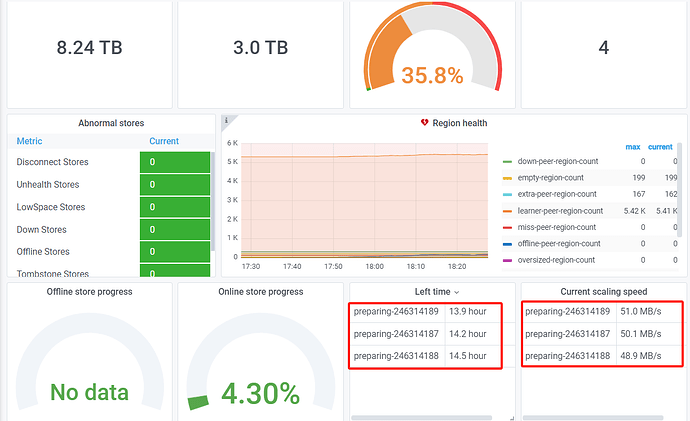

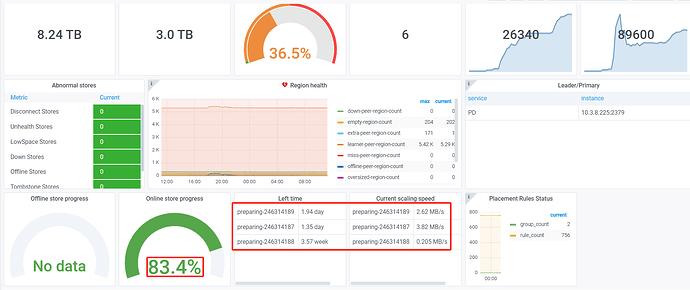

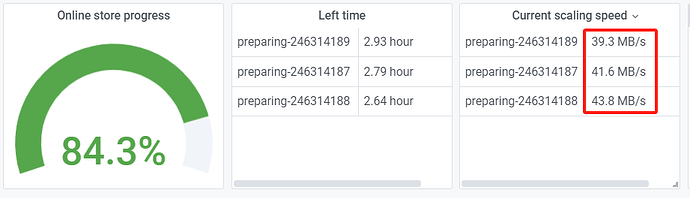

2.图2:今天早上09点时的状态:

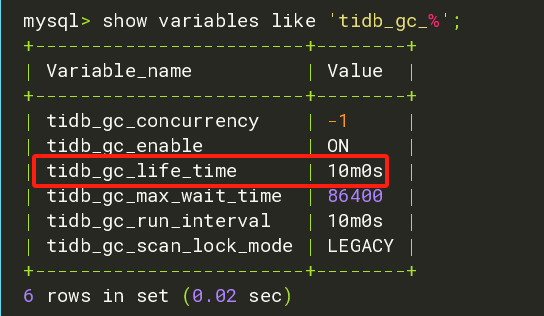

3.图3:gc配置:

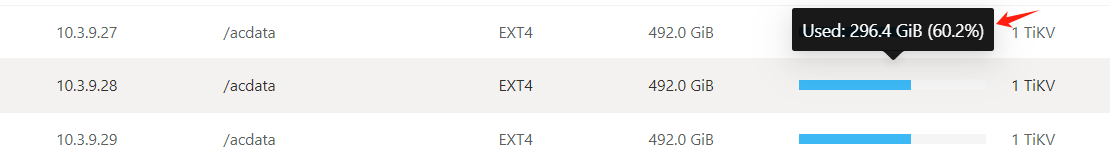

【资源配置】进入到 TiDB Dashboard -集群信息 (Cluster Info) -主机(Hosts) 截图此页面

h5n1

2024 年10 月 30 日 02:02

3

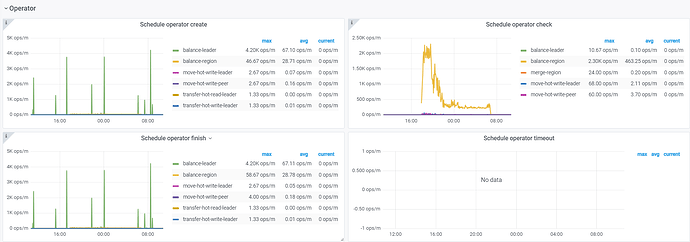

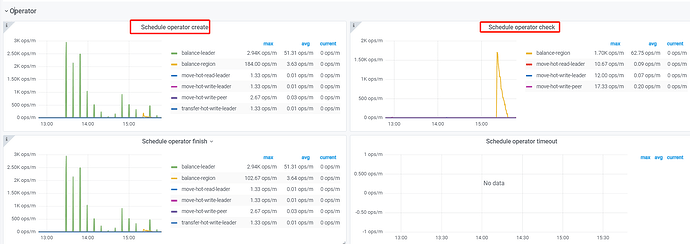

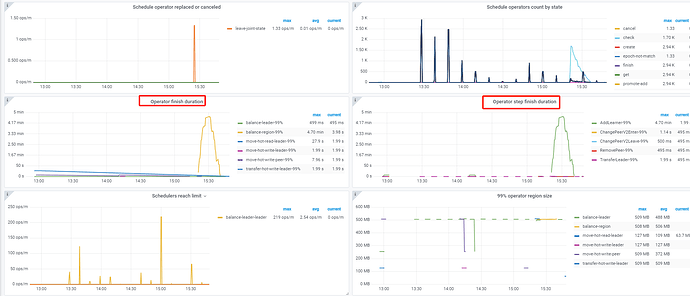

看下pd监控的operator产生和消费正常吗。正常的话先试试调大调度参数 pd-ctl config set 调整 replica-schedule-limit ,max-pending-peer-count 以及 max-snapshot-count 。 pd-ctl store limit all xx 增大store limt。

直接加了三个节点?我都是一个个加的,不着急的话还是慢慢等他迁移平衡,磁盘消耗过大容易影响集群稳定性

vcdog

2024 年10 月 30 日 02:47

7

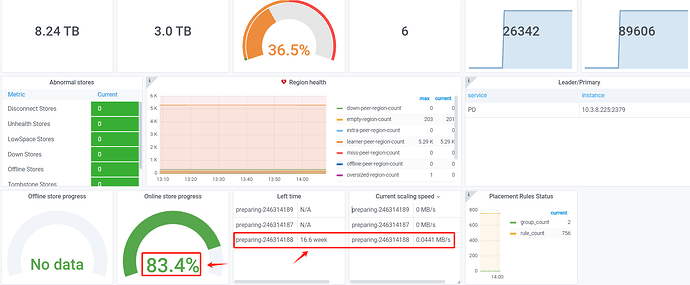

我看最开始磁盘的读写速度是50M/s,现在变成了0.007M/s

vcdog

2024 年10 月 30 日 03:03

8

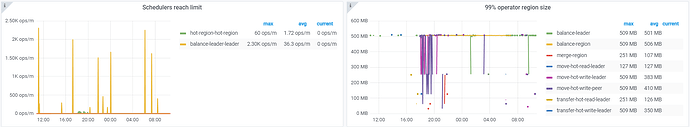

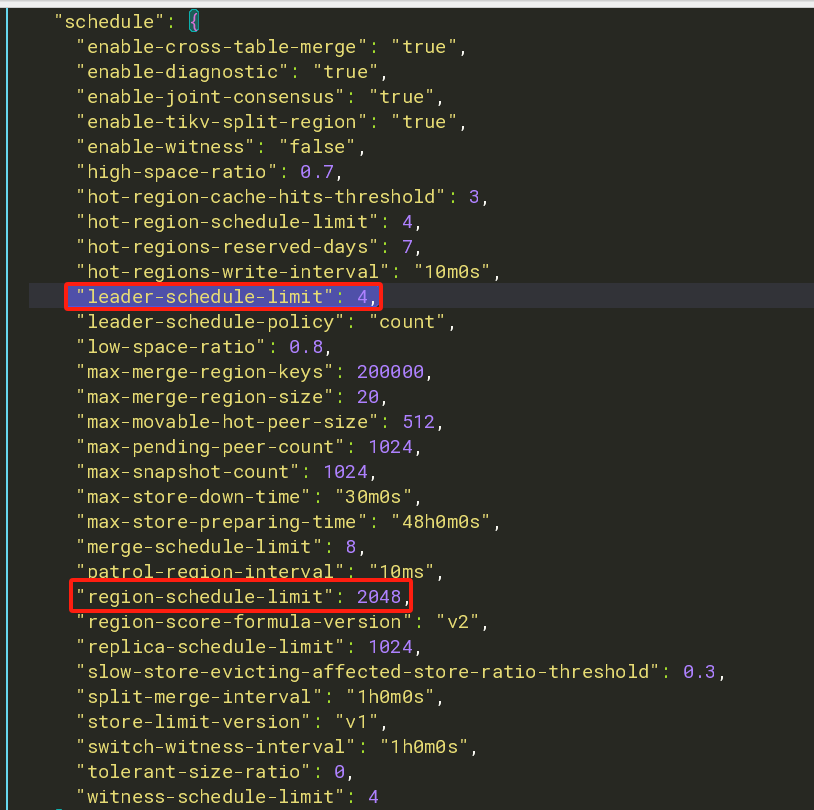

当磁盘空间达到一定比例(例如 80% 或更高)时,PD 会优先考虑不向该节点迁移新的 Region,以避免空间耗尽的风险。这一行为是基于调度策略中 high-space-ratio 和 low-space-ratio 参数的设置:

high-space-ratiolow-space-ratio

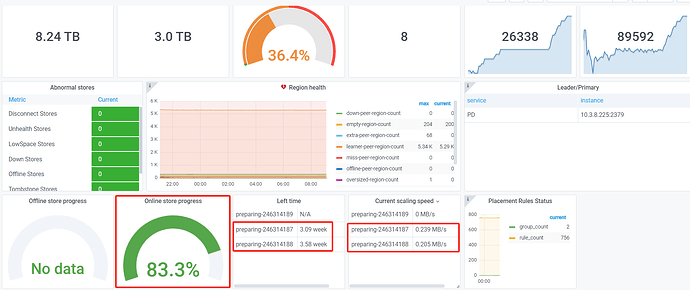

会不会跟这个有关系,目前,新扩容的3个tikv节点磁盘空间,占用在60%不再增长了。

vcdog

2024 年10 月 30 日 04:02

10

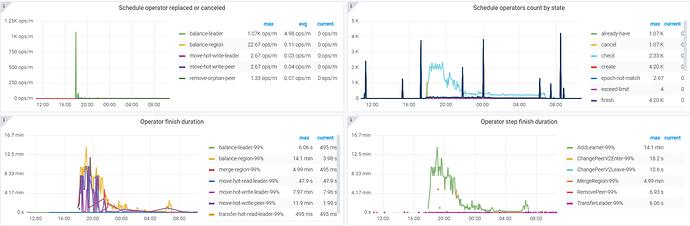

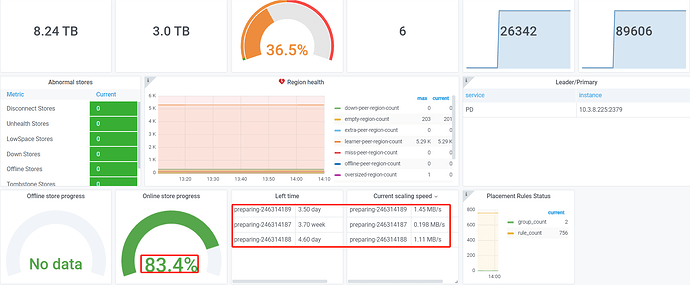

调整了这几个参数,后续我这边再观察一下,迁移的进度:

tiup ctl:v7.5.4 pd -u http://10.3.8.227:2379 config set max-pending-peer-count 1024

tiup ctl:v7.5.4 pd -u http://10.3.8.227:2379 config set max-snapshot-count 1024

tiup ctl:v7.5.4 pd -u http://10.3.8.227:2379 config set replica-schedule-limit 1024

tiup ctl:v7.5.4 pd -u http://10.3.8.227:2379 store limit all 100

vcdog

2024 年10 月 30 日 06:11

12

还是不太明显,:

过30秒刷新一下,显示会有些不同。说明还是有进度,只是不快

h5n1

2024 年10 月 30 日 06:19

13

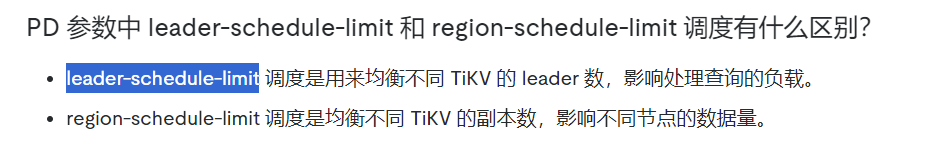

试试把leader-schedule-limit 调到一个很小的值 比如1 ,减少这类调度和balacne region的争抢,但有可能会导致tikv cpu利用率不均衡

vcdog

2024 年10 月 30 日 07:24

15

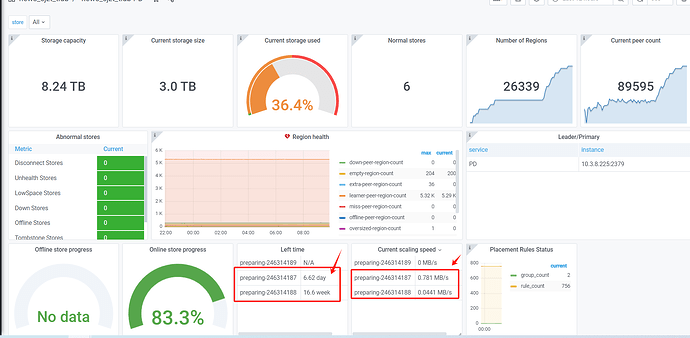

tiup ctl:v7.5.4 pd -u http://10.3.8.227:2379 config set high-space-ratio 0.8http://10.3.8.227:2379 config set low-space-ratio 0.90

调整这两个参数后,速率一下子就上来了。

舞动梦灵

2024 年10 月 30 日 07:35

16

。。这两个是磁盘百分比的,你这是之前的磁盘用的量太大了吧