vcdog

(Vcdog)

1

【 TiDB 使用环境】生产环境

【 TiDB 版本】版本升级v6.5.0->v7.5.3

【复现路径】做过哪些操作出现的问题

【遇到的问题:问题现象及影响】

昨天晚上进行了整个主库集群的升级(v6.5.0->v7.5.3)

1、升级过程中,一切顺利,升级结束后,reload整个集群。

2、检查各组件服务状态运行一切正常。

3、通过脚本检查cdc的任务同步状态也是normal。

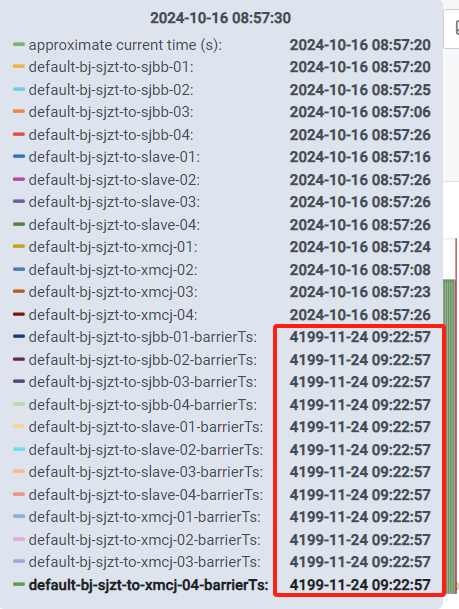

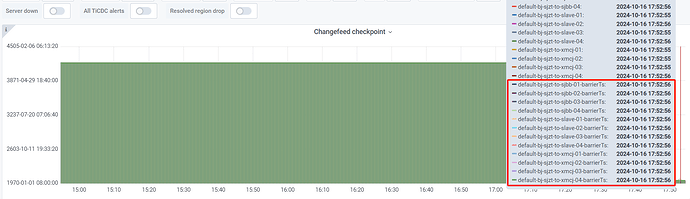

今天到公司打开grafana的监控页面,发现出现了如下图的穿越时间:

【资源配置】进入到 TiDB Dashboard -集群信息 (Cluster Info) -主机(Hosts) 截图此页面

【附件:截图/日志/监控】

想问下各位大佬,有没有遇到过类似的问题。

小龙虾爱大龙虾

(Minghao Ren)

3

vcdog

(Vcdog)

5

目前来看,不影响cdc的任务正常同步。就是看着这个时间有点异常。如何能让这个时间回到正常时间,是不是只有缩容再扩容prometheus或grafana呢

小龙虾爱大龙虾

(Minghao Ren)

6

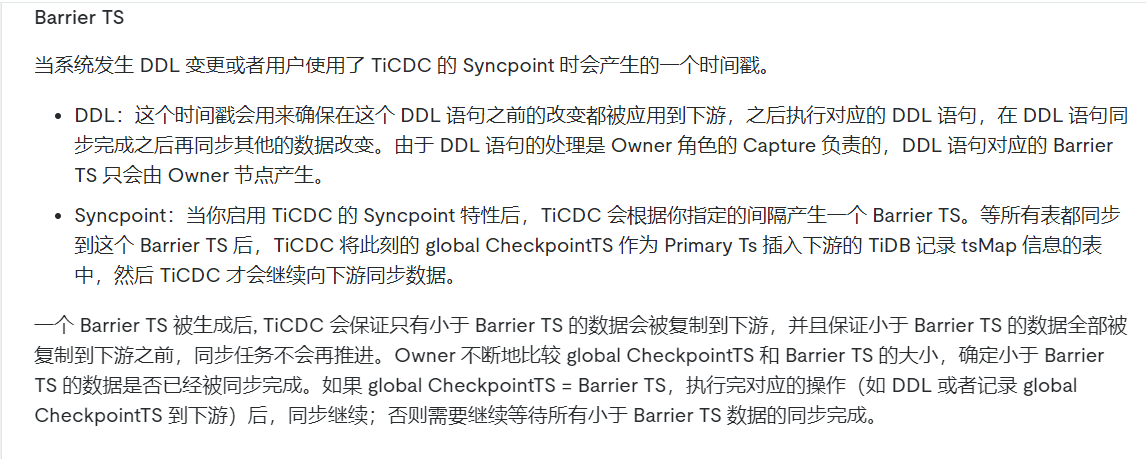

现在这种 4199 年就是正常的,意思是不阻塞 cdc 执行各种东西,当它变小时,用来阻塞大于它 commit ts 的事务复制,用来对其同步点位

PS:如果你就是看着这个监控不顺眼,就自己改下表达式就好了,扩缩容没有用的

1 个赞

vcdog

(Vcdog)

7

那就先不调整了,等再升级另外一套主库集群里,再看看有没有类似的问题。

当前升级的这套集群角色比较特殊,既是上游主库的从库,又是下游3套从库的主库。

vcdog

(Vcdog)

11

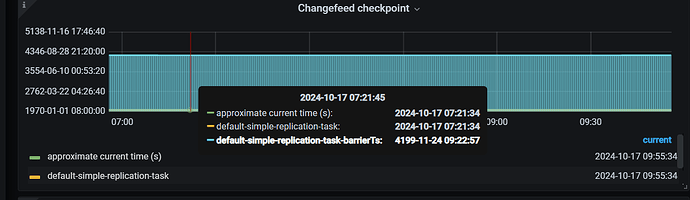

已经确认是tidb的bug。升级v7.5.4后,这个监控展示问题正常。

1 个赞

zhanggame1

(Ti D Ber G I13ecx U)

12

我这个7.5.2版本重启了下cdc就这样了,不过没啥影响

vcdog

(Vcdog)

13

建议升级到v7.5.4版本,这个时间展示问题,会自动修复。