【 TiDB 使用环境】 测试

【 TiDB 版本】v7.5.3

【复现路径】 tikv 新增store后数据恢复最大只能调整到200【store limit all 200】,超过200后报有最大限制,对于单台服务器4个tikv实例【每个实例2.5tb容量】,这个总恢复速度会达到7~8小时,想问下这个还有加速的空间么? 感觉速度还是很慢

【遇到的问题:问题现象及影响】

【资源配置】进入到 TiDB Dashboard -集群信息 (Cluster Info) -主机(Hosts) 截图此页面

【附件:截图/日志/监控】

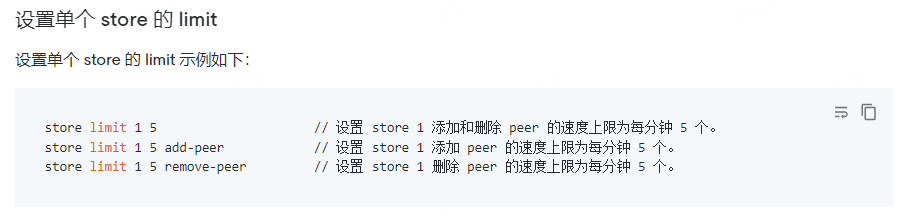

store limit all 200,你可以设置单个store 的 limit

单个最大也是200吧

有最佳实战么? 如果指定store恢复还挺麻烦的

pd-ctl看下这几个参数现在的大小是多少,先把这个适当调整

region-schedule-limit

replica-schedule-limit

leader-schedule-limit

max-pending-peer-count

max-snapshot-count

merge-schedule-limit

单个不止200

schedule.region-schedule-limit = 16384

schedule.leader-schedule-limit = 128

schedule.max-pending-peer-count = 512

schedule.max-snapshot-count = 512

schedule.replica-schedule-limit = 4096

schedule.merge-schedule-limit = 64

那就建议你指定上线的那个store add-peer调整大一点

我测试下,非常感谢

这种么?

store limit all 只能设置200,想超过这个限制的话,需要单独设置每个store的limit;

store limit 1 1000 add-peer

store limit 2 1000 add-peer

store limit 3 1000 add-peer

store limit 4 1000 add-peer

上面是把store的add-peer设置成1000

可以设置单个 store 的添加和删除 peer 的速度上限:store limit <store_id>

等我回去验证下试试,感谢大神

此话题已在最后回复的 7 天后被自动关闭。不再允许新回复。