【 TiDB 使用环境】生产环境 /测试/ Poc

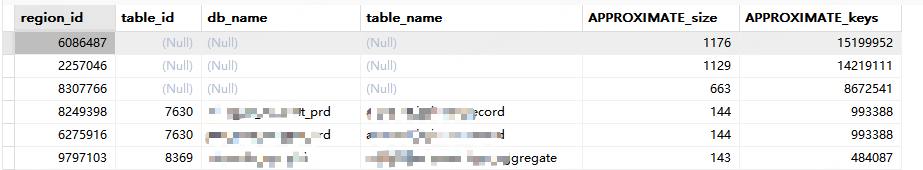

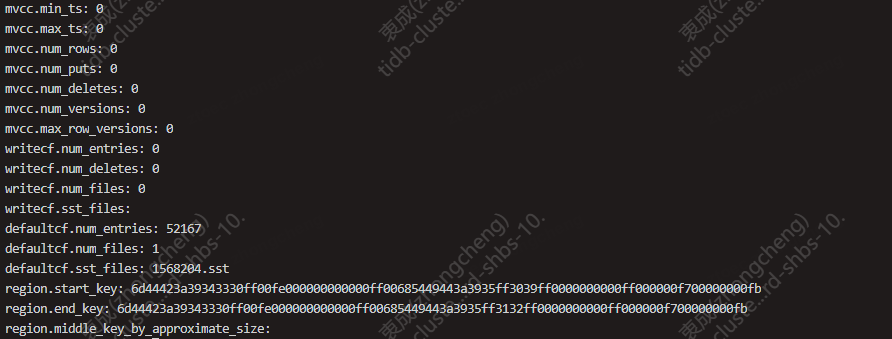

其中一个region信息感觉很异常如下

手动operator add split-region xxx --policy=approximate 后并没有效果。

要不单独针对这个region做下compact试下?

有猫万事足

2024 年9 月 25 日 11:46

3

问题已解决,最终定位原因是该表在频繁大批量写入和删除背景下导致MVCC版本堆积无法被gc,加索引时扫描key非常慢。

处理方式:关闭gc filter in compaction特性,约4小时左右rocksdb中的无效key(3亿+)全部清除完毕,加索引恢复正常。

备选方案:手动对该表做compact(未验证,理论可行)

相似问题:

和这个问题类似,尝试关闭gc filter in compaction特性。

https://docs.pingcap.com/zh/tidb/stable/garbage-collection-configuration#gc-in-compaction-filter-机制

kevinsna

2024 年9 月 26 日 04:31

5

TiDB集群的GC filter in compaction特性是可以在在线状态下关闭的。这个特性从TiDB 5.0版本开始引入,其作用是在RocksDB的compaction过程中进行GC,避免了单独的GC线程,减少了对IO和CPU的消耗,提高了GC的效率。 在关闭GC filter in compaction 后,可能需要更频繁地使用手动compaction来刺激RocksDB的compaction工作,尤其是在执行大量删除操作后

那感觉关了之后反而变麻烦了,我其实是想问手动compaction会有啥影响不??还有就是不理解我这3个region为什么对象是NULL,并且region的大小还在变动(会增会减),假设是因为drop或者delete导致region对象是NULL,那应该大小不会变了才对吧