【 TiDB 使用环境】生产环境

【 TiDB 版本】8.1

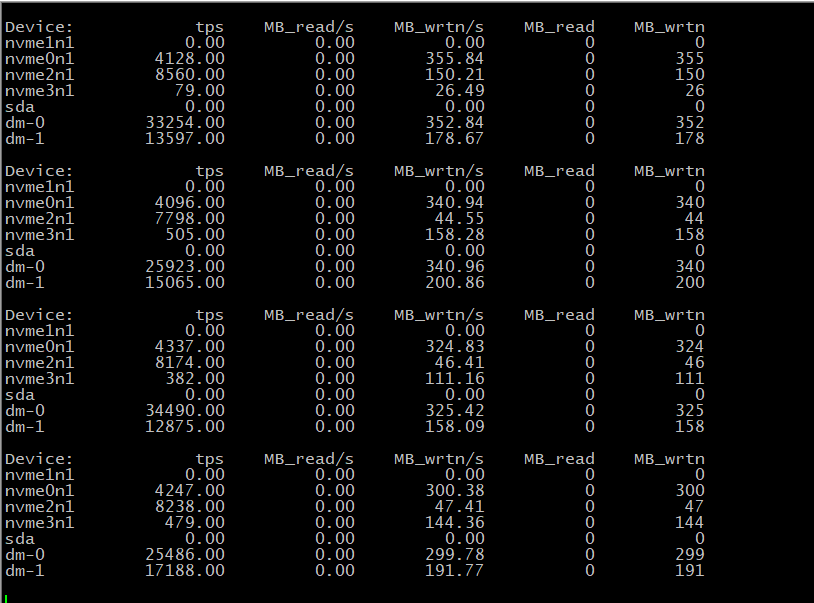

【复现路径】新搭建的tidb8.1集群,1台中控机[普通服务器,千兆带宽],3个pd+tidb [普通服务器,千兆带宽,3台都是40线程,256G内存普通盘],3个tikv服务器【每台服务器上/data ,/data1 分别一个tikv节点,共6个节点,万兆带宽,1台服务是80线程/512g内存,另外2台是48线程/512g内存, /data/和/data1 分别是3T】

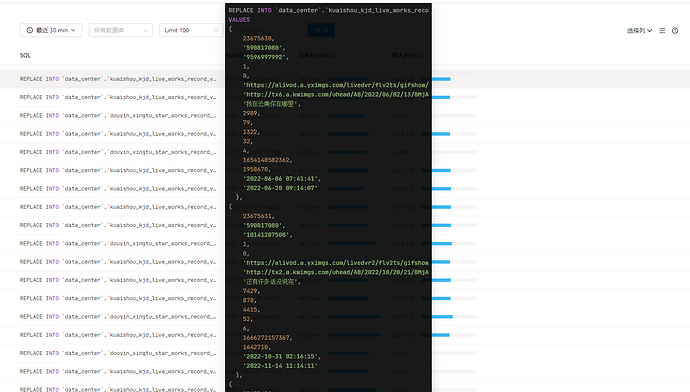

【遇到的问题:我有2个集群,一个是20年左右 搭建的4.0,最近刚搭建了一个8.1,想要把4.0的数据,备份并且导入到8.1的版本中,由于有几个大表 有140G左右,然后我让大数据的同事 使用 SeaTunnel 工具从旧的tidb往新的tidb,测试写入数据(140G)的大表,持续了几分钟,每秒写入8k,往旧的tidb写入是每秒2s,也包括往doris写入 也是每秒2s,doris服务器还是普通的服务器呢,求各位大佬 帮忙看看】

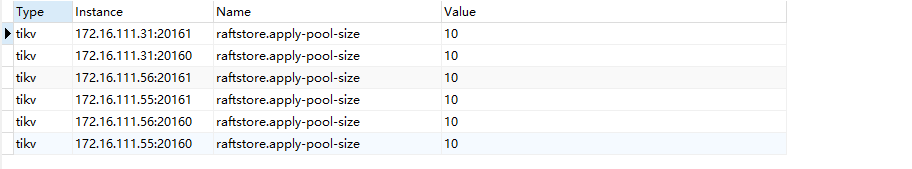

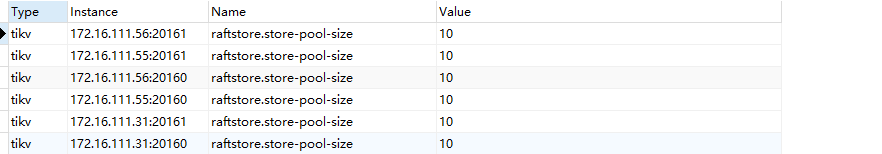

【资源配置】以下是我的参数配置

server_configs:

tidb:

log.slow-threshold: 300

performance.txn-entry-size-limit: 12582912

performance.txn-total-size-limit: 1073741824

tikv:

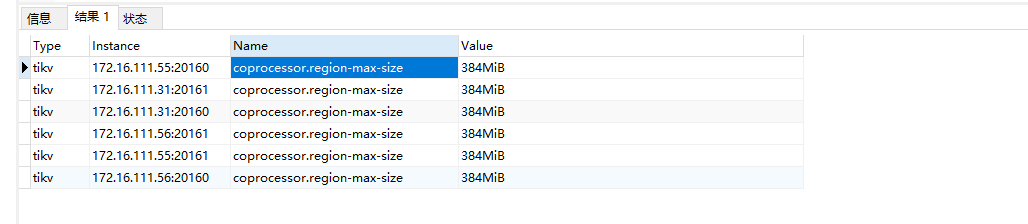

coprocessor.region-max-size: 384MB

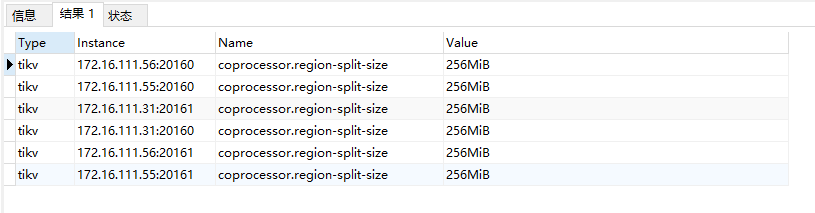

coprocessor.region-split-size: 256MB

readpool.coprocessor.use-unified-pool: true

readpool.storage.use-unified-pool: true

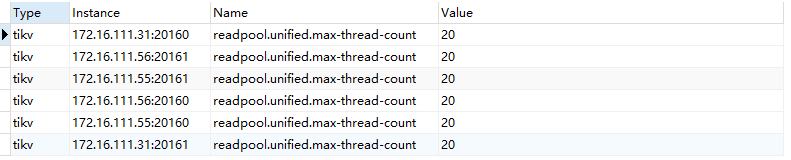

readpool.unified.max-thread-count: 20

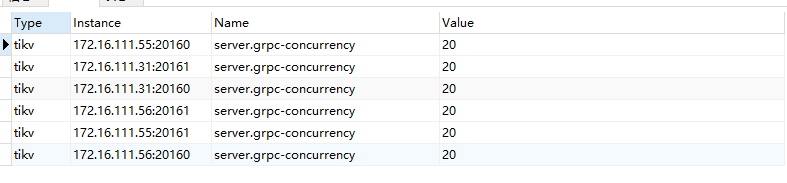

server.grpc-concurrency: 20

storage.block-cache.capacity: 128G

pd:

replication.location-labels:

- host

schedule.leader-schedule-limit: 4

schedule.region-schedule-limit: 2048

schedule.replica-schedule-limit: 64

其中某一台tikv

tikv_servers:

- host: 172.16.111.31

ssh_port: 22

port: 20160

status_port: 20180

deploy_dir: /data/tidb-deploy/tikv-20160

data_dir: /data/tidb-data/tikv-20160

log_dir: /data/tidb-deploy/tikv-20160/log

numa_node: “0”

config:

server.labels:

host: 172.16.111.31

arch: amd64

os: linux - host: 172.16.111.31

ssh_port: 22

port: 20161

status_port: 20181

deploy_dir: /data1/tidb-deploy/tikv-20161

data_dir: /data1/tidb-data/tikv-20161

log_dir: /data1/tidb-deploy/tikv-20161/log

numa_node: “1”

config:

server.labels:

host: 172.16.111.31

arch: amd64

os: linux

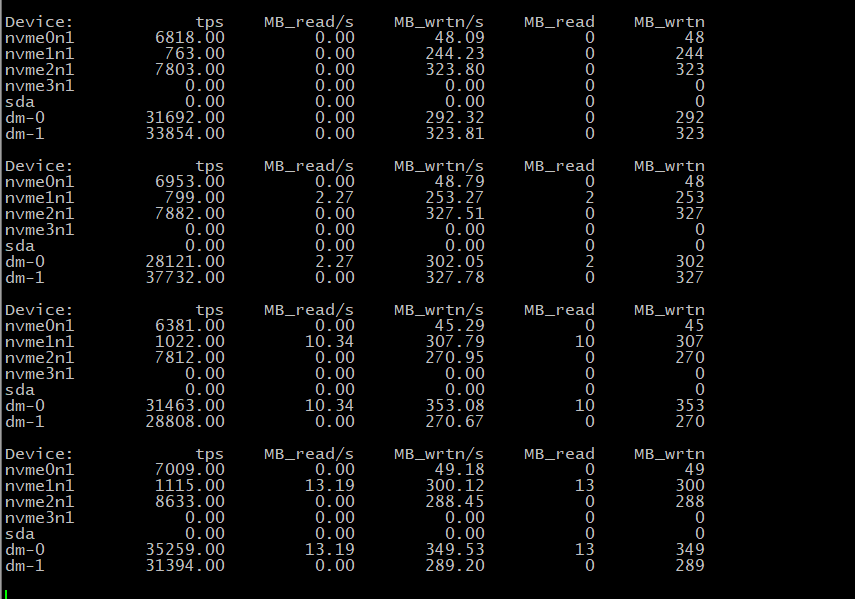

【附件:截图/日志/监控】