【 TiDB 使用环境】生产环境 /测试/ Poc

【 TiDB 版本】

【复现路径】做过哪些操作出现的问题

【遇到的问题:问题现象及影响】

【资源配置】进入到 TiDB Dashboard -集群信息 (Cluster Info) -主机(Hosts) 截图此页面

【附件:截图/日志/监控】

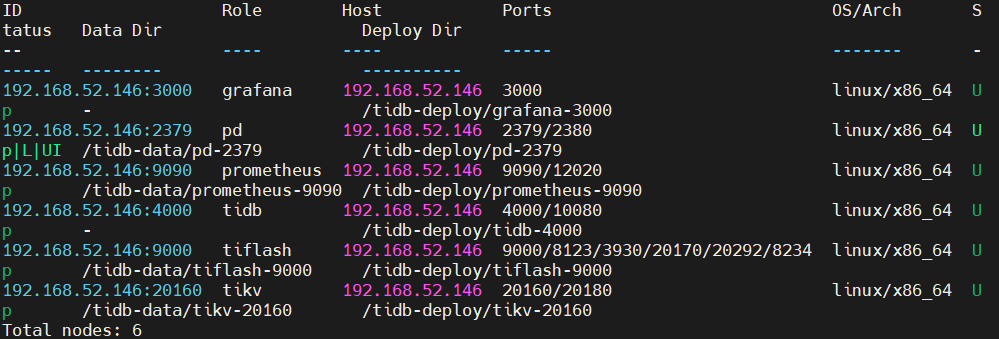

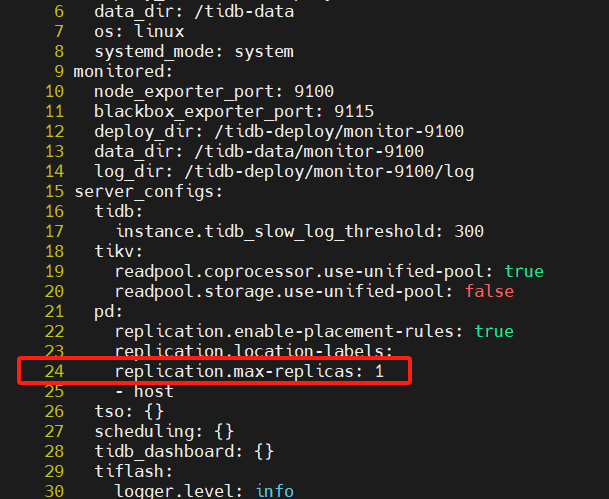

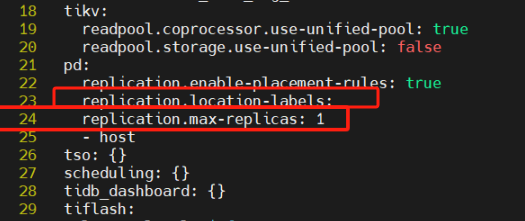

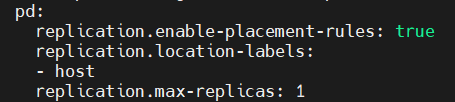

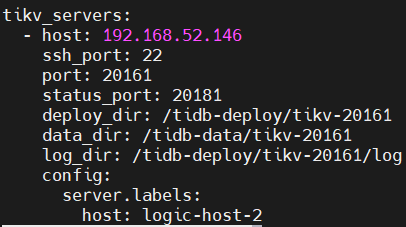

新手使用扩缩容操作,前置条件是已使用tiup cluster部署了最小化的集群(pd、db、kv都只有一个实例),如下截图

在此基础上执行扩容操作,扩容对象对kv,yaml配置如下

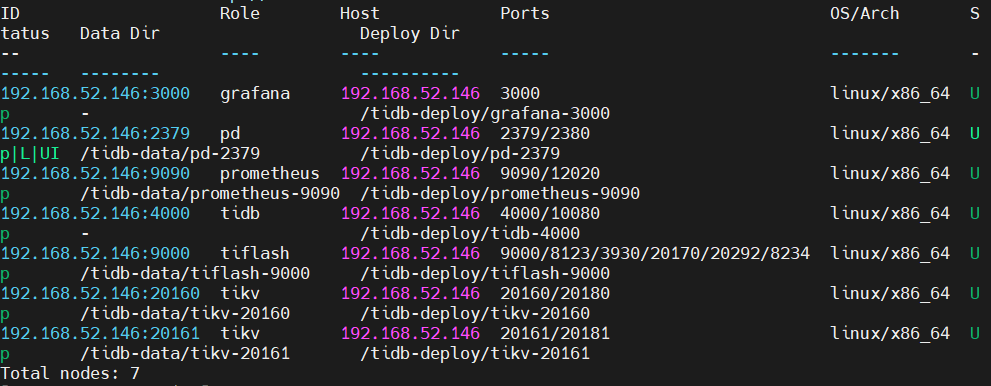

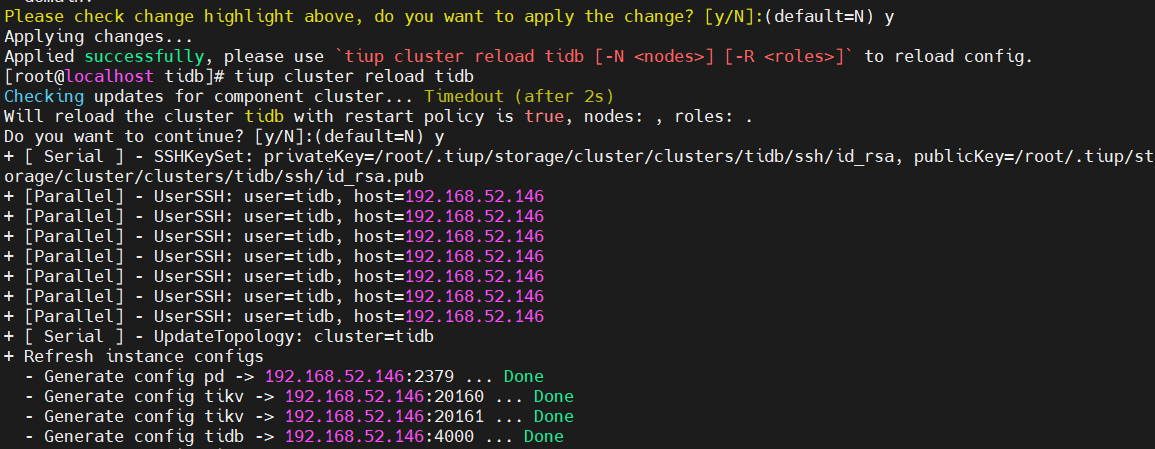

执行tiup cluster scale-out命令报错,但成功将kv进行了扩容。

执行后状态如下图

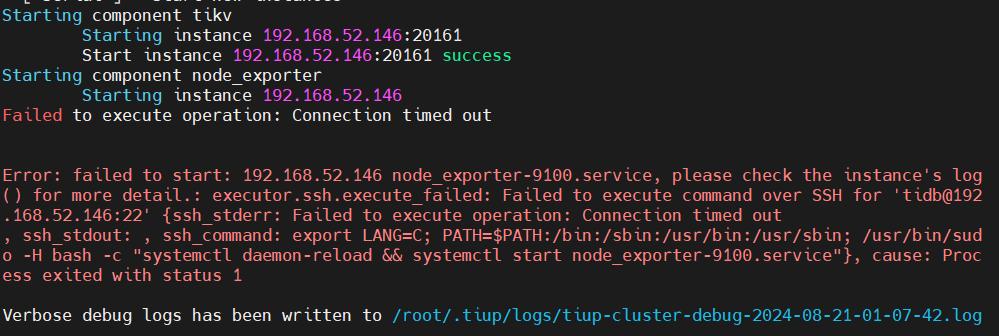

报错如下图

猜测原因:是因为我扩容的实例也部署在主控节点,所以那两组件已经运行过了,无法再次启动,实际看进程也确实存在,望大佬指正是否这个原因。

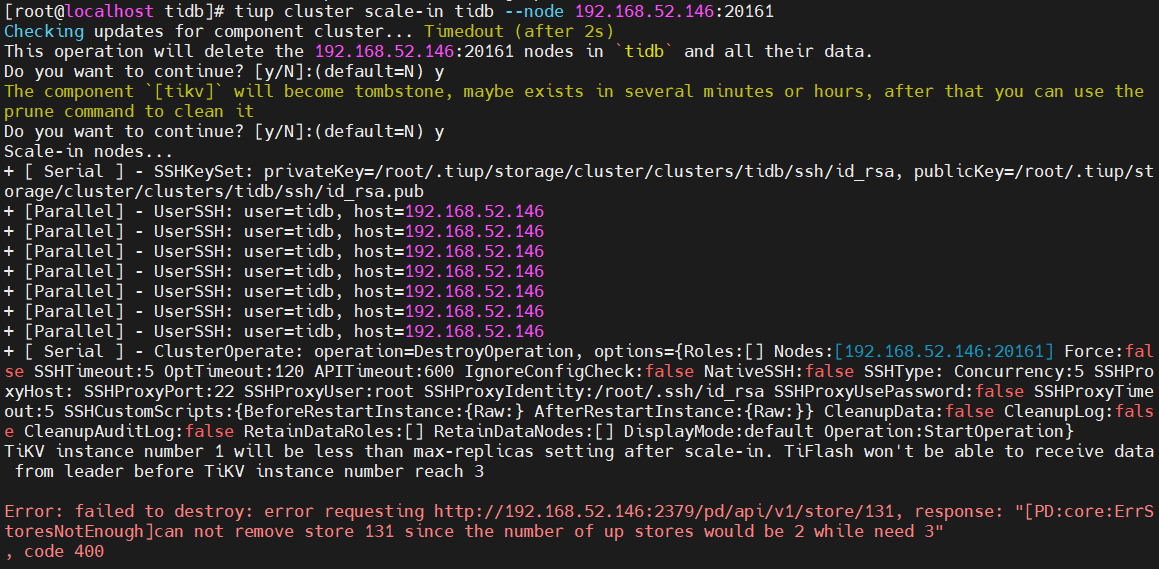

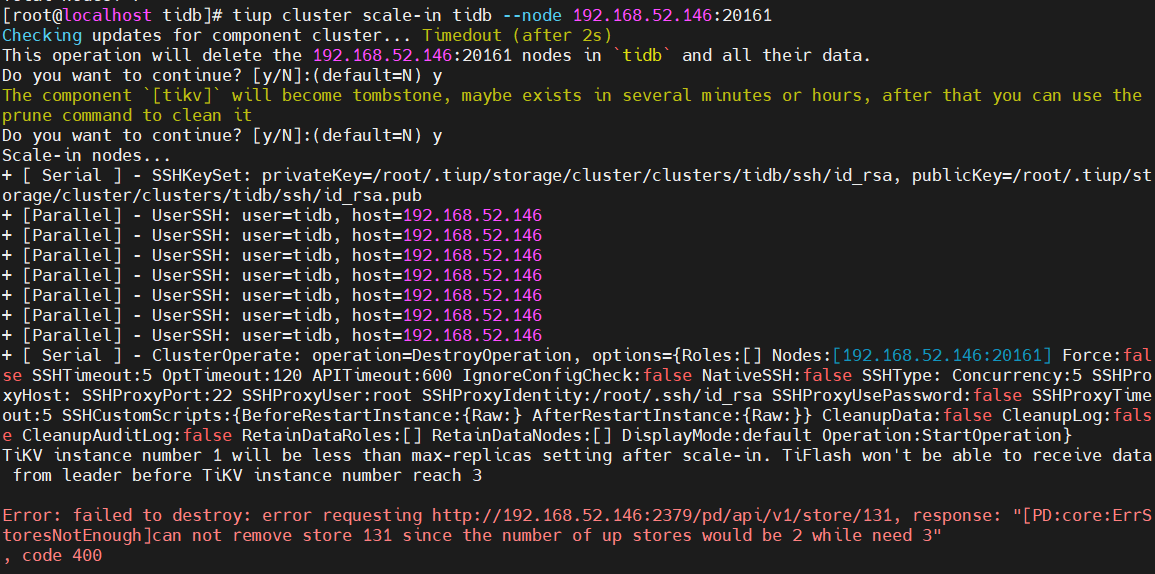

以下才进入本贴求助的正文,在此基础上进行缩容操作却报错了,如下所示

错误提示也很直观,至少需要3个实例,但现在只有2个,不允许缩容,虽能理解但有点奇怪,就这种情况能解决吗?