【 TiDB 使用环境】测试

【 TiDB 版本】

【复现路径】

先执行了扩容,然后再进行的缩容,仍然卡着就说不过去了。

【遇到的问题:问题现象及影响】

TiKV节点缩容不掉,通常遇到的情况:

- 1、经常遇到的情况是:3个节点的tikv集群缩容肯定会一直卡着,因为没有新节点接受要下线kv的region peer。

- 2、另外就是除缩容tikv外,剩下的KV硬盘使用情况比较高,到达schedule.high-space-ratio=0.6的限制,导致该tikv的region无法迁移。

【资源配置】进入到 TiDB Dashboard -集群信息 (Cluster Info) -主机(Hosts) 截图此页面

【附件:截图/日志/监控】

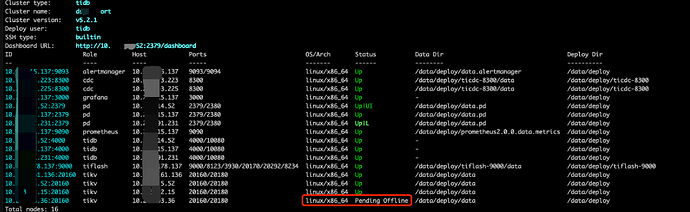

版本:TiDB v5.2.1 情况说明:这个tidb是有tiflash节点的,并且这个集群是一路从3.X升级到5.2.1版本 问题现场:为了下线一个3kv集群中的一个kv,我们在24号扩容了一个新kv,然后扩容完毕后,下线某个kv,都过了2天,该kv还是处于pending offline的状态,看监控leader+reigon已经切走了,为啥该kv的状态仍然没有tombstone?

下图是扩容和缩容tikv的监控,从下图可以发现扩容和缩容都已经完毕了。